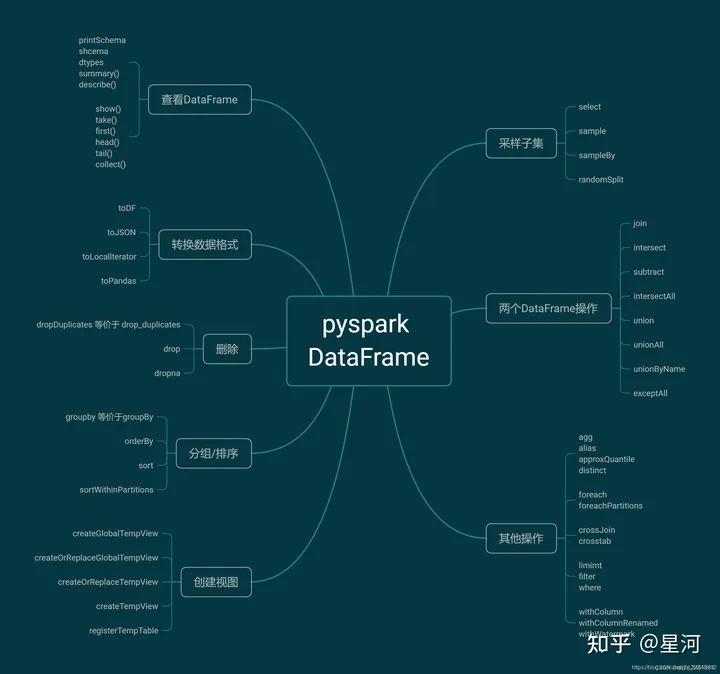

Spark中使用DataFrame进行数据转换和操作

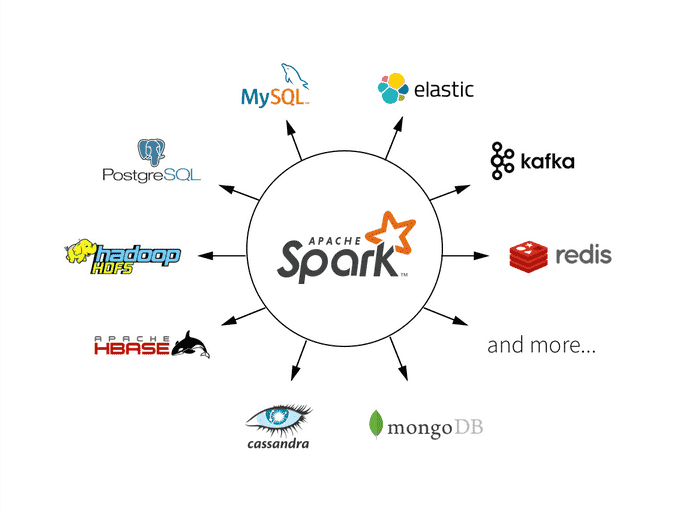

Apache Spark是一个强大的分布式计算框架,其中DataFrame是一个核心概念,用于处理结构化数据。DataFrame提供了丰富的数据转换和操作功能,使数据处理变得更加容易和高效。本文将深入探讨Spark中如何使用DataFrame进行数据转换和操作,包括数据加载、数据筛选、聚合、连接和窗...

Spark的核心概念:RDD、DataFrame和Dataset

Apache Spark,其核心概念包括RDD(Resilient Distributed Dataset)、DataFrame和Dataset。这些概念构成了Spark的基础,可以以不同的方式操作和处理数据,根据需求选择适当的抽象。 RDD(Resilient Distributed Datase...

Spark中的DataFrame和Dataset有什么区别?请解释其概念和用途。

Spark中的DataFrame和Dataset有什么区别?请解释其概念和用途。在Spark中,DataFrame和Dataset是两个重要的数据抽象层。它们都是用于表示分布式数据集的高级数据结构,提供了更高级别的API和更丰富的功能,相比于RDD更加方便和高效。首先,让我们来了解一下DataFra...

Spark_Day07:Spark SQL(DataFrame是什么和数据分析(案例讲解))

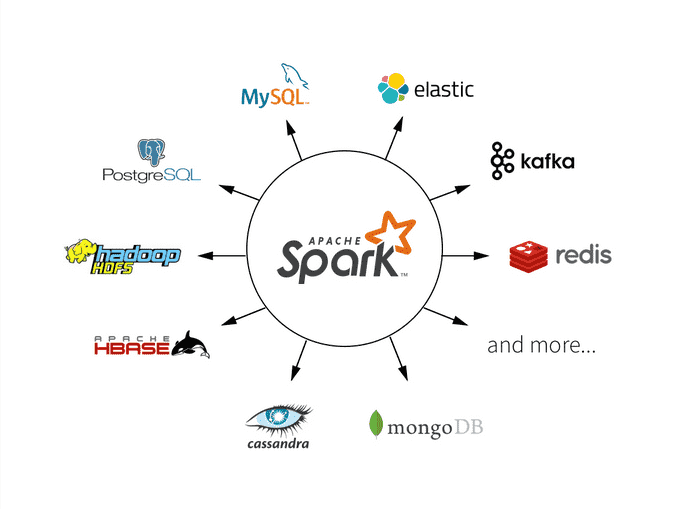

02-[了解]-内容提纲主要2个方面内容:DataFrame是什么和数据分析(案例讲解)1、DataFrame是什么 SparkSQL模块前世今生、官方定义和特性 DataFrame是什么 DataFrame = RDD[Row] + Schema,Row表示每行数据,抽象的,并不知道每行Row数据...

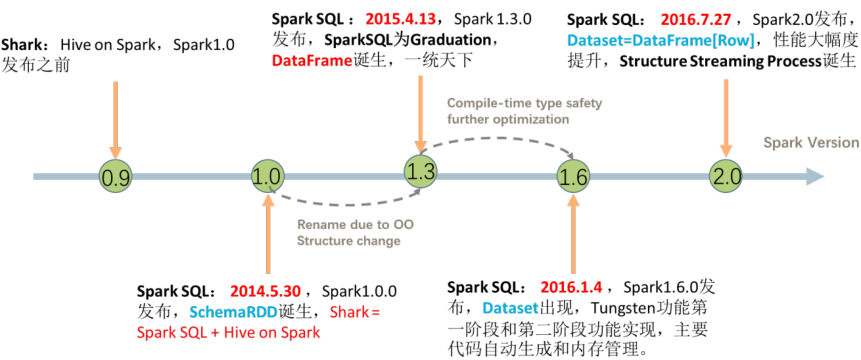

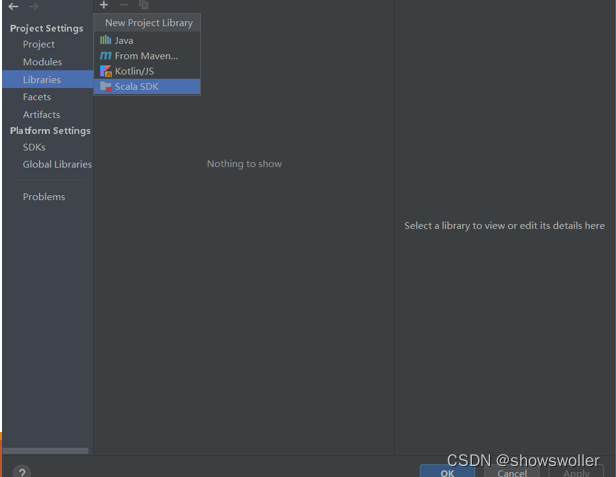

【大数据技术Spark】Spark SQL操作Dataframe、读写MySQL、Hive数据库实战(附源码)

需要源码和依赖请点赞关注收藏后评论区留言私信~~~一、Dataframe操作步骤如下1)利用IntelliJ IDEA新建一个maven工程,界面如下2)修改pom.XML添加相关依赖包3)在工程名处点右键,选择Open Module Settings4)配置Scala Sdk,界面如下5)新建文件...

Spark【Spark SQL(二)RDD转换DataFrame、Spark SQL读写数据库 】

从 RDD 转换得到 DataFrameSaprk 提供了两种方法来实现从 RDD 转换得到 DataFrame:利用反射机制推断 RDD 模式使用编程方式定义 RDD 模式下面使用到的数据 people.txt :Tom, 21 Mike, 25 Andy, 181、利用反射机制推断 RDD 模式...

pyspark笔记(RDD,DataFrame和Spark SQL)2

23.pyspark.sql.functions.date_format(date, format)将日期/时间戳/字符串转换为由第二个参数给定日期格式指定格式的字符串值。一个模式可能是例如dd.MM.yyyy,可能会返回一个字符串,如“18 .03.1993”。可以使用Java类java.text...

pyspark笔记(RDD,DataFrame和Spark SQL)1

RDD和DataFrame1.SparkSession 介绍SparkSession 本质上是SparkConf、SparkContext、SQLContext、HiveContext和StreamingContext这些环境的集合,避免使用这些来分别执行配置、Spark环境、SQL环境、Hive环...

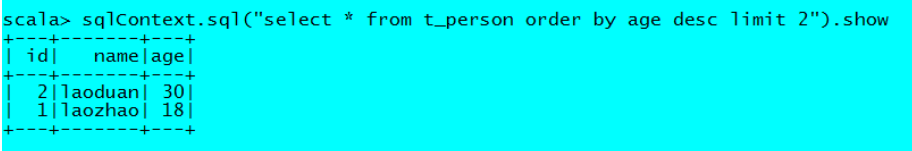

200 Spark DataFrame常用操作- SQL风格语法

如果想使用SQL风格的语法,需要将DataFrame注册成表personDF.registerTempTable("t_person")//查询年龄最大的前两名sqlContext.sql("select * from t_person order by age desc limit 2").sho...

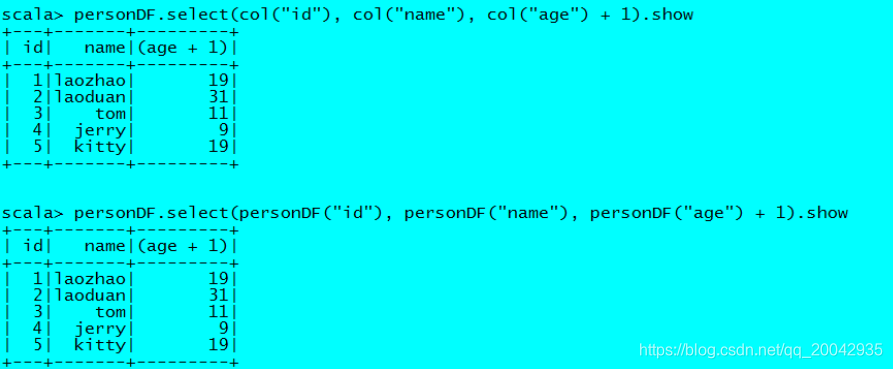

199 Spark DataFrame常用操作- DSL风格语法

//查看DataFrame中的内容personDF.show//查看DataFrame部分列中的内容personDF.select(personDF.col("name")).show personDF.select(col("name"), col("age")).show personDF.se...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

社区圈子

apache spark更多dataframe相关

- dataframe apache spark

- apache spark dataframe常用操作语法

- apache spark dataframe常用操作

- 大数据apache spark dataframe dataset常用操作

- apache spark dataframe区别

- apache spark rdd dataframe

- apache spark dataframe schema

- apache spark dataframe列

- apache spark创建DataFrame

- apache spark rdd dataframe dataset

- apache spark dataframe排序

- apache spark sql dataframe函数一文详解方法

- apache spark创建rdd dataframe

- alluxio apache spark dataframe

- 计算apache spark dataframe

apache spark您可能感兴趣

- apache spark入门

- apache spark大数据

- apache spark配置

- apache spark安装

- apache spark单机

- apache spark环境搭建

- apache spark案例

- apache spark测试

- apache spark streaming

- apache spark分布式

- apache spark SQL

- apache spark Apache

- apache spark数据

- apache spark rdd

- apache spark Hadoop

- apache spark MaxCompute

- apache spark运行

- apache spark集群

- apache spark summit

- apache spark模式

- apache spark学习

- apache spark分析

- apache spark机器学习

- apache spark实战

- apache spark Scala

- apache spark flink

- apache spark程序

- apache spark操作