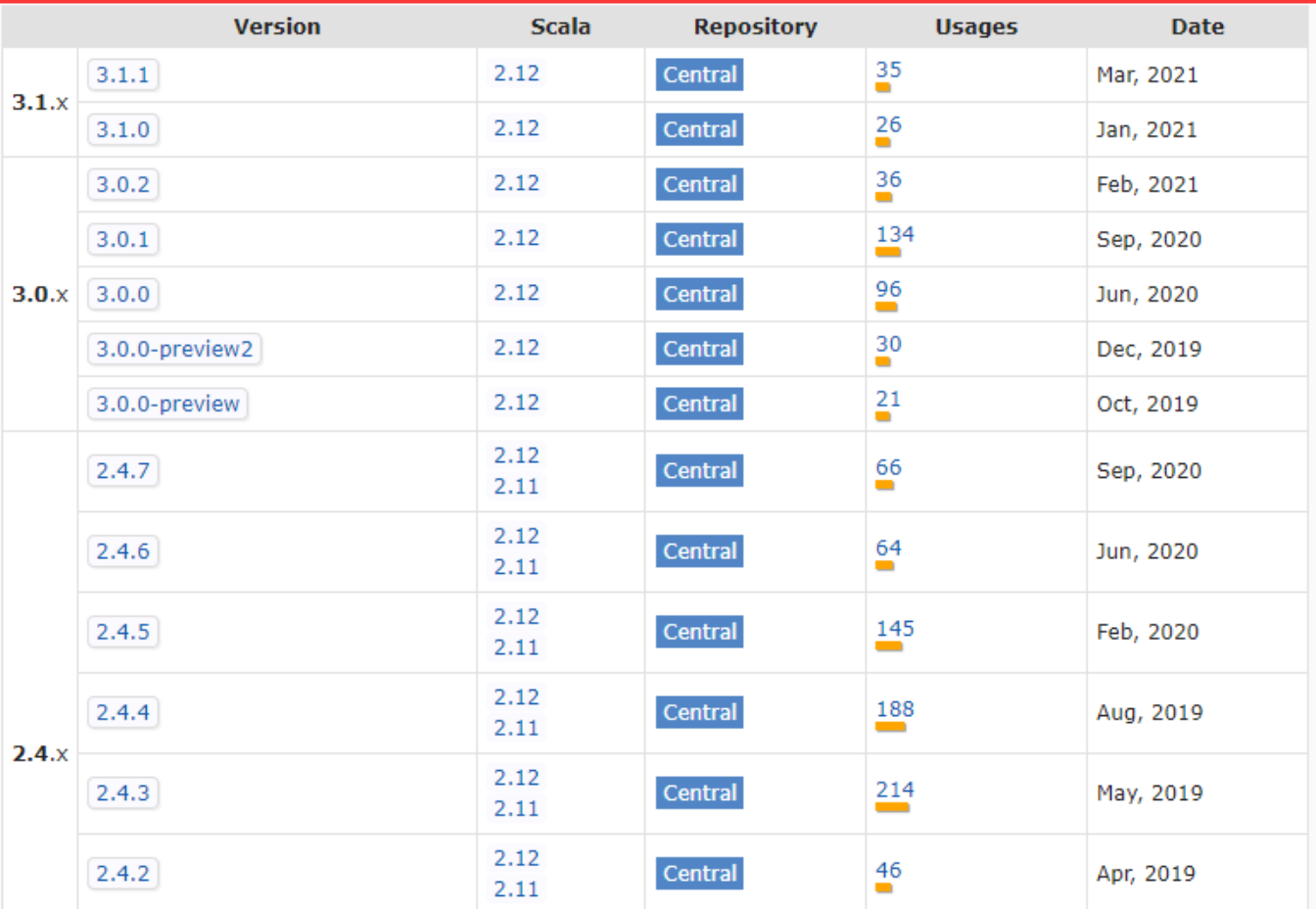

spark 与 scala 的对应版本查看、在idea中maven版本不要选择17,弄了好久,换成11就可以啦

1 ,思路 : 去 maven 查看 2 ,网址 : https://mvnrepository.com/artifact/org.apache.spark/spark-core 3 ,看到 : ...

Spark 集群和 Scala 编程语言的关系

Spark 集群是基于Apache Spark的分布式计算环境,用于处理大规模数据集的计算任务。Apache Spark是一个开源的、快速而通用的集群计算系统,提供了高级的数据处理接口,包括Spark SQL、Spark Streaming、MLlib(机器学习库)和GraphX(图计算库)。Spa...

Spark编程语言选择:Scala、Java和Python

在大数据处理和分析领域,Apache Spark已经成为一种非常流行的工具。它提供了丰富的API和强大的性能,同时支持多种编程语言,包括Scala、Java和Python。选择合适的编程语言可以直接影响Spark应用程序的性能、可维护性和开发效率。在本文中,我们将详细探讨每种编程语言,并提供示例代码...

掌握Scala基础知识,让你在Spark的学习道路上更近一步!

前言scala为啥如此重要呢?1、因为Spark是用scala开发的现在Spark是大数据领域的杀手级应用框架,大小企业中都会在搭建的大数据平台上,大量使用Spark来处理和分析数据,而要想学好Spark,Scala基础知识是必须要掌握的。2、功能强大且简练,适合大数据处理Scala将面向对象与函数...

Spark-编程进阶(Scala版)

累加器累加器提供了将工作节点中的值聚合到驱动器程序中的简单语法。累加器的一个常见用法是在调测时对作业执行过程中的时间进行计数。例:累加空行val sc = new SparkContext() val file = sc.textFile("file.txt") val blankLines = s...

Spark-数据读取与保存(Scala版)

文件格式Spark对文件的读取和保存方式都很简单,会根据文件的扩展名选择对应的处理方式文本文件当我们将一个文本文件读取为RDD时,输入的每一行都会成为RDD的一个元素,也可以将多个完整的文本文件一次性读取为一个pair RDD,其中键是文件名,值是文件内容。读取文本文件只需要使用文件路径作为参数调用...

Spark RDD编程基础(Scala版)

RDD :弹性分布式数据集(分布式的元素集合)Spark中,对数据的所有操作不外乎创建RDD,转化已有的RDD以及调用RDD操作进行求值,Spark会自动将RDD中的数据分发到集群上,并将操作并行化执行。1、创建RDDSpark有两种创建RDD的方式,一种是读取外部数据集,一种是在驱动器中对一个集合...

Scala写Spark笔记

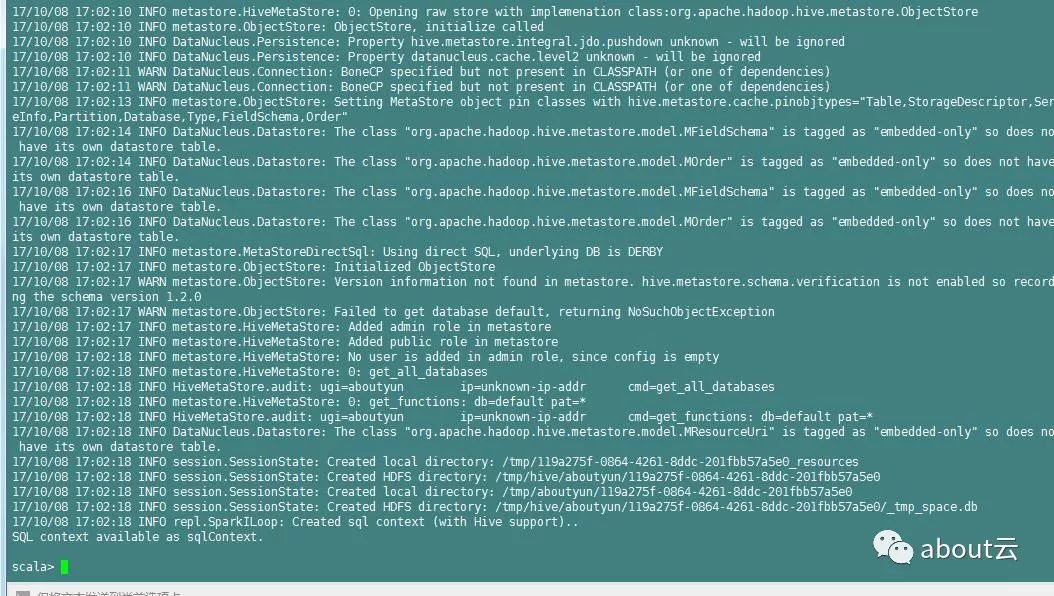

学习感悟(1)配置环境最费劲(2)动手写,动手写,动手写WordCountpackage wordcount import org.apache.spark.{SparkConf, SparkContext} /** * @author CBeann * @create 2019-...

如何查看spark与hadoop、kafka、Scala、flume、hive等兼容版本【适用于任何版本】

方法当我们安装spark的时候,很多时候都会遇到这个问题,如何找到对应spark的各个组件的版本,找到比较标准的版本兼容信息。答案在spark源码中的pom文件。首先我们从官网下载源码。进入官网http://spark.apache.org选择download,然后我们看到下面内容# Master ...

日志分析实战之清洗日志小实例1:使用spark&Scala分析Apache日志

about云日志分析,那么过滤清洗日志。该如何实现。这里参考国外的一篇文章,总结分享给大家。使用spark分析网站访问日志,日志文件包含数十亿行。现在开始研究spark使用,他是如何工作的。几年前使用hadoop,后来发现spark也是容易的。下面是需要注意的:如果你已经知道如何使用spark并想知...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。