![大语言模型的预训练[1]:基本概念原理、神经网络的语言模型、Transformer模型原理详解、Bert模型原理介绍](https://ucc.alicdn.com/fnj5anauszhew_20230717_e843a02529534b84bf8ff46d8b43e094.png)

大语言模型的预训练[1]:基本概念原理、神经网络的语言模型、Transformer模型原理详解、Bert模型原理介绍

大语言模型的预训练[1]:基本概念原理、神经网络的语言模型、Transformer模型原理详解、Bert模型原理介绍 1.大语言模型的预训练 1.LLM预训练的基本概念 预训练属于迁移学习的范畴。现有的神经网络在进行训练时,一般基于反向传播(Back Propagation,BP)算法,先对网络中的...

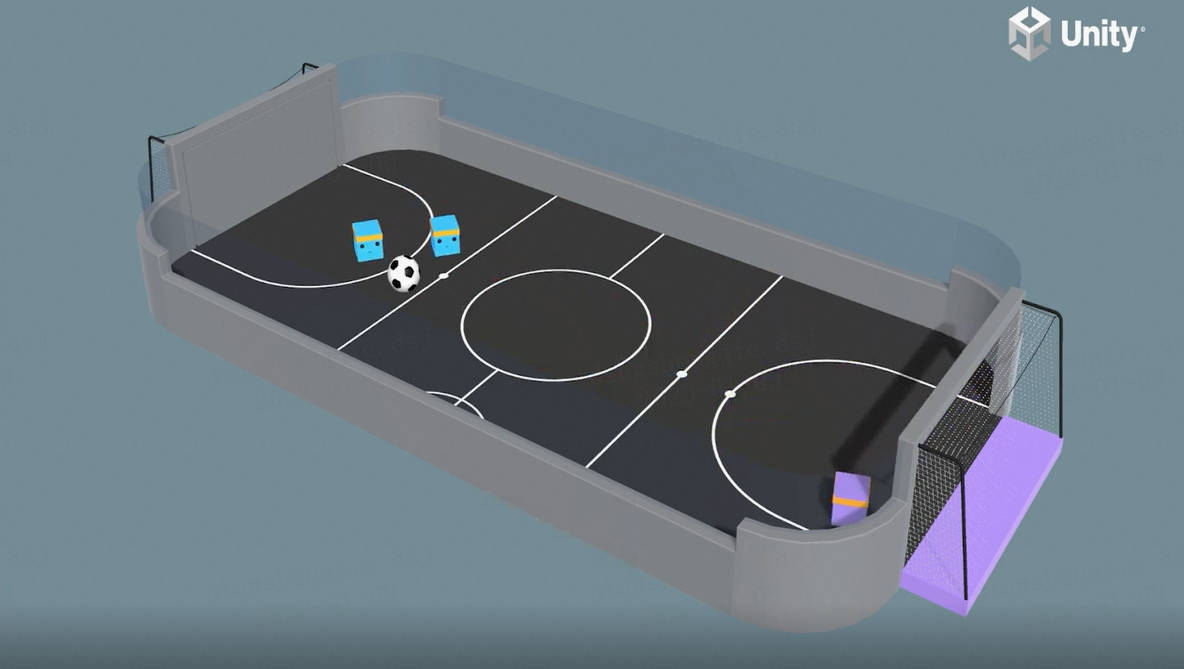

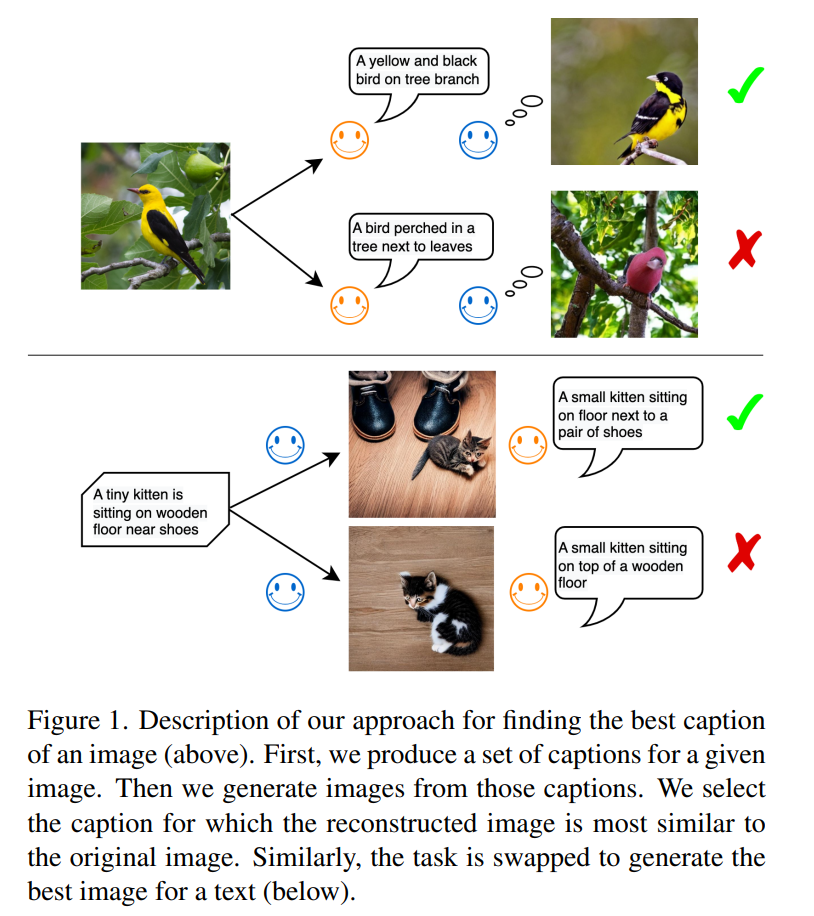

DALL-E和Flamingo能相互理解吗?三个预训练SOTA神经网络统一图像和文本

编辑:王楷本文提出了一个统一的框架,其中包括文本到图像生成模型和图像到文本生成模型,该研究不仅为改进图像和文本理解提供了见解,而且为多模态模型的融合提供了一个有前途的方向。多模态研究的一个重要目标就是提高机器对于图像和文本的理解能力。特别是针对如何在两种模型之间实现有意义的交流,研究者们付出了巨大努...

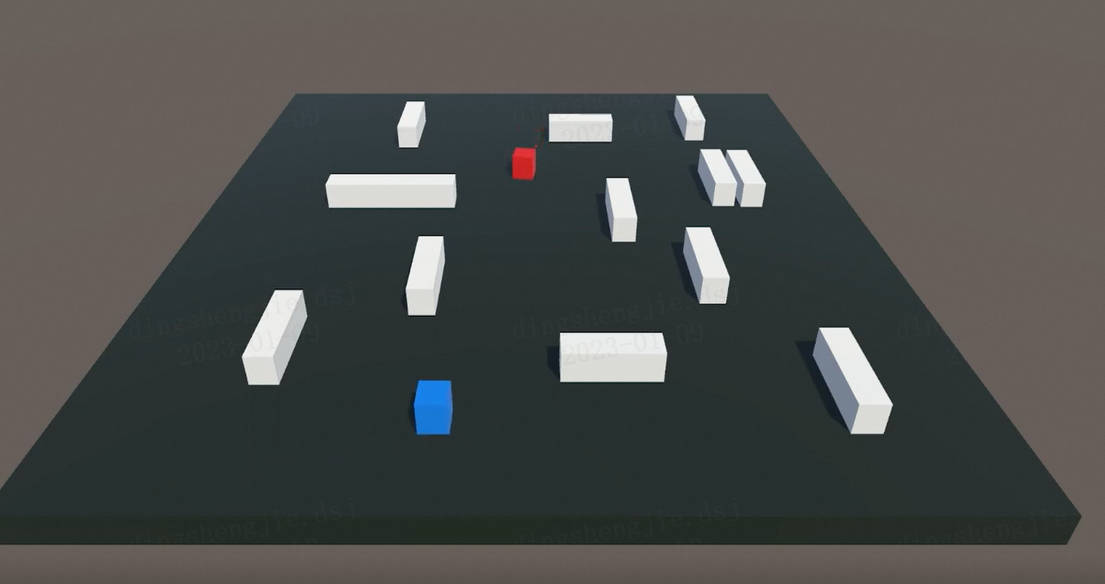

何恺明“终结”ImageNet预训练时代:从0开始训练神经网络,效果比肩COCO冠军

何恺明,RBG,Piotr Dollár。 三位从Mask R-CNN就开始合作的大神搭档,刚刚再次联手,一文“终结”了ImageNet预训练时代。 他们所针对的是当前计算机视觉研究中的一种常规操作:管它什么任务,拿来ImageNet预训练模型,迁移学习一下。 但是,预训练真的是必须的吗? 这篇重新...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。