[帮助文档] 使用Kafka连接器进行Kerberos身份认证

Kerberos是一种网络身份验证协议,用于提供安全的身份验证服务,以保证通信的安全性。只有在Flink开发控制台正确配置Kerberos和Kafka服务的信息,Flink作业才能访问开启Kerberos认证服务的Kafka集群。本文为您介绍如何为Kafka客户端开启Kerberos认证。

Flink CDC产品常见问题之upsert-kafka增加参数报错如何解决

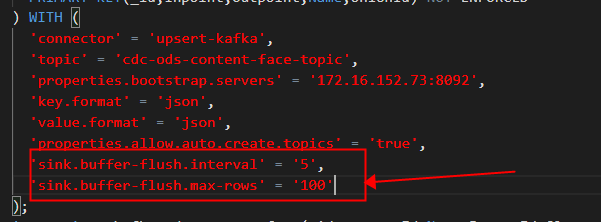

问题一:Flink CDC里请问upsert-kafka增加参数报错是为什么? Flink CDC里请问upsert-kafka增加参数: 'sink.buffer-flush.interval' = '5', 'sink.buffer-flush.max-rows' = '100'后报错是什么原因...

[帮助文档] 如何创建和使用Kafka JSON Catalog

配置Kafka JSON Catalog后,您可以在Flink全托管作业开发中直接访问Kafka集群中格式为JSON的Topic,无需再定义Schema。本文为您介绍如何在Flink全托管模式下创建、查看及删除Kafka JSON Catalog。

Flink CDC里请问upsert-kafka增加参数报错是为什么?

Flink CDC里请问upsert-kafka增加参数: 'sink.buffer-flush.interval' = '5', 'sink.buffer-flush.max-rows' = '100'后报错是什么原因?

Flink CDC中kafka有没有忽略删除操作的参数?

Flink CDC中kafka有没有忽略删除操作的参数?

在Flink我从holo读取数据,数据往kafka 写,好像差12个小时, 有没有参数哪里可以配置 ?

这是因为在Flink中,时间戳默认是以毫秒为单位的,而在HoloDB中,时间戳默认是以纳秒为单位的。因此,需要将HoloDB中的时间戳转换为Flink中使用的毫秒时间戳。你可以通过设置connector.read.format.stringtimeformat参数为yyyy-MM-dd HH:mm:...

在Flink我从holo读取数据,数据往kafka 写,好像差12个小时,有没有参数哪里可以配置 ?

在Flink我从holo读取数据,数据往kafka 写,好像差12个小时, 有没有参数哪里可以配置 ?

flink怎么能够快速消费kafka数据,需要设置什么参数呢?

flink怎么能够快速消费kafka数据,需要设置什么参数呢?我现在消费感觉有点慢

Flink CDC中sink到kafka,kafka有密码怎么处理?密码参数是啥?

Flink CDC中sink到kafka,kafka有密码怎么处理?密码参数是啥?

多Flink同时消费一条kafka消息,应该怎么设置flink的参数呀?

多Flink同时消费一条kafka消息,应该怎么设置flink的参数呀?

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

实时计算 Flink版kafka相关内容

- 实时计算 Flink版kafka报错

- 实时计算 Flink版kafka apache

- 实时计算 Flink版kafka延迟

- 实时计算 Flink版kafka doris

- 实时计算 Flink版sql kafka

- 实时计算 Flink版kafka格式

- 实时计算 Flink版kafka value

- 实时计算 Flink版kafka排查

- 实时计算 Flink版flinksql kafka

- 实时计算 Flink版kafka flinksql

- 实时计算 Flink版kafka元数据

- 实时计算 Flink版kafka设置

- 实时计算 Flink版适配kafka

- 实时计算 Flink版kafka jar

- 实时计算 Flink版kafka jar包

- 实时计算 Flink版kafka表数据

- 实时计算 Flink版kafka场景

- 实时计算 Flink版source kafka

- 实时计算 Flink版cdc sql kafka

- 实时计算 Flink版kafka source

- 实时计算 Flink版kafka kafkasource

- 实时计算 Flink版kafka ck

- 实时计算 Flink版kafka服务

- 实时计算 Flink版kafka hdfs

- 实时计算 Flink版kafka重启

- java实时计算 Flink版kafka

- 实时计算 Flink版库kafka示例

- 实时计算 Flink版库kafka

- 实时计算 Flink版自定义kafka实践

- 实时计算 Flink版自定义kafka

- 实时计算 Flink版kafka format

- 实时计算 Flink版kafka实践

- 实时计算 Flink版kafka作业

- 实时计算 Flink版数据源kafka

- 实时计算 Flink版kafka hive

- 实时计算 Flink版kafka json格式

- 实时计算 Flink版kafka json

- 实时计算 Flink版kafka canal-json

- 实时计算 Flink版kafka op

- 实时计算 Flink版作业kafka

- 实时计算 Flink版kafka偏移量

- 实时计算 Flink版kafka办法

- 实时计算 Flink版datastream kafka

- 实时计算 Flink版实时同步kafka

- 实时计算 Flink版方法kafka

- 实时计算 Flink版kafka中报

- 实时计算 Flink版kafka starrocks

- 实时计算 Flink版配置kafka

- 实时计算 Flink版upsert kafka

实时计算 Flink版更多kafka相关

- 实时计算 Flink版kafka分区

- 实时计算 Flink版kafka topic

- 实时计算 Flink版连接kafka

- 实时计算 Flink版kafka连接器

- 实时计算 Flink版kafka consumer

- 实时计算 Flink版kafka方法

- 实时计算 Flink版采集kafka

- 实时计算 Flink版kafka序列化

- 实时计算 Flink版kafka信息

- 实时计算 Flink版kafka kerberos

- 实时计算 Flink版代码kafka

- 实时计算 Flink版kafka窗口

- 实时计算 Flink版binlog kafka

- kafka hbase实时计算 Flink版

- 实时计算 Flink版kafka类

- kafka sink实时计算 Flink版

- 实时计算 Flink版mysql kafka数据

- flume kafka实时计算 Flink版finebi案例

- 实时计算 Flink版kafka认证

- 实时计算 Flink版程序kafka

- 实时计算 Flink版kafka有序

- 实时计算 Flink版kafka区分

- 实时计算 Flink版集群kafka

- 实时计算 Flink版kafka并行度

- 实时计算 Flink版kafka hbase

- 实时计算 Flink版kafka连接器特别的地方

- 实时计算 Flink版kafka topic分区

- 实时计算 Flink版ddl kafka

- 实时计算 Flink版kafka聚合

- 实时计算 Flink版kafka savepoint

- 实时计算 Flink版认证kafka

- 实时计算 Flink版kafka zookeeper

- 实时计算 Flink版kafka对象

- kafka实时计算 Flink版分析

- kafka spark实时计算 Flink版

- 实时计算 Flink版kafka速率

- 实时计算 Flink版kafka producer

- 实时计算 Flink版接收kafka

- 实时计算 Flink版kafka同步数据

- 实时计算 Flink版变更kafka

- 实时计算 Flink版kafka测试

- 实时计算 Flink版job kafka

- 实时计算 Flink版kafka乱序

- 实时计算 Flink版sql kafka offset

- 实时计算 Flink版kafka并行

- 实时计算 Flink版消费kafka消息

- flume kafka hbase实时计算 Flink版finebi案例

- 实时计算 Flink版kafka schema

- 实时计算 Flink版kafka窗口聚合

- 实时计算 Flink版kafka csv

实时计算 Flink版您可能感兴趣

- 实时计算 Flink版incremental

- 实时计算 Flink版达梦数据库

- 实时计算 Flink版遗漏

- 实时计算 Flink版port

- 实时计算 Flink版步骤

- 实时计算 Flink版pipeline

- 实时计算 Flink版数据格式

- 实时计算 Flink版oracle

- 实时计算 Flink版发送消息

- 实时计算 Flink版number

- 实时计算 Flink版CDC

- 实时计算 Flink版数据

- 实时计算 Flink版SQL

- 实时计算 Flink版mysql

- 实时计算 Flink版同步

- 实时计算 Flink版报错

- 实时计算 Flink版任务

- 实时计算 Flink版版本

- 实时计算 Flink版表

- 实时计算 Flink版Apache

- 实时计算 Flink版配置

- 实时计算 Flink版设置

- 实时计算 Flink版 CDC

- 实时计算 Flink版模式

- 实时计算 Flink版运行

- 实时计算 Flink版数据库

- 实时计算 Flink版Yarn

- 实时计算 Flink版checkpoint