[帮助文档] 在GPU实例的Docker环境中配置eRDMA功能实现容器应用程序的直接访问

eRDMA(Elastic Remote Direct Memory Access)是一种高性能网络通信技术,将eRDMA功能引入容器(Docker)环境可以实现容器应用程序绕过操作系统内核直接访问主机的物理eRDMA设备,从而提供更快的数据传输和通信效率,适用于在容器中需要大规模数据传输和高性能网...

[帮助文档] 如何配置共享GPU调度节点选卡策略

默认情况,Pod分配GPU资源的顺序为先分配完节点上的一张GPU卡,再分配其他GPU卡,避免出现GPU资源碎片。但是在有的场景中,您希望让Pod调度到节点上时,尽量分散到各个GPU卡上,避免因为某张GPU卡坏掉影响的业务过多。本文介绍如何配置共享GPU调度节点选卡策略。

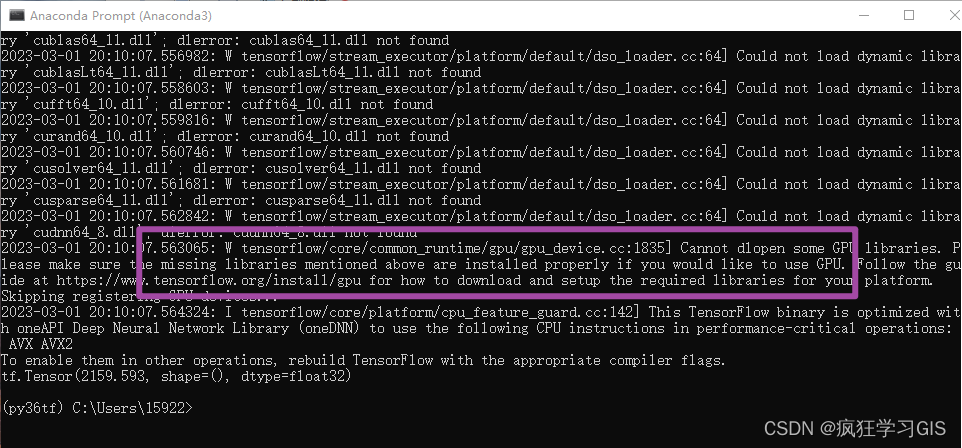

新版本GPU加速的tensorflow库的配置方法

本文介绍在Anaconda环境中,配置可以用GPU运行的Python新版tensorflow库的方法。 在上一篇文章Anaconda配置Python新版本tensorflow库(CPU、GPU通用)的方法(https://blog.csdn.net/zhebushibiaoshifu/arti...

[帮助文档] 在GPU实例上配置eRDMA实现高效数据传输

GPU实例绑定弹性RDMA网卡(ERI)后,各GPU实例间在VPC网络下可以实现RDMA直通加速互联,相比传统的RDMA,eRDMA可以提供更高效的数据传输服务,有效提升GPU实例之间的通信效率并缩短任务处理时间。本文介绍如何在GPU实例上配置eRDMA。

[帮助文档] 如何配置共享GPU调度cGPU算力调度策略

ACK集群Pro版的共享GPU功能基于cGPU实现。共享GPU算力隔离提供不同的分配策略,您可以在ACK Pro版集群中通过设置共享GPU组件的Policy来选择不同的分配策略。本文介绍通过配置共享GPU算力分配策略,实现不同效果的算力分配。

[帮助文档] 如何配置共享GPU调度仅共享不隔离策略

在某些场景下,您可能不需要GPU隔离模块参与共享GPU调度。例如,有些业务应用本身提供显存限制能力,类似于Java应用启动时,可以通过选项指定该应用能够使用的最大内存值。这种情况下,使用GPU隔离模块隔离业务显存反而会有问题。对此,共享GPU调度支持某些节点不安装GPU隔离模块的选项。本文介绍如何配...

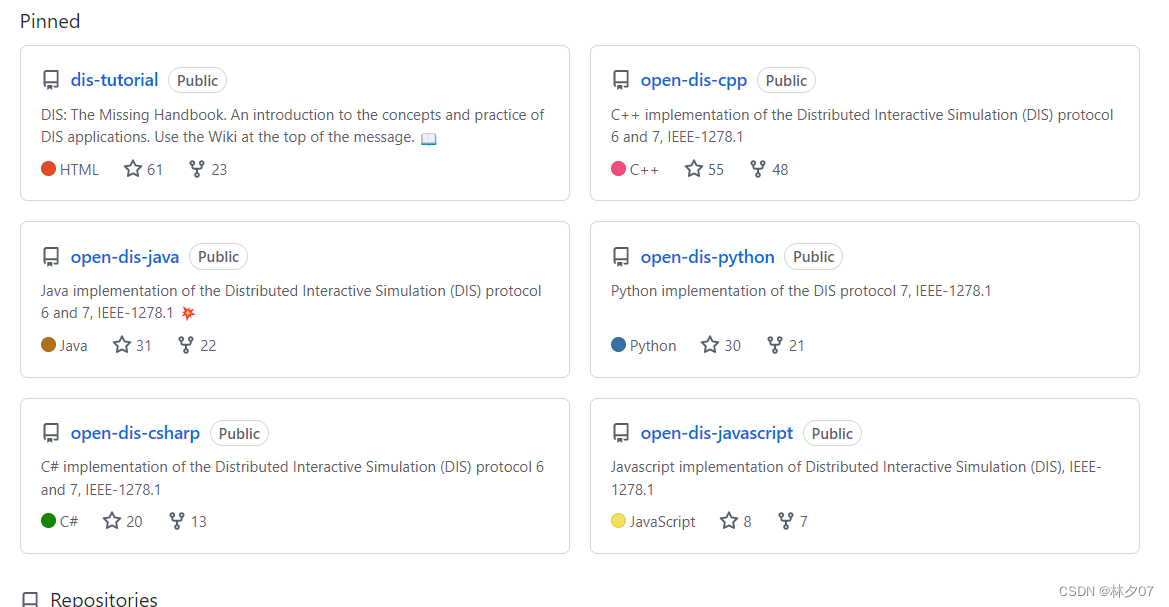

Open-Dis的C++版本编译(CMake-gpu 3.21.4)以及SDL2和SDL_net库的配置使用

Open-DisOpen-Dis简介Dis是国防部,北约和联合国实时/虚拟世界建模和仿真中使用最广泛的协议之一。 Open-DIS是Java、javascript、python、 C ++和C#中标准的免费开源实现。 该项目使用BSD风格的开源许可证,该许可证是非病毒式和商业友好的。分布式交互仿真D...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。