使用UDF扩展Spark SQL

Apache Spark是一个强大的分布式计算框架,Spark SQL是其一个核心模块,用于处理结构化数据。虽然Spark SQL内置了许多强大的函数和操作,但有时可能需要自定义函数来处理特定的数据需求。在Spark SQL中,可以使用UDF(User-Defined Functions)来自定义函...

10月29日社区直播【Spark Shuffle RPMem扩展: 借助持久内存与RDMA加速Spark 数据分析】

主题: Spark Shuffle RPMem扩展: 借助持久内存与RDMA加速Spark 数据分析 时间: 10月29日 19:00 观看方式: 扫描下方二维码进钉钉群或者登陆直播间(即回看链接)https://developer.aliyun.com/live/245610 讲师: 张建,英特尔...

Airbnb 是如何通过 balanced Kafka reader 来扩展 Spark streaming 实时流处理能力的

Airbnb 日志事件获取 日志事件从客户端(例如移动应用程序和 Web 浏览器)和在线服务发出,其中包含行为或操作的关键信息。每个事件都有一个特定的信息。例如,当客人在 Airbnb.com 上搜索马里布的海滨别墅时,将生成包含位置,登记和结账日期等的搜索事件。 在 Airbnb,事件记录对于我们...

扩展org.apache.spark.sql.Row功能:Spark Scala

在Spark Row/* Returns true if there are any NULL values in this row. / def anyNull: Boolean = {val len = length var i = 0 while (i }可用于评估任何值的行连续为空。同样我想...

扩展Spark Catalyst,打造自定义的Spark SQL引擎

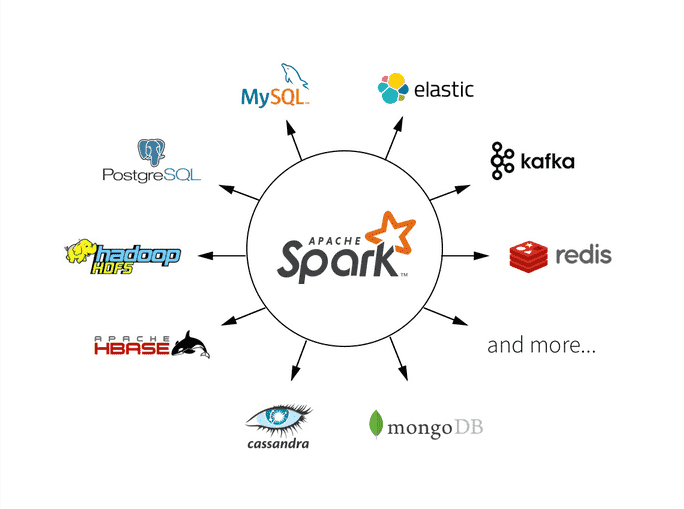

Apache Spark是大数据处理领域最常用的计算引擎之一,被应用在各种各样的场景中,除了易用的API,稳定高效的处理引擎,可扩展性也是Spark能够得到广泛应用的一个重要原因。Spark中最常见的扩展就是基于DataSource API添加对新数据源的支持,除了Spark内置的HDFS,S3,K...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

社区圈子

apache spark您可能感兴趣

- apache spark Hadoop

- apache spark数据

- apache spark分析

- apache spark Python

- apache spark可视化

- apache spark数据处理

- apache spark入门

- apache spark大数据

- apache spark配置

- apache spark安装

- apache spark SQL

- apache spark streaming

- apache spark Apache

- apache spark rdd

- apache spark MaxCompute

- apache spark运行

- apache spark集群

- apache spark summit

- apache spark模式

- apache spark学习

- apache spark实战

- apache spark机器学习

- apache spark Scala

- apache spark flink

- apache spark程序

- apache spark操作