用logrote和split分割nohup.out日志

背景:在生产环境中使用 nohup 运行 JAR 包时,会产生大量日志文件,导致磁盘存储占用过高,例如每天可能产生约30GB的日志数据。 解决方案: 使用 split 分割日志文件: this_path=$(cd /app/query4a/; pw...

在视觉智能平台中分割返回的URL是国内地址吗,日志显示有近50%的比例下载失败,如何解决?

在视觉智能平台中分割返回的URL是国内地址吗,我们服务器在国外,日志显示有近50%的比例下载失败,如何解决?

分布式系统设计模式 - 分割日志(Segmented Log)

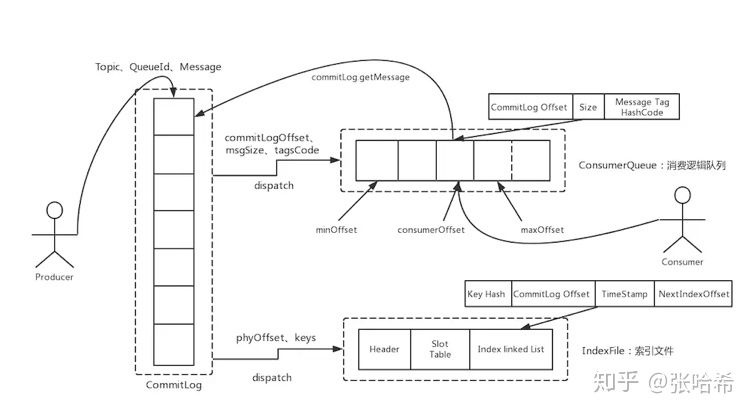

原文链接:Segmented Log分割日志(Segmented Log)将大文件切分为更容易处理的多个更小的文件。问题背景单一的日志文件可能会增长到很大,并且在程序启动时读取从而成为性能瓶颈。老的日志需要定时清理,但是对于一个大文件进行清理操作很费劲。解决方案将单一日志切分为多个,日志在达到一定大...

使用logrotate分割Tomcat的catalina日志

使用logrotate分割Tomcat的catalina日志 切割catalian日志的方式有很多种,比如shell脚本的、cronolog或者通过配置log4j等等这些都可以实现。但今天我要介绍是使用logrotate来按日期生成日志。 原文是一个外国博主的文章,在这里分享给大家。 如果catal...

^_^直接用脚本分割日志,不用工具。

^_^直接用脚本分割日志,不用工具。 cp access_log access_${yDay}.log > access_log if [ -f access_${x7Day}.log ]; then rm -rf access_${x7Day}.log fi ...

Linux下自动分割Nginx日志文件(一)-----自定义脚本和定时任务

Nginx 是一个轻量级的 Web 服务器,体积小、性能高、速度快等诸多优点。但不足的是也存在缺点,比如其产生的访问日志文件一直就是一个,不会自动地进行切割,如果访问量很大的话,将 导致日志文件容量非常大,不便于管理。当然了,我们也不希望看到这么庞大的一个访问日志文件,那需要手动对这个...

nginx 定时分割日志

nginx 是没有自动分割日志的,所以就需要自己实现日志分割 原 站点所有日志都放在一个目录里(文件名即站点名) 分割方式:每个站点一个目录,每天生成一个日志文件,根据文件名称生成目录 呆狐狸.凨 1.lanmps_cut_log.sh shell文件...

求 nginx 配置分割网站日志

求 nginx 配置分割网站日志,长期积累日志文件太大了,不便于阅读,应该怎么配置分割成按照日期的日志文件?求解答

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。