[帮助文档] PySpark任务开发入门

您可以自行编写并构建包含业务逻辑的Python脚本,上传该脚本后,即可便捷地创建和执行PySpark任务。本文通过一个示例,为您演示如何进行PySpark任务的开发与部署。

[帮助文档] 通过PySpark开发Spark应用

本文介绍了如何开发AnalyticDB MySQL Spark Python作业,以及如何通过VirtualEnv技术打包Python作业的运行环境。

Python大数据之PySpark(三)使用Python语言开发Spark程序代码

使用Python语言开发Spark程序代码Spark Standalone的PySpark的搭建----bin/pyspark --master spark://node1:7077Spark StandaloneHA的搭建—Master的单点故障(node1,node2),zk的leader选举机...

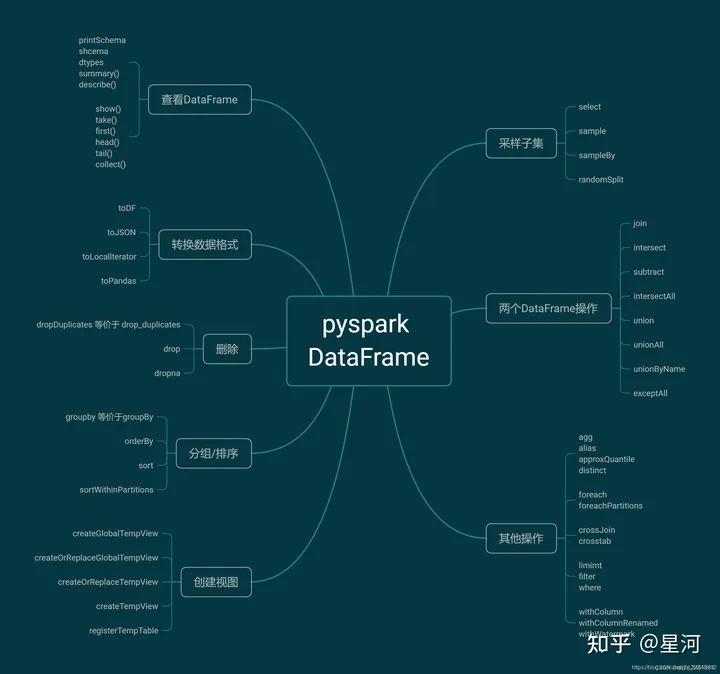

pyspark笔记(RDD,DataFrame和Spark SQL)1

RDD和DataFrame1.SparkSession 介绍SparkSession 本质上是SparkConf、SparkContext、SQLContext、HiveContext和StreamingContext这些环境的集合,避免使用这些来分别执行配置、Spark环境、SQL环境、Hive环...

使用pyspark进行Spark RDD窗口化

有一个Spark RDD,叫做rdd1。它有(key, value)一对,我有一个列表,其元素是一个tuple(key1,key2)。我想得到一个rdd2,有行`((key1,key2),(rdd1中key1的值,rdd1中key2的值))。有人能帮助我吗?RDD1集:key1, value1,ke...

从 "No module named pyspark" 到远程提交 spark 任务

版权声明:本文为半吊子子全栈工匠(wireless_com,同公众号)原创文章,未经允许不得转载。 https://blog.csdn.net/wireless_com/article/details/51170246 能在本地Mac环境用python提交spark 任务会方便很多,但是在安装了 s...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

社区圈子

apache spark您可能感兴趣

- apache spark e-mapreduce

- apache spark hbase

- apache spark SQL

- apache spark组件

- apache spark mode

- apache spark MaxCompute

- apache spark emr

- apache spark access

- apache spark odps

- apache spark报错

- apache spark streaming

- apache spark Apache

- apache spark数据

- apache spark Hadoop

- apache spark rdd

- apache spark大数据

- apache spark运行

- apache spark集群

- apache spark summit

- apache spark模式

- apache spark分析

- apache spark机器学习

- apache spark实战

- apache spark学习

- apache spark任务

- apache spark flink

- apache spark Scala

- apache spark程序