[帮助文档] 如何把MySQL整个数据库的数据离线同步到Hive

本文以MySQL为源端,Hive为目标端场景为例,为您介绍如何把MySQL整个数据库的数据离线同步到Hive。

[帮助文档] AnalyticDB PostgreSQL读写HDFS、Hive或MySQL外部数据

若您需要通过AnalyticDB PostgreSQL版访问外部异构数据源(HDFS、Hive和JDBC)时,可以使用异构数据源访问功能将外部数据转换为AnalyticDB PostgreSQL版数据库优化后的格式进行查询和分析。

[帮助文档] 通过MMA迁移Hive数据至MaxCompute

MaxCompute提供的数据迁移服务支持通过MMA(MaxCompute Migration Assist)服务,将Hive数据安全且高效地迁移到MaxCompute。

[帮助文档] 如何使用AnalyticDB MySQL湖仓版(3.0)Spark访问Hive数据

AnalyticDB MySQL湖仓版(3.0)支持访问Hive数据源。本文以E-MapReduce集群的Hive服务为例,介绍使访问Hive数据的方法。

[帮助文档] Dataphin如何解决从SAPHANA向Hive同步数据后数据精度丢失

问题描述Dataphin中从SAP HANA向Hive同步数据,数据精度丢失。SAP HANA中字段是decimal(11,2)。同步到Hive后,小数丢失,只有整数。问题原因从Hive中表结构可以看出,字段定义的是decimal(10,0)格式,因此同步到Hive数据只有整数。解决方案修改Hive...

【大数据开发运维解决方案】sqoop增量导入oracle/mysql数据到hive时时间字段为null处理

前面几篇文章详细介绍了sqoop全量增量导入数据到hive,大家可以看到我导入的数据如果有时间字段的话我都是在hive指定成了string类型,虽然这样可以处理掉时间字段在hive为空的问题,但是在kylin创建增量cube时需要指定一个时间字段来做增量,所以上面那种方式不行,这里的处理方式为把st...

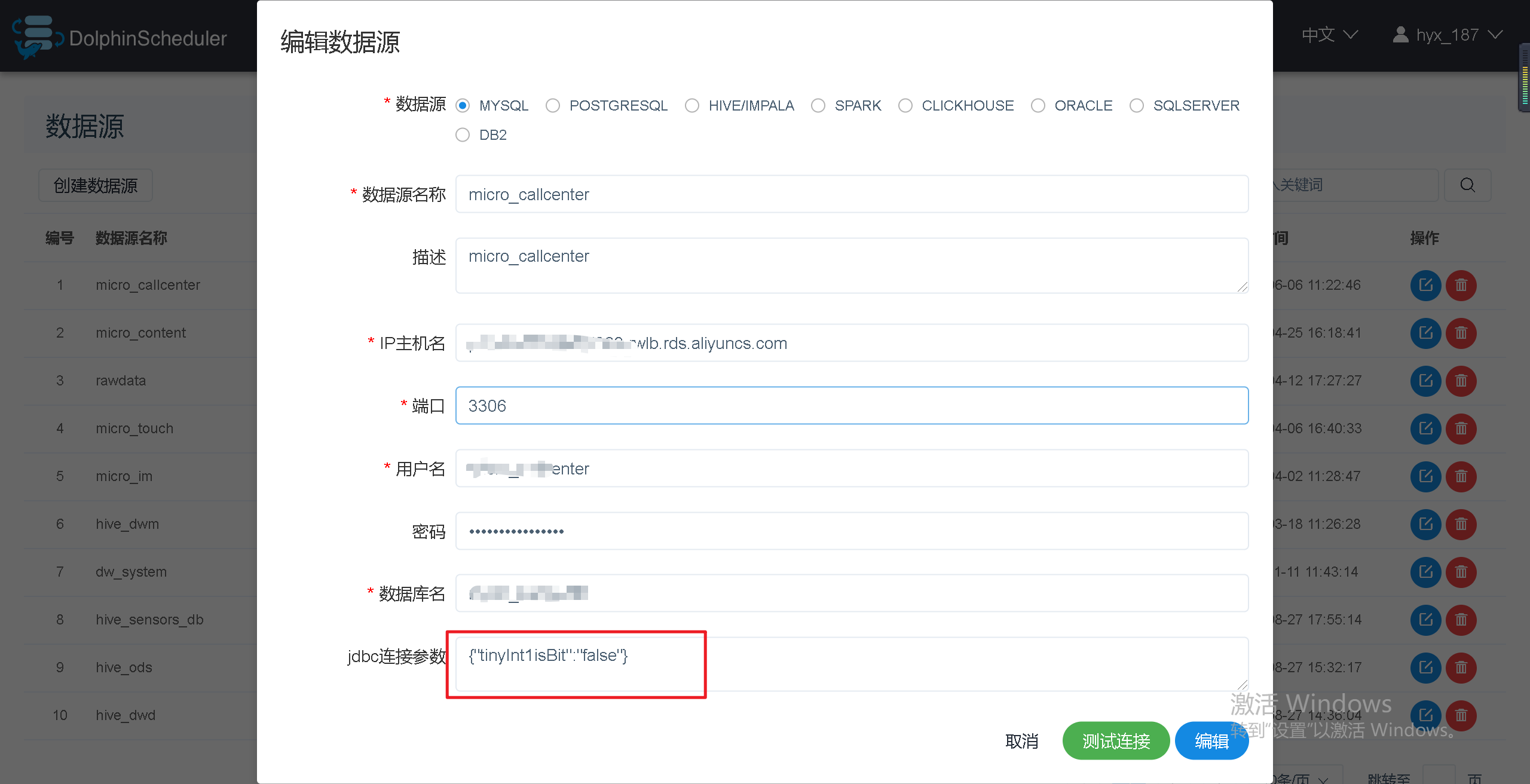

巨坑:Sqoop任务中从MySQL导入tinyint(1)类型数据到hive(tinyint),数据为null

问题描述从Sqoop导入MySQL导入TINYINT(1)类型数据到hive(tinyint),数据为null。问题原因Sqoop在抽取数据到Hive或者HDFS时,会自动将类型为tinyint(1)的列转为boolean类型,这就是导致抽取到Hive或HDFS中的数据中只有0和1的原因。因为默认情...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

Hive数据相关内容

- e-mapreduce访问Hive数据

- 访问Hive数据

- 数据Hive

- mysql数据Hive

- 数据Hive字段

- 抽取数据Hive

- Hive分析数据

- 数据计算Hive数据

- 迁移Hive数据

- hudi数据Hive

- spark-sql Hive数据

- Hive数据查询

- Hive数据报错

- 数据cdh Hive

- 数据Hive分区

- insert数据Hive

- Hive数据交互

- Hive访问数据

- 实时同步数据Hive

- 数据Hive查询

- emr Hive数据

- 集群Hive数据

- 机器学习pai Hive数据

- hudi Hive数据

- 字段数据Hive

- Hive数据分区

- Hive数据信息

- 大数据开发解决方案同步数据Hive

- Hive外部表数据

- Hive查询数据

- Hive数据设置

- cdc iceberg Hive数据

- hudi同步Hive数据

- e-mapreduce Hive数据

- Hive hudi数据

- Hive phoenix数据

- Hive日期数据

- sparksql读写Hive数据配置学习笔记

- Hive load数据

- Hive模式数据

- 数据抽取Hive

- Hive推荐系统数据

- Hive导入数据数据

- Hive insert数据

- Hive数据表查询数据

- Hive原表数据

- Hive数据代码

- Hive数据方法