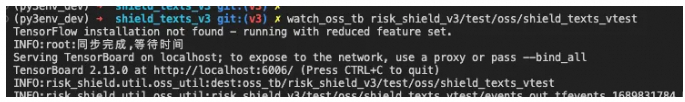

围绕 transformers 构建现代 NLP 开发环境

Intro 最近在 review 和重构团队的 NLP 炼丹基础设施,并基于 tranformers 库做了重新设计,本文将从“样本处理”,“模型开发”,“实验管理”,“工具链及可视化“ 几个角度介绍这项工作,并简单聊聊个人对“软件2.0”的看法。 样本处理 核心思路:函数式,流式,组合式,batc...

全套解决方案:基于pytorch、transformers的中文NLP训练框架,支持大模型训练和文本生成,快速上手,海量训练数据!

全套解决方案:基于pytorch、transformers的中文NLP训练框架,支持大模型训练和文本生成,快速上手,海量训练数据! 1.简介 目标:基于pytorch、transformers做中文领域的nlp开箱即用的训练框架,提供全套的训练、微调模型(包括大模型、文本转向量、文本生成、多模态等模...

Transformer培训:《Transformers for NLP 》详细解读打实基础

Github 代码地址:https://github.com/PacktPublishing/Transformers-for-Natural-Language-Processing《Transformers for Natural Language Processing》这本书的作者丹尼斯·罗斯曼...

Transformer培训课程:Transformers for NLP

Transformer的架构、训练及推理等都是在Bayesian神经网络不确定性数学思维下来完成的。Encoder-Decoder架构、Multi-head注意力机制、Dropout和残差网络等都是Bayesian神经网络的具体实现;基于Transformer各种模型变种及实践也都是基于Bayesi...

斯坦福NLP课程 | 第14讲 - Transformers自注意力与生成模型

作者:韩信子@ShowMeAI,路遥@ShowMeAI,奇异果@ShowMeAI教程地址:http://www.showmeai.tech/tutorials/36本文地址:http://www.showmeai.tech/article-detail/251声明:版权所有,转载请联系平台与作者并注...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。