揭秘深度学习中的自适应学习率调整策略

深度学习模型训练过程中,梯度下降法是最常用的优化算法。学习率作为梯度下降中的一个重要超参数,控制着权重更新的步长。一个较小的学习率可能导致训练过程缓慢,而较大的学习率则可能导致学习过程在最佳点附近震荡甚至偏离。为了解决这一问题,研究者们提出了学习率的方法,这些方法可以根据模型的训练动态来调整学习率。...

深度解析深度学习中的优化算法:从梯度下降到自适应方法

深度学习作为机器学习的一个子集,近年来在图像识别、自然语言处理等多个领域取得了显著成就。然而,一个深度学习模型的成功与否,很大程度上取决于其优化算法的选择和调整。优化算法负责更新网络中的权重,以最小化损失函数,从而提升模型的预测能力。在众多优化技术中,梯度下降法是最为广泛使用的基础算法。 最基本的梯...

深度学习入门笔记3 自适应神经元

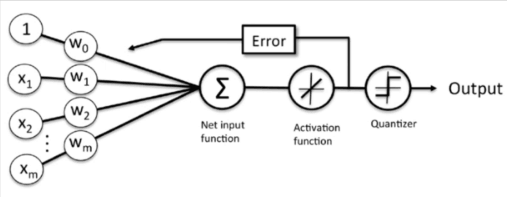

自适应线性神经元概念自适应线性神经网络(ADALINE——Adaptive Linear Neuron)是在感知器的基础上进行的一种改进。激活函数采用线性连续的函数来代替阶跃函数。自适应神经元&感知器激活函数:自适应神经元使用线性激活函数,感知器使用阶跃函数。误差更新:自适应神经元在最终结果...

深度学习相关概念:动量法与自适应梯度

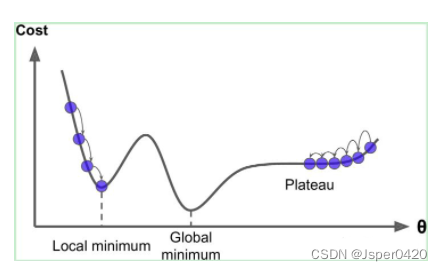

在上一篇博客中,我们介绍了梯度下降算法。但是梯度下降算法存在计算量过大或者陷入局部最优的问题。人们如今已经提出动量法和自适应梯度法来解决上述的问题。1.梯度下降存在的问题1.批量梯度下降(BGD)在梯度下降的每一步中,我们都用到了所有的训练样本,我们需要进行求和运算,在梯度下降中,在计...

![深度学习基础入门篇[六]:模型调优,学习率设置(Warm Up、loss自适应衰减等),batch size调优技巧,基于方差放缩初始化方法。](https://ucc.alicdn.com/pic/developer-ecology/fnj5anauszhew_4845430e5da047e4a2d4a837d2a780b0.jpeg)

深度学习基础入门篇[六]:模型调优,学习率设置(Warm Up、loss自适应衰减等),batch size调优技巧,基于方差放缩初始化方法。

深度学习基础入门篇[六]:模型调优,学习率设置(Warm Up、loss自适应衰减等),batch size调优技巧,基于方差放缩初始化方法。1.学习率学习率是训练神经网络的重要超参数之一,它代表在每一次迭代中梯度向损失函数最优解移动的步长,通常用$\eta$表示。它的大小决定网络学习速度的快慢。在...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

产品推荐

社区圈子

最佳实践