E-MapReduce开启使用DLF统一元数据后本地开发spark程序想访问emr hive中...

E-MapReduce开启使用DLF统一元数据后本地开发spark程序想访问emr hive中的表元数据连接要怎么配置

DataWorks上开发odps spark任务在submit阶段oom

DataWorks上开发odps spark任务在submit阶段oom

[帮助文档] Application任务开发

本文为您介绍Application任务开发的配置项说明和操作步骤。

[帮助文档] PySpark任务开发入门

您可以自行编写并构建包含业务逻辑的Python脚本,上传该脚本后,即可便捷地创建和执行PySpark任务。本文通过一个示例,为您演示如何进行PySpark任务的开发与部署。

[帮助文档] 开发JAR任务

您可以自行编写并构建包含业务逻辑的JAR包,上传此业务JAR包后,即可便捷地创建Spark JAR任务。本文通过一个示例,为您演示如何进行JAR任务的开发与部署。

[帮助文档] 开发SparkSQL任务

本文为您介绍SQL任务开发的配置项说明和操作步骤。

[帮助文档] 在DataWorks中使用Spark Distribution SQL Engine开发Spark SQL作业

若您需要在DataWorks中开发Spark SQL作业,可以通过注册CDH集群的方式,将AnalyticDB for MySQL的Spark Distribution SQL Engine服务注册为一种支持SQL的执行引擎,从而满足您在DataWorks中使用Spark Distribution ...

使用maxcompute开发ODPS Spark任务,使用spark.sql 无法 rename分区

使用maxcompute开发ODPS Spark任务,使用spark.sql 执行rename分区 sql: alter table $tableName partition(date='$dateFrom',source_id=$sourceFrom) rename to partition(da...

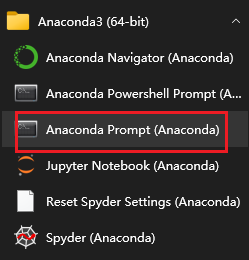

Python大数据之PySpark(三)使用Python语言开发Spark程序代码

使用Python语言开发Spark程序代码Spark Standalone的PySpark的搭建----bin/pyspark --master spark://node1:7077Spark StandaloneHA的搭建—Master的单点故障(node1,node2),zk的leader选举机...

Apache IoTDB开发系统整合之TsFile-Spark-Connector

TsFile-Spark-Connector用户指南1. TsFile-Spark-Connector简介TsFile-Spark-Connector 实现了 Spark 对 Tsfile 类型的外部数据源的支持。这使用户能够通过Spark读取,写入和查询Tsfile。使用此连接器,您可以将单个 T...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

社区圈子

apache spark您可能感兴趣

- apache spark实践

- apache spark应用

- apache spark大数据

- apache spark dataworks

- apache spark节点

- apache spark odps

- apache spark pyspark

- apache spark中文乱码

- apache spark MaxCompute

- apache spark e-mapreduce

- apache spark SQL

- apache spark streaming

- apache spark Apache

- apache spark数据

- apache spark Hadoop

- apache spark rdd

- apache spark运行

- apache spark集群

- apache spark summit

- apache spark模式

- apache spark分析

- apache spark机器学习

- apache spark实战

- apache spark学习

- apache spark任务

- apache spark flink

- apache spark Scala

- apache spark程序