Spark 【分区与并行度】

RDD 并行度和分区SparkConfsetMaster("local[*]")我们在创建 SparkContext 对象时通常会指定 SparkConf 参数,它包含了我们运行时的配置信息。如果我们的 setMaster 中的参数是 "local[*]" 时,通常代表使用的CPU核数为当前环境的最...

Spark 资源和数据并行度优化分析2 | 学习笔记

开发者学堂课程【大数据实时计算框架 Spark 快速入门:Spark 资源和数据并行度优化分析2 】学习笔记,与课程紧密联系,让用户快速学习知识。课程地址:https://developer.aliyun.com/learning/course/100/detail/1685Spark 资...

MapReduce与spark的并行度有什么不同?

MapReduce与spark的并行度有什么不同?

Spark并行度如何设置?

Spark并行度如何设置?

Spark并行度怎么设置才比较合适呢?

Spark并行度怎么设置才比较合适呢?

通过spark.default.parallelism谈Spark并行度

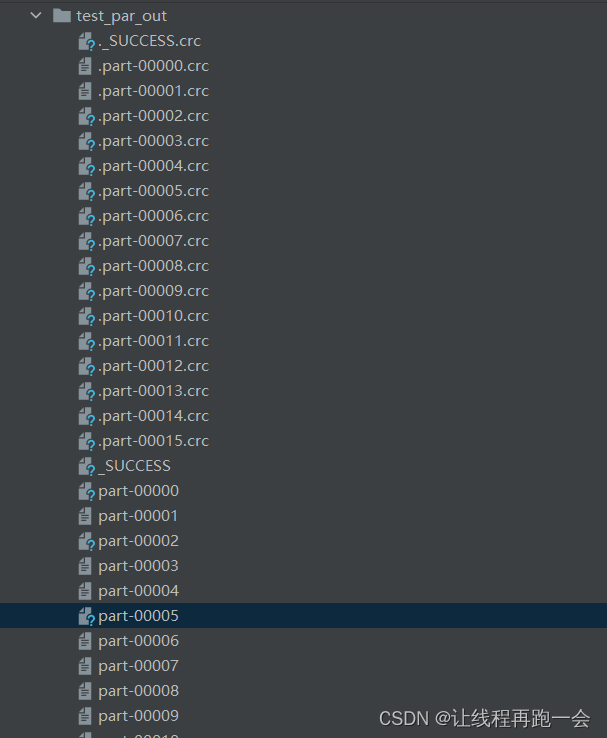

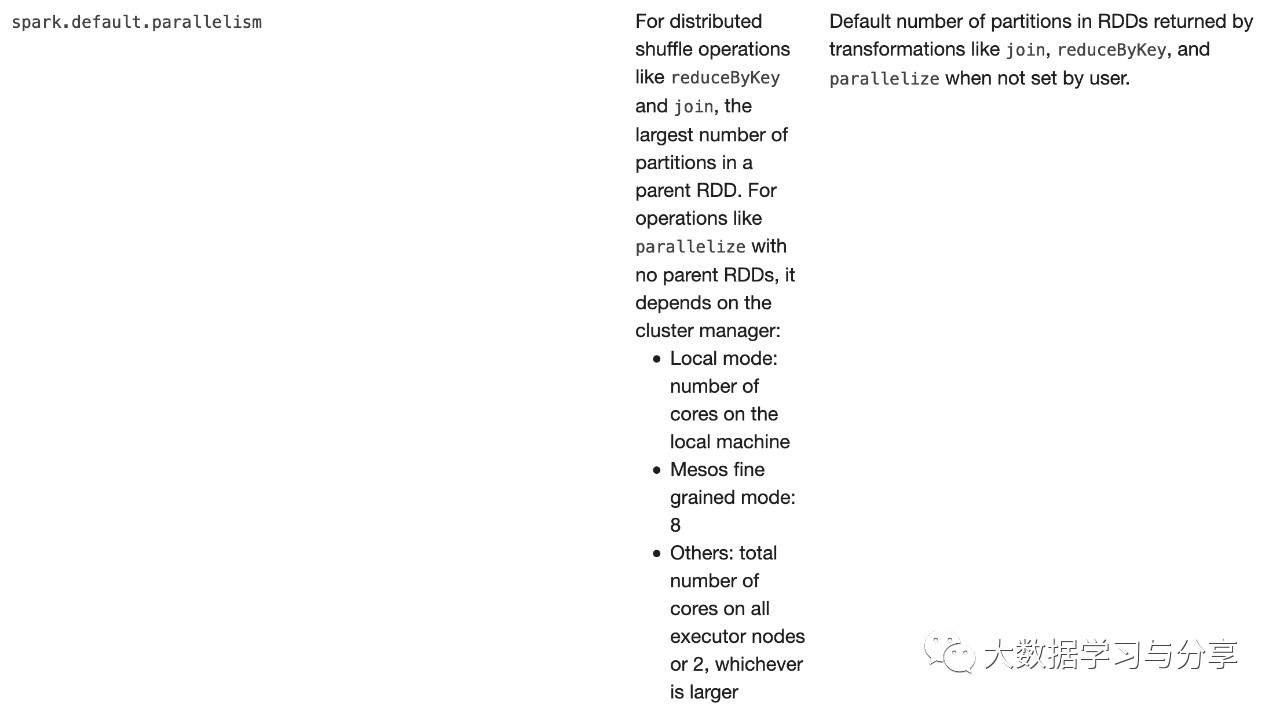

本篇文章首先通过大家熟知的一个参数spark.default.parallelism为引,聊一聊Spark并行度都由哪些因素决定? 上图是spark官网关于spark.default.parallelism参数说明: 1、对于reduceByKey和join这些分布式shuffle算子操作,取决于它...

Spark并行度怎么设置比较合适

Spark并行度怎么设置比较合适

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

社区圈子

apache spark您可能感兴趣

- apache spark Hadoop

- apache spark数据

- apache spark分析

- apache spark Python

- apache spark数据处理

- apache spark入门

- apache spark大数据

- apache spark配置

- apache spark安装

- apache spark单机

- apache spark SQL

- apache spark streaming

- apache spark Apache

- apache spark rdd

- apache spark MaxCompute

- apache spark运行

- apache spark集群

- apache spark summit

- apache spark模式

- apache spark学习

- apache spark机器学习

- apache spark实战

- apache spark Scala

- apache spark flink

- apache spark程序

- apache spark操作