【大数据技术Hadoop+Spark】HBase数据模型、Shell操作、Java API示例程序讲解(附源码 超详细)

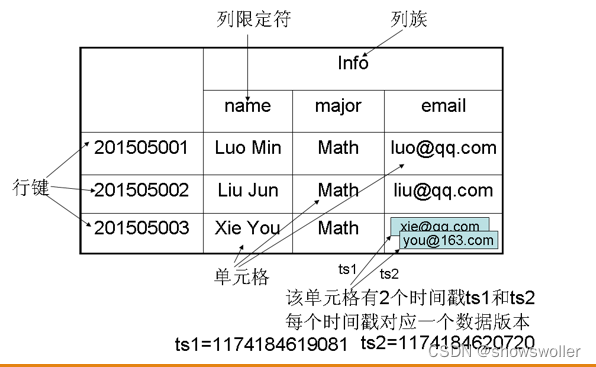

一、HBase数据模型HBase分布式数据库的数据存储在行列式的表格中,它是一个多维度的映射模型,其数据模型如下所示。表的索引是行键,列族,列限定符和时间戳,表在水平方向由一个或者多个列族组成,一个列族中可以包含任意多个列,列族支持动态扩展,可以很轻松的添加一个列族或者列,无须预先定义列的数量及数据...

【大数据技术Hadoop+Spark】HDFS Shell常用命令及HDFS Java API详解及实战(超详细 附源码)

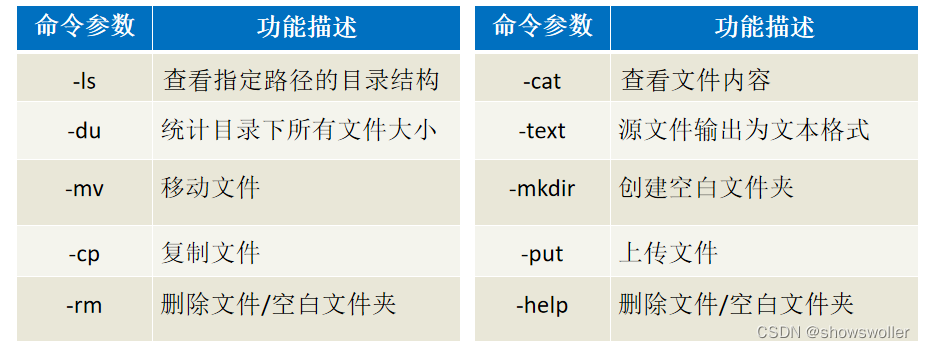

需要源码请点赞关注收藏后评论区留言私信~~~一、HDFS的Shell介绍Shell在计算机科学中俗称“壳”,是提供给使用者使用界面的进行与系统交互的软件,通过接收用户输入的命令执行相应的操作,Shell分为图形界面Shell和命令行式Shell。文件系统(FS)Shell包含了各种的类Shell的命...

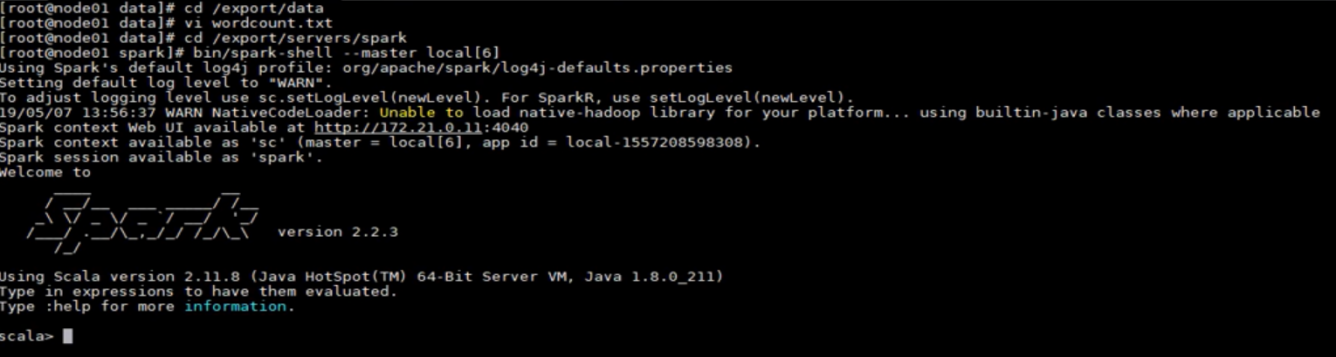

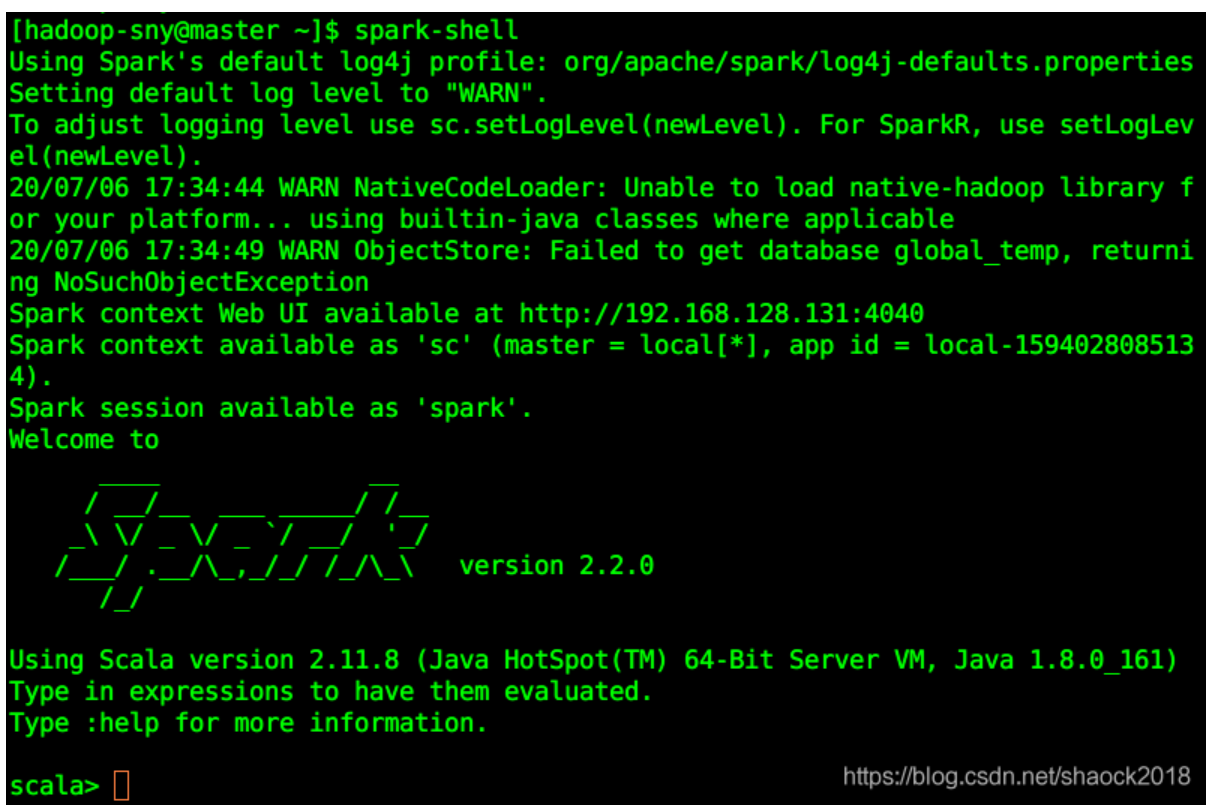

使用Spark shell

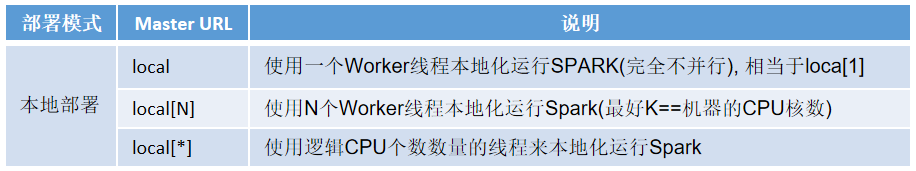

1. 实验室名称:大数据实验教学系统2. 实验项目名称:使用Spark shell3. 实验学时:4. 实验原理:spark-shell命令及其常用的参数如下: ./bin/spark-shell [options] Spark的运行模式取决于传递给SparkContext的Master...

Spark Shell笔记

学习感悟(1)学习一定要敲,感觉很简单,但是也要敲一敲,不要眼高手低(2)一定要懂函数式编程,一定,一定(3)shell中的方法在scala写的项目中也会有对应的方法(4)sc和spark是程序的入口,直接用SparkShell启动SparkShell./bin/spark-shellWordCou...

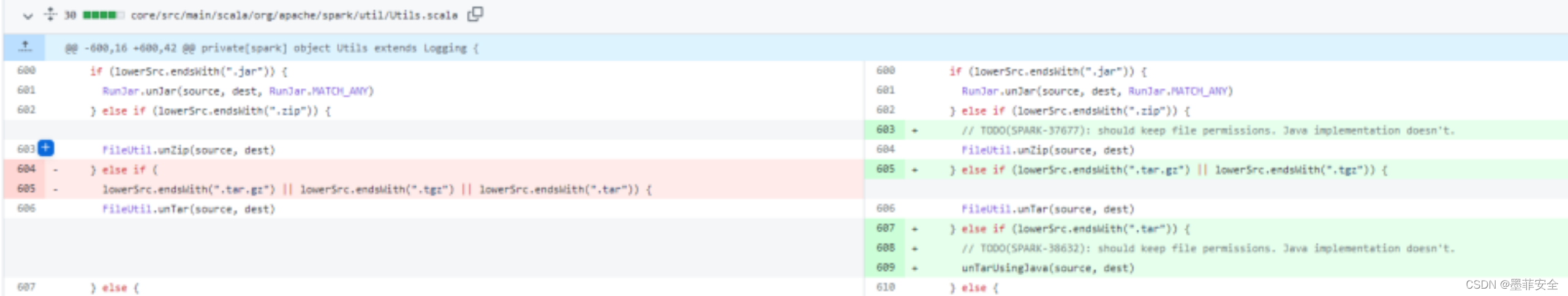

【墨菲安全实验室】Spark(3.1.2, 3.2.1, 3.3.0版本)shell命令注入漏洞

实验室昨天第一时间监测到的0day漏洞,目前已上线检测漏洞描述Spark 是用于大规模数据处理的统一分析引擎。由于 Hadoop 中"org.apache.hadoop.fs.FileUtill"类的“unTar”中针对 tar 文件的处理调了系统命令去解压,造成了 shell 命令注入的风险。攻击...

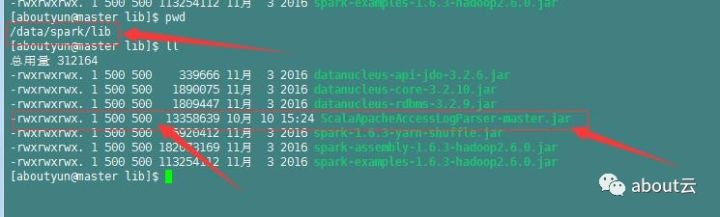

日志分析实战之清洗日志小实例3:如何在spark shell中导入自定义包

加载包上一篇文章,生成了包,那么这个包该如何加载到spark环境中,并且为我们所使用。那么首先改如何加载这个包。首先将这个包放到spark中的lib文件夹下。在复制到Linux中,首先需要修改的就是权限。我们看到用户和组的权限为500,并且用户,所属组,及其它用户都为满权限,可以通过下...

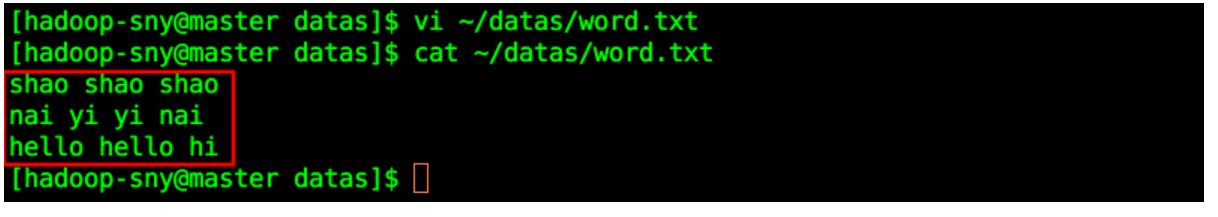

Spark 入门_Spark Shell 本地文件读取|学习笔记

开发者学堂课程【大数据 Spark2020最新课程(知识精讲与实战演练)第一阶段:Spark 入门_Spark Shell 本地文件读取】学习笔记,与课程紧密联系,让用户快速学习知识。课程地址:https://developer.aliyun.com/learning/course/688/deta...

Spark Shell入门教程(下)

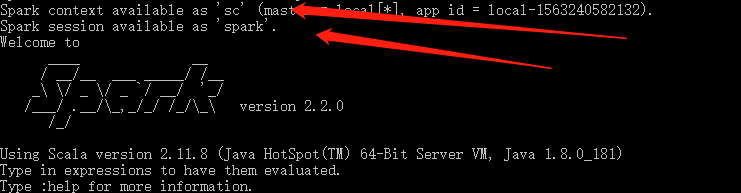

根据回显信息可知,其实在启动 Spark Shell 的时候,已经给我们实例化出了两个非常关键的对象: SparkContext 对象(sc)、SparkSession对象(spark),此处使用到的是SparkContext 对象,那么教程里的 SparkContext...

Spark Shell入门教程(上)

0x00 教程内容Spark Shell 操作测试词频统计案例Pyspark 初体验学习前提:有一定的Scala基础、基本的 Linux 基础,对Spark有一定的概念,并且安装好了Spark环境。相关环境参考教程:1、分布式集群环境之Scala的安装与配置(Centos7)2、分布式集群环境之Sp...

用spark shell执行操作hive

一、安装:(注意版本兼容)hadoop2.7.2,hive1.3,spark1.6二、相关配置:hive配置hive-site.xml:把hive-site.xml拷贝至spark的conf目录下并添加:<property> <name>hive.metastore.uris...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。