[帮助文档] 如何使用Flume同步EMRKafka集群的数据至阿里云OSS-HDFS服务

本文为您介绍如何使用Flume同步EMR Kafka集群的数据至阿里云OSS-HDFS服务。

Flume实现Kafka数据持久化存储到HDFS

一、场景描述对于一些实时产生的数据,除了做实时计算以外,一般还需要归档保存,用于离线数据分析。使用Flume的配置可以实现对数据的处理,并按一定的时间频率存储,本例中将从Kafka中按天存储数据到HDFS的不同文件夹。1. 数据输入本场景中数据来自Kafka中某个Topic订阅,数据格式为json。...

Flume 读取本地数据输出到 HDFS/Kafka

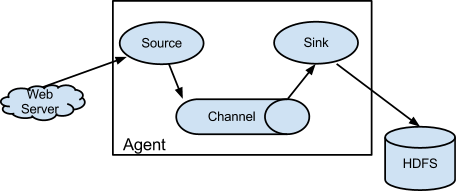

一、介绍Flume是一种分布式,可靠且可用的服务,用于有效地收集,聚合和移动大量日志数据。它具有基于流数据流的简单灵活的体系结构。它具有可调整的可靠性机制以及许多故障转移和恢复机制,具有强大的功能和容错能力。它使用一个简单的可扩展数据模型,允许在线分析应用程序。1.9.0版是Flume的第11版,是...

[帮助文档] 如何使用Flume同步数据至JindoFS服务

本文为您介绍如何使用Flume同步EMR Kafka集群的数据至阿里云OSS-HDFS(JindoFS服务)。

[帮助文档] 如何同步EMRDataFlow数据至EMRDataLake的HDFS

本文为您介绍如何同步EMR DataFlow集群的数据至EMR DataLake集群的HDFS。

请问,使用flume 消费kafka数据,上传到hdfs,出现重复消费的数据,是什么原因导致的呢

请问,使用flume 消费kafka数据,上传到hdfs,出现重复消费的数据,是什么原因导致的呢

flink 在别的集群里面运行,我怎么将kafka数据写到远程hdfs

flink 在别的集群里面运行,我怎么将kafka数据写到远程hdfs

flink消费kafka的数据写入到hdfs中,我采用了BucketingSink 这个sink将o

flink消费kafka的数据写入到hdfs中,我采用了BucketingSink 这个sink将operator出来的数据写入到hdfs文件上,并通过在hive中建外部表来查询这个。但现在有个问题,处于in-progress的文件,hive是无法识别出来该文件中的数据,可我想能在hive中实时查询...

flink将kafka中的数据落地到hdfs,在小文件和落地效率方面有什么好的建议?

背景: 现在使用的是spark streaming消费kafka的数据,然后落地到hdfs目录,产生了2个问题: 1、对于数据量较大的topic,且使用压缩存储之后,spark streaming程序会出现延迟。 2、落地的数据文件里有大量的小文件产生,namenode的压力增大 对于问题1,暂时分...

使用EMR-Flume同步Kafka数据到HDFS

使用EMR-Flume同步Kafka数据到HDFS 1. 背景 Flume是一个分布式、可靠和高效的数据汇聚系统,其source、channel和sink的结构设计,不仅实现了数据生产者与消费者的解耦,还提供了数据缓冲的功能。Flume支持多种source、channel和sink,也可以实现自定义...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

云消息队列 Kafka 版您可能感兴趣

- 云消息队列 Kafka 版数据

- 云消息队列 Kafka 版python

- 云消息队列 Kafka 版hologres

- 云消息队列 Kafka 版java

- 云消息队列 Kafka 版字段

- 云消息队列 Kafka 版flink

- 云消息队列 Kafka 版mysql

- 云消息队列 Kafka 版功能

- 云消息队列 Kafka 版阿里云

- 云消息队列 Kafka 版组件

- 云消息队列 Kafka 版cdc

- 云消息队列 Kafka 版消费

- 云消息队列 Kafka 版分区

- 云消息队列 Kafka 版集群

- 云消息队列 Kafka 版配置

- 云消息队列 Kafka 版报错

- 云消息队列 Kafka 版同步

- 云消息队列 Kafka 版apache

- 云消息队列 Kafka 版安装

- 云消息队列 Kafka 版消息队列

- 云消息队列 Kafka 版topic

- 云消息队列 Kafka 版消息

- 云消息队列 Kafka 版sql

- 云消息队列 Kafka 版入门

- 云消息队列 Kafka 版消费者

- 云消息队列 Kafka 版实战

- 云消息队列 Kafka 版原理