SPARK Parquet嵌套类型的向量化支持以及列索引(column index)

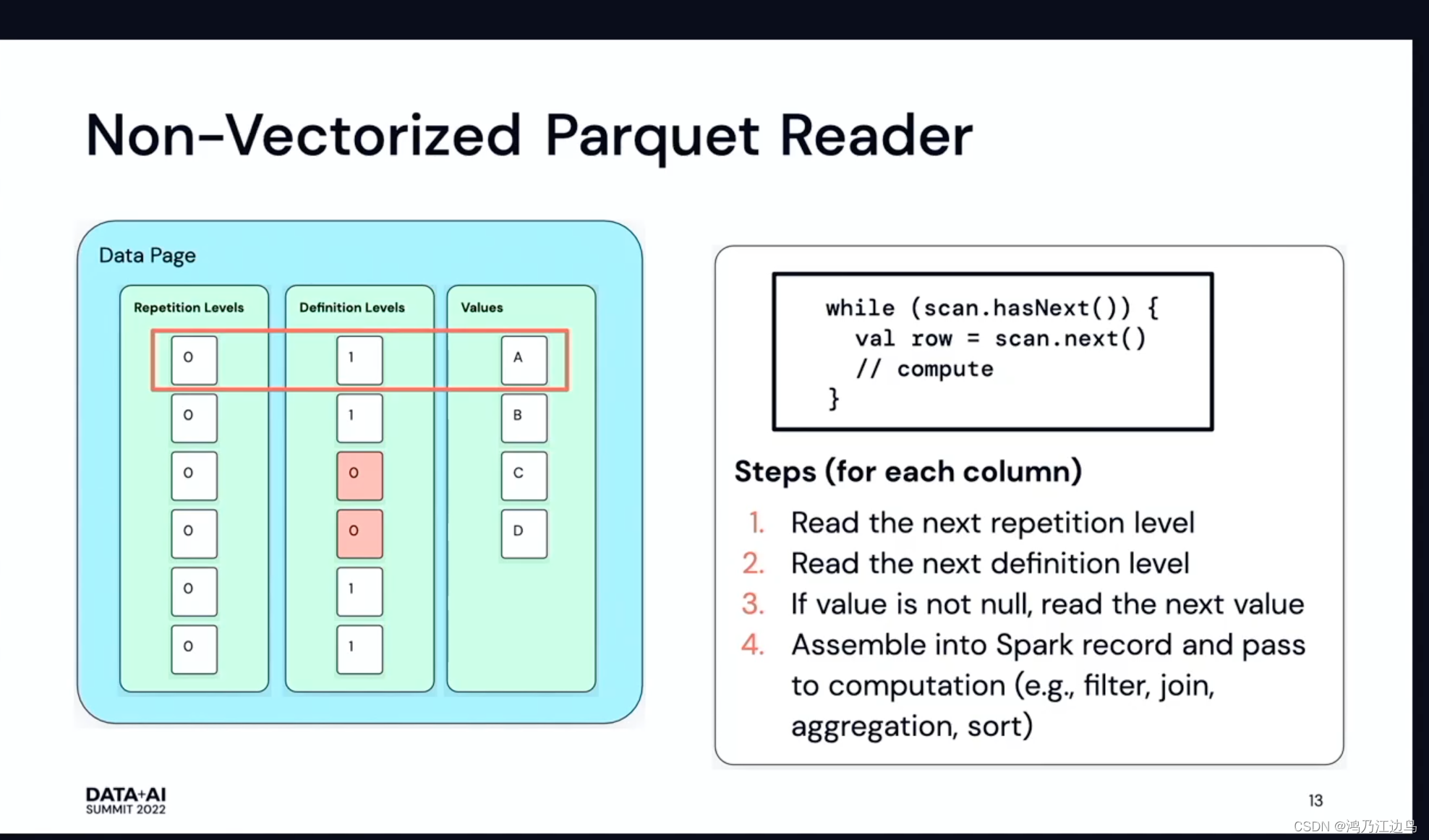

背景本文基于Spark 3.3.0列式存储Parquet文件越来越受到工业界的青睐,在delta以及Spark中应用广泛,具体的项目见:parquet-mr分析Parquet格式关于parquet的格式存储以及读取,可以参考大数据列存标准格式 - Parquet,总结一下就是:Parquet采用类似...

Pandas vs Spark:获取指定列的N种方式

无论是pandas的DataFrame还是spark.sql的DataFrame,获取指定一列是一种很常见的需求场景,获取指定列之后可以用于提取原数据的子集,也可以根据该列衍生其他列。在两个计算框架下,都支持了多种实现获取指定列的方式,但具体实现还是有一定区别的。01 pd.DataFrame获取指...

Python Spark Dataframe:将字符串列转换为时间戳

我有时间列,它具有对象数据类型,并包含以下格式的值: 0 days 01:30:00.0 我想将上述时间列更改为HH:mm:ss的格式,以使其看起来像以下格式: 01:30:00 我使用以下代码将其转换为所需的格式: df.withColumn('TIME_timestamp',F.to_times...

spark从cassandra的某个表中取出部分列的数据怎么写? 这样的话岂不是只能先把全部数据加载出来才过滤?

spark从cassandra的某个表中取出部分列的数据怎么写?这样的话岂不是只能先把全部数据加载出来才过滤?

获取数组中项目的索引,该数组是Spark数据帧中的列

我可以通过执行以下操作,根据数组字段中是否存在特定值来过滤Spark数据帧(在PySpark中):from pyspark.sql.functions import array_containsspark_df.filter(array_contains(spark_df.array_column_...

Apache Spark 2.0:Expression-string到orderBy()/ sort()列的降序

from pyspark.sql import functions as sFn # Note: I import Spark functions this way to avoid name collisions w/ Python. # Usage below: sFn.expr(), sFn....

Spark Scala - ML - Kmeans聚类预测列

我想在我的数据集中使用Kmeans算法后在我的数据集中添加预测列,我不知道如何实现这一点。下面是我到目前为止使用的代码(摘自spark文档)case class MyCase(sId: Int, tId:Int, label:Double, sAuthors:String, sYear:Int, s...

指定列的Spark sql问题

我们正在尝试将oracle db复制到hive中。我们从oracle获取查询并在hive中运行它们。所以,我们以这种格式得到它们:INSERT INTO schema.table(col1,col2) VALUES ('val','val');虽然此查询直接在Hive中工作,但当我使用spark.s...

Spark在不同列上多次加入相同的数据集

我有两个数据集。 code,nameIN,IndiaUS,United StatesUK,United KingdomSG,Singapore id,name,code1,code2,code31,abc,UK,SG,US2,efg,SG,UK,US我们可以将code1,code2和code3与第一...

如何将Spark Dataframe列的每个值作为字符串传递给python UDF?

我正在尝试GPG加密spark数据帧列 FNamedf = spark.createDataFrame([('Andy', 'NY'), ('Bob', 'PA'), ('Cindy', 'DC')], ("FName", "City"))我创建了一个udf,它将字符串值作为输入,并将加密字符串作为...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

社区圈子

apache spark您可能感兴趣

- apache spark Hadoop

- apache spark数据

- apache spark分析

- apache spark Python

- apache spark可视化

- apache spark数据处理

- apache spark入门

- apache spark大数据

- apache spark配置

- apache spark安装

- apache spark SQL

- apache spark streaming

- apache spark Apache

- apache spark rdd

- apache spark MaxCompute

- apache spark运行

- apache spark集群

- apache spark summit

- apache spark模式

- apache spark学习

- apache spark实战

- apache spark机器学习

- apache spark Scala

- apache spark flink

- apache spark程序

- apache spark操作