flink sql数据写入kafka,会出现key为before、after及op,怎么把这些去掉?

flink sql数据写入kafka,会出现key为before、after及op,怎么把这几个去掉?我写入的数据直接是json格式

Flink CDC里有没有什么方法 oss 实时同步数据到kafka?

Flink CDC里有没有什么方法 oss 实时同步数据到kafka?

[帮助文档] 使用UDAF实现数据排序和聚合

本文提供了一个自定义聚合函数(UDAF),实现将多行数据合并为一行并按照指定列进行排序,并以居民用电户电网终端数据为例,介绍如何在实时计算控制台使用该函数进行数据聚合和排序。

Flink CDC里问下增量数据可以不写进kafka,直接写进下游数据库吗?

Flink CDC里问下增量数据可以不写进kafka,直接写进下游数据库吗?

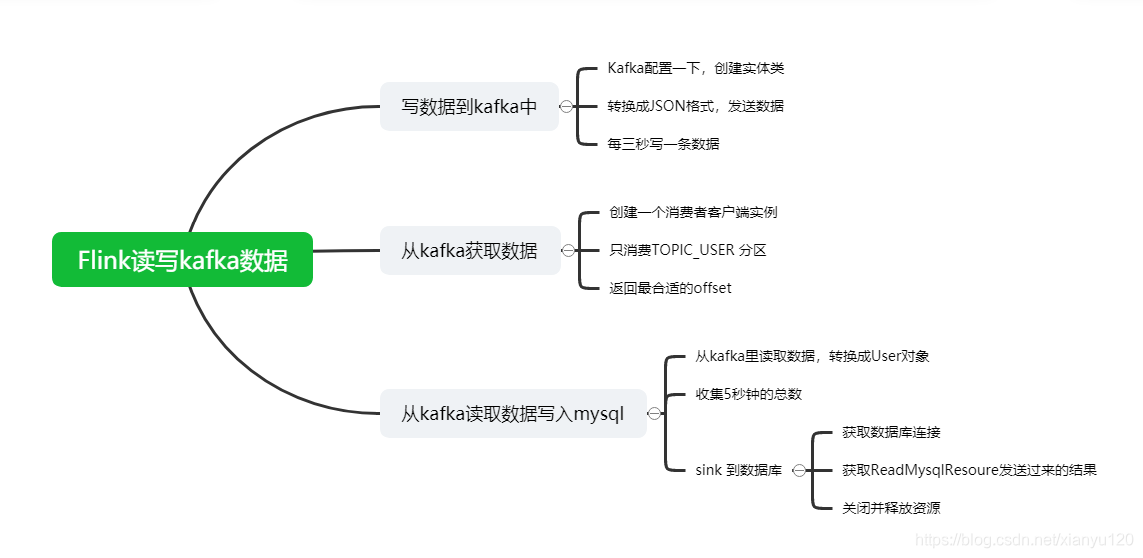

Flink最后一站___Flink数据写入Kafka+从Kafka存入Mysql

前言大家好,我是ChinaManor,直译过来就是中国码农的意思,我希望自己能成为国家复兴道路的铺路人,大数据领域的耕耘者,平凡但不甘于平庸的人。今天为大家带来Flink的一个综合应用案例:Flink数据写入Kafka+从Kafka存入Mysql第一部分:写数据到kafka中public stati...

Flink如何消费这些规则数据 和kafka的日志流进行关联匹配呢?

配置规则的数据存放在MySQL,这些规则会有增删改的情况,Flink如何消费这些规则数据 和kafka的日志流进行关联匹配呢? 例如 配置规则id=1 ,日志流中有id=1的字段就更新为id=AAA

在Flink我从holo读取数据,数据往kafka 写,好像差12个小时, 有没有参数哪里可以配置 ?

这是因为在Flink中,时间戳默认是以毫秒为单位的,而在HoloDB中,时间戳默认是以纳秒为单位的。因此,需要将HoloDB中的时间戳转换为Flink中使用的毫秒时间戳。你可以通过设置connector.read.format.stringtimeformat参数为yyyy-MM-dd HH:mm:...

在Flink我从holo读取数据,数据往kafka 写,好像差12个小时,有没有参数哪里可以配置 ?

在Flink我从holo读取数据,数据往kafka 写,好像差12个小时, 有没有参数哪里可以配置 ?

用flink cdc同步rds上的mysql数据到kafka里,请问这是什么情况?

用flink cdc同步rds上的mysql数据到kafka里,但是每次update的时候会被拆成一个create和一个delete事件。请问这是什么情况,我如果需要update时输出update事件该怎么处理?

Flink CDC想starRocks的物化视图中更新或者新加的数据实时推到kafka这些消息队列?

Flink CDC想starRocks的物化视图中更新或者新加的数据实时推到kafka这些消息队列?

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

实时计算 Flink版数据相关内容

- 实时计算 Flink版函数数据

- 实时计算 Flink版数据flinksql

- 实时计算 Flink版mysql数据

- 实时计算 Flink版kafka数据

- 实时计算 Flink版数据字段

- 实时计算 Flink版数据资源

- 实时计算 Flink版sqlserver数据

- 实时计算 Flink版数据增量

- 实时计算 Flink版数据目标

- 实时计算 Flink版库数据

- 实时计算 Flink版数据连接

- 数据实时计算 Flink版

- 实时计算 Flink版配置数据

- 实时计算 Flink版同步数据

- 实时计算 Flink版cdc mysql数据

- 实时计算 Flink版单表数据

- 实时计算 Flink版数据binlog

- 实时计算 Flink版全量数据

- 实时计算 Flink版程序数据

- 实时计算 Flink版初始化数据

- 实时计算 Flink版增量同步数据

- 实时计算 Flink版任务数据

- 实时计算 Flink版数据doris

- 实时计算 Flink版窗口数据

- 实时计算 Flink版数据参数

- 实时计算 Flink版字段数据

- 实时计算 Flink版数据重启

- 实时计算 Flink版数据作业

- 实时计算 Flink版cdc监听数据

- 实时计算 Flink版es数据

- 实时计算 Flink版监听数据

- 实时计算 Flink版表数据数据

- 实时计算 Flink版同步es数据

- 实时计算 Flink版代码数据

- 实时计算 Flink版设置数据

- 实时计算 Flink版流数据数据

- 实时计算 Flink版数据源数据

- 实时计算 Flink版oracle数据

- 实时计算 Flink版同步oracle数据

- 实时计算 Flink版数据乱码

- 实时计算 Flink版数据类型字段

- 实时计算 Flink版数据decimal

- 实时计算 Flink版数据程序

- 实时计算 Flink版库采集数据

- 实时计算 Flink版采集数据

- 实时计算 Flink版pg数据

- 实时计算 Flink版数据增量同步

- 实时计算 Flink版库数据报错

- 实时计算 Flink版oracle数据报错

实时计算 Flink版更多数据相关

- 实时计算 Flink版增量数据

- 实时计算 Flink版数据报错

- 实时计算 Flink版数据配置

- 实时计算 Flink版维表数据

- 实时计算 Flink版sink数据

- 实时计算 Flink版数据任务

- 实时计算 Flink版数据sink

- 实时计算 Flink版source数据

- 实时计算 Flink版日志数据

- 实时计算 Flink版数据变更

- 实时计算 Flink版捕获数据

- 实时计算 Flink版doris数据

- 实时计算 Flink版数据设置

- 实时计算 Flink版连接数据

- 实时计算 Flink版数据checkpoint

- 实时计算 Flink版运行数据

- 实时计算 Flink版数据hudi

- 实时计算 Flink版jdbc数据

- 实时计算 Flink版报错数据

- 实时计算 Flink版oracle同步数据

- 实时计算 Flink版库同步数据

- 实时计算 Flink版hive数据

- 实时计算 Flink版checkpoint数据

- 实时计算 Flink版监控数据

- 实时计算 Flink版全量同步数据

- 实时计算 Flink版数据hive

- 实时计算 Flink版postgresql数据

- 实时计算 Flink版mongodb数据

- 实时计算 Flink版hudi数据

- 实时计算 Flink版变更数据

- 实时计算 Flink版类型数据

- 实时计算 Flink版数据办法

- 实时计算 Flink版同步全量数据

- 实时计算 Flink版数据异常

- 实时计算 Flink版job数据

- 实时计算 Flink版快照数据

- 实时计算 Flink版参数数据

- 实时计算 Flink版json数据

- 实时计算 Flink版实时同步数据

- 实时计算 Flink版模式数据

- 实时计算 Flink版重启数据

- 实时计算 Flink版数据null

- 实时计算 Flink版数据窗口

- 实时计算 Flink版datastream数据

- 实时计算 Flink版flinksql数据

- 实时计算 Flink版计算数据

- 实时计算 Flink版数据版本

- 实时计算 Flink版tidb数据

- 实时计算 Flink版数据表

- 实时计算 Flink版insert数据

实时计算 Flink版您可能感兴趣

- 实时计算 Flink版作业

- 实时计算 Flink版合流

- 实时计算 Flink版窗口

- 实时计算 Flink版算子

- 实时计算 Flink版重跑

- 实时计算 Flink版方案

- 实时计算 Flink版多表

- 实时计算 Flink版es

- 实时计算 Flink版函数

- 实时计算 Flink版同步

- 实时计算 Flink版报错

- 实时计算 Flink版任务

- 实时计算 Flink版oracle

- 实时计算 Flink版版本

- 实时计算 Flink版表

- 实时计算 Flink版配置

- 实时计算 Flink版设置

- 实时计算 Flink版 CDC

- 实时计算 Flink版模式

- 实时计算 Flink版运行

- 实时计算 Flink版数据库

- 实时计算 Flink版连接

- 实时计算 Flink版库

- 实时计算 Flink版全量

- 实时计算 Flink版参数

- 实时计算 Flink版日志

- 实时计算 Flink版集群