Flink CDC里tidb 支持exactly once 这个bug啥时修复?

Flink CDC里tidb 支持exactly once 这个bug啥时修复?

读Flink源码谈设计:Exactly Once

本文首发于泊浮目的语雀:https://www.yuque.com/17sing 版本 日期 备注 1.0 2022.2.2 文章首发 1.1 2022.2.14 更新3.4部分,增强注释部分 1.2 2022.2.27 更新3.6部分,删除部分对于1.14版本不...

三、【计算】Exactly Once 语义在Flink中的实现(下) | 青训营笔记

👉引言💎学习的最大理由是想摆脱平庸,早一天就多一份人生的精彩;迟一天就多一天平庸的困扰。 热爱写作,愿意让自己成为更好的人............铭记于心🎉✨🎉我唯一知道的,便是我一无所知🎉✨🎉三、端到端 Exactly-Once 实现1 名...

Exactly Once 语义在 Flink 中的实现|青训营笔记

课程资料课程链接:https://live.juejin.cn/4354/yc_Once课程PPT:https://bytedance.feishu.cn/file/boxcnFPburXr95rMNel1SHOvISg学员手册:https://juejin.cn/post/712275443137...

Flink CDC为了保证数据一致性,其中写入Kafka必须是Exactly Once吗?

Flink CDC消费MySQL写入到Kafka,再消费Kafka到另一个MySQL。为了保证数据一致性,其中写入Kafka必须是Exactly Once,还是At Least Once就可以?(因为binlog是ROW模式,即便是数据重复,只要保证数据顺序,是不是结果就是一致的?)

flink任务每次重启的时候会丢失一些数据,请问大家有遇到过吗?设置了exactly - once,

flink任务每次重启的时候会丢失一些数据,请问大家有遇到过吗?设置了exactly - once,跟我杀死job的时候和重启没有用savepoint,有关系吗?

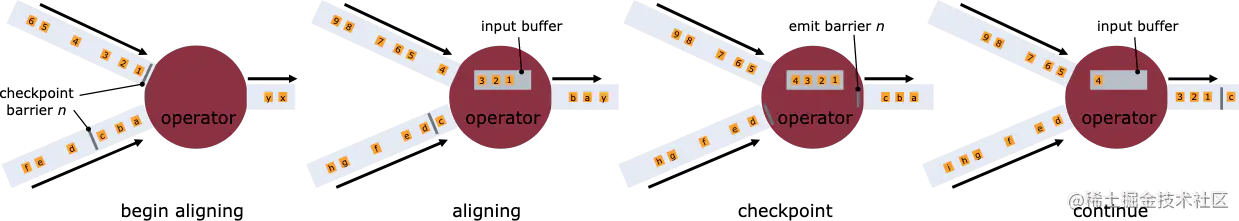

Exactly Once语义在Flink中的实现

💨数据流和动态表传统的SQL:🚩处理的表是有界的🚩执行查询可以访问完整的数据🚩批处理查询产生固定大小结果后终止流处理:🚩流是一个无限元组序列🚩执行查询无法访问所有数据🚩查询不断更新结果,永不终止👇数据流和动态表转换如下不同数据处...

技术解析|Doris Connector 结合 Flink CDC 实现 MySQL 分库分表 Exactly Once 精准接入

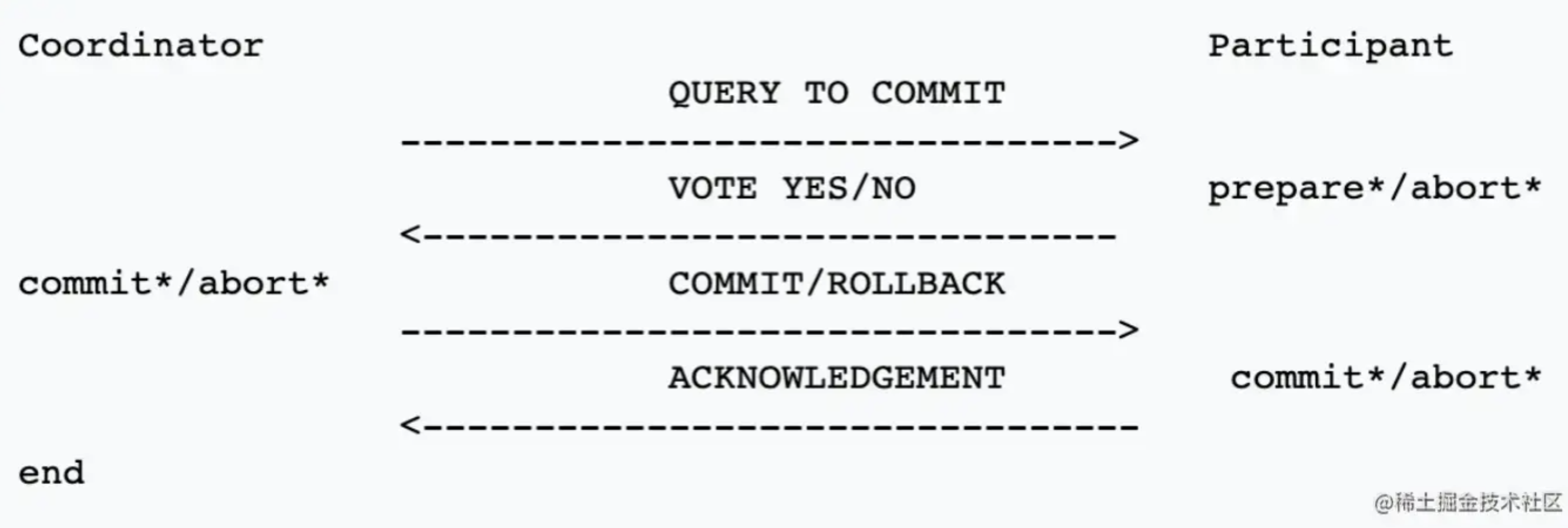

本篇文档将演示如何使用 Apache Doris Flink Connector 结合 Flink CDC 以及 Doris Stream Load 的两阶段提交,实现 MySQL 数据库分库分表实时高效接入,并实现 Exactly Once。一、概述在实际业务系统中为了解决单表数据量大带来的各种问...

Apache中Flink提供的Exactly once的一致性保证是什么意思?

Apache中Flink提供的Exactly once(严格一次)的一致性保证是什么意思?

Flink连接器这块,如果是sink到mysql,ES等,有对应的实现exactly once语义么

Flink连接器这块,如果是sink到mysql,ES等,有对应的实现exactly once语义么? 比如kafka的连接有sink的exactly once语义,sink时候指定即可. 那么,如果是mysql后者其他的有么? 谢谢. return new FlinkKafkaProducer01...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

实时计算 Flink版您可能感兴趣

- 实时计算 Flink版并行度

- 实时计算 Flink版数据

- 实时计算 Flink版回滚

- 实时计算 Flink版同步

- 实时计算 Flink版批处理

- 实时计算 Flink版任务

- 实时计算 Flink版作业

- 实时计算 Flink版合流

- 实时计算 Flink版窗口

- 实时计算 Flink版算子

- 实时计算 Flink版报错

- 实时计算 Flink版oracle

- 实时计算 Flink版版本

- 实时计算 Flink版表

- 实时计算 Flink版配置

- 实时计算 Flink版设置

- 实时计算 Flink版 CDC

- 实时计算 Flink版模式

- 实时计算 Flink版运行

- 实时计算 Flink版数据库

- 实时计算 Flink版连接

- 实时计算 Flink版库

- 实时计算 Flink版全量

- 实时计算 Flink版参数

- 实时计算 Flink版集群

- 实时计算 Flink版日志