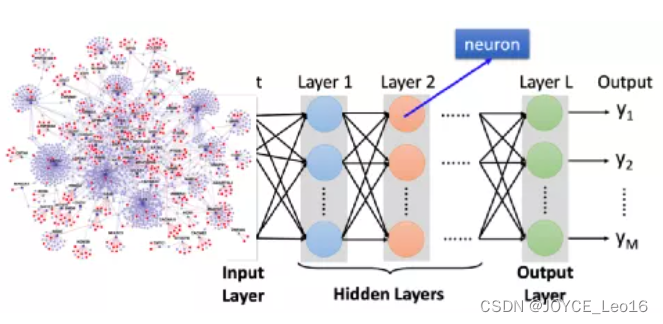

神经网络结构——CNN、RNN、LSTM、Transformer !!

前言 本文将从什么是CNN?什么是RNN?什么是LSTM?什么是Transformer?四个问题,简单介绍神经网络结构。 神经网络结构 ...

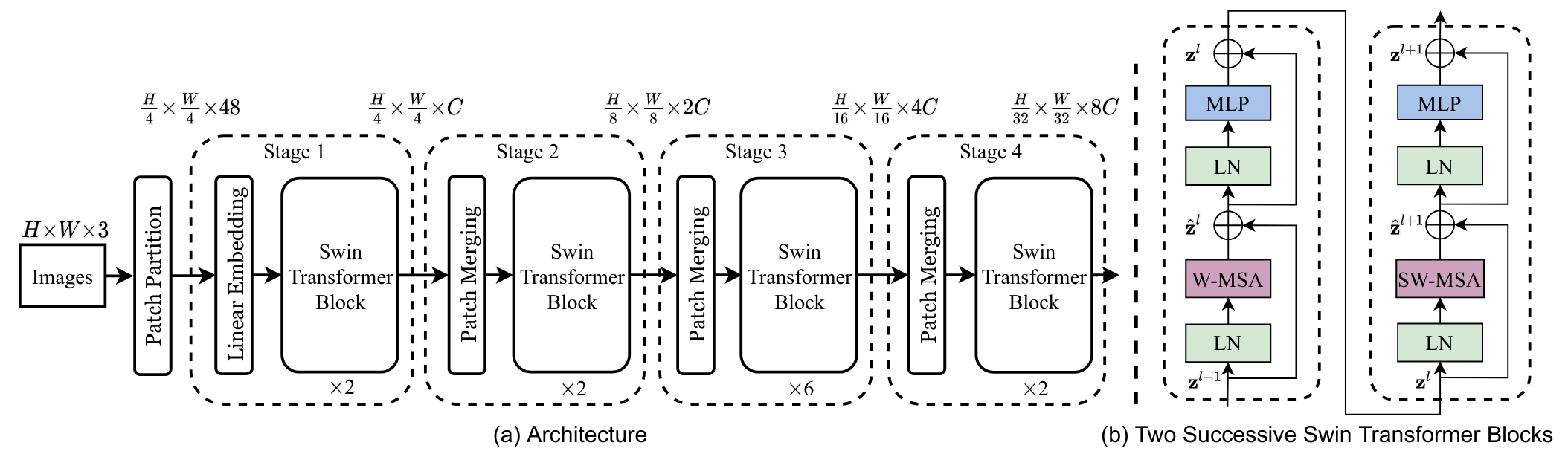

神经网络算法 —— 一文搞懂Transformer !!

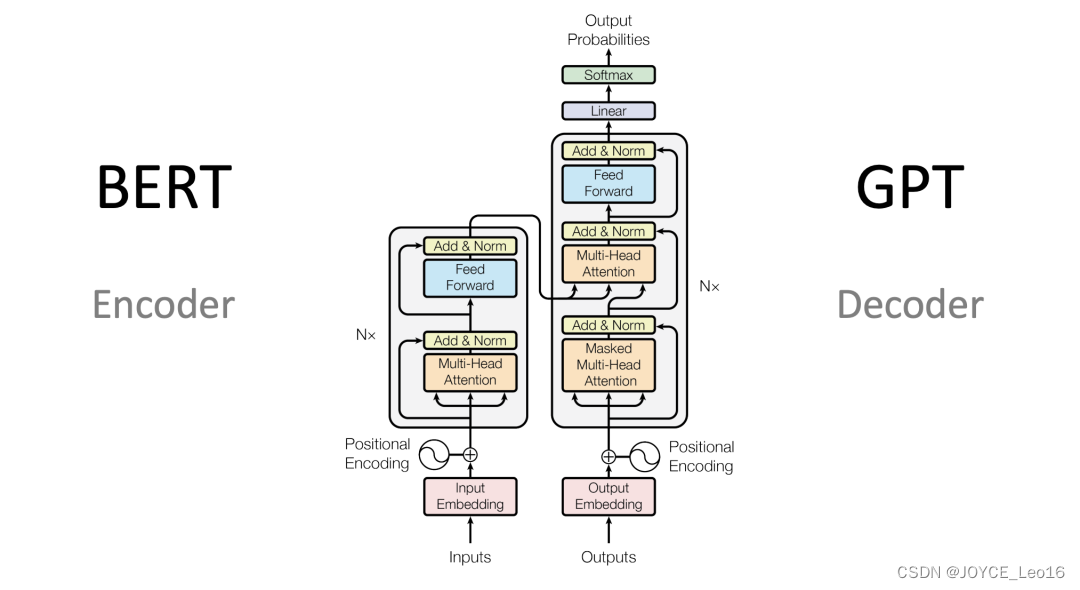

前言 本文将从 Transformer的本质、Transformer的原理 和 Transformer架构改进三个方面,搞懂Transformer。 ...

![大语言模型的预训练[1]:基本概念原理、神经网络的语言模型、Transformer模型原理详解、Bert模型原理介绍](https://ucc.alicdn.com/fnj5anauszhew_20230717_e843a02529534b84bf8ff46d8b43e094.png)

大语言模型的预训练[1]:基本概念原理、神经网络的语言模型、Transformer模型原理详解、Bert模型原理介绍

大语言模型的预训练[1]:基本概念原理、神经网络的语言模型、Transformer模型原理详解、Bert模型原理介绍 1.大语言模型的预训练 1.LLM预训练的基本概念 预训练属于迁移学习的范畴。现有的神经网络在进行训练时,一般基于反向传播(Back Propagation,BP)算法,先对网络中的...

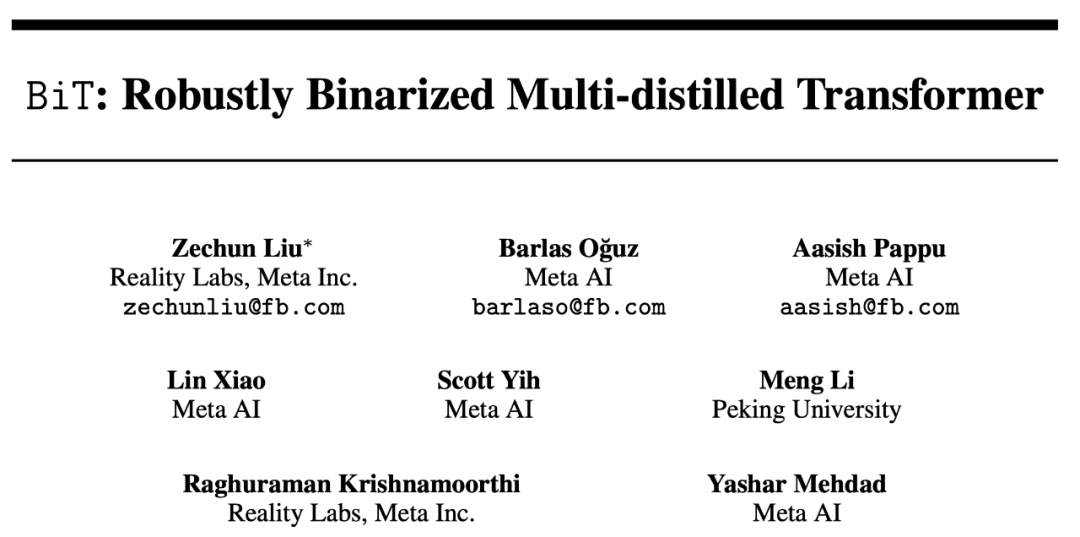

NeurIPS 2022 | Meta 提出二值transformer网络BiT,刷新NLP网络压缩极限

神经网络压缩一直被视为机器学习模型从实验室走向工业应用中的不可或缺的一步,而量化 (quantization) 又是神经网络压缩中最常用的方法之一。今天这篇 NeurIPS 论文 BiT 从实验和理论验证了极端压缩情况下的 1-bit 的 BERT 网络也能在自然语言处理的分类数据集 GLUE 上取...

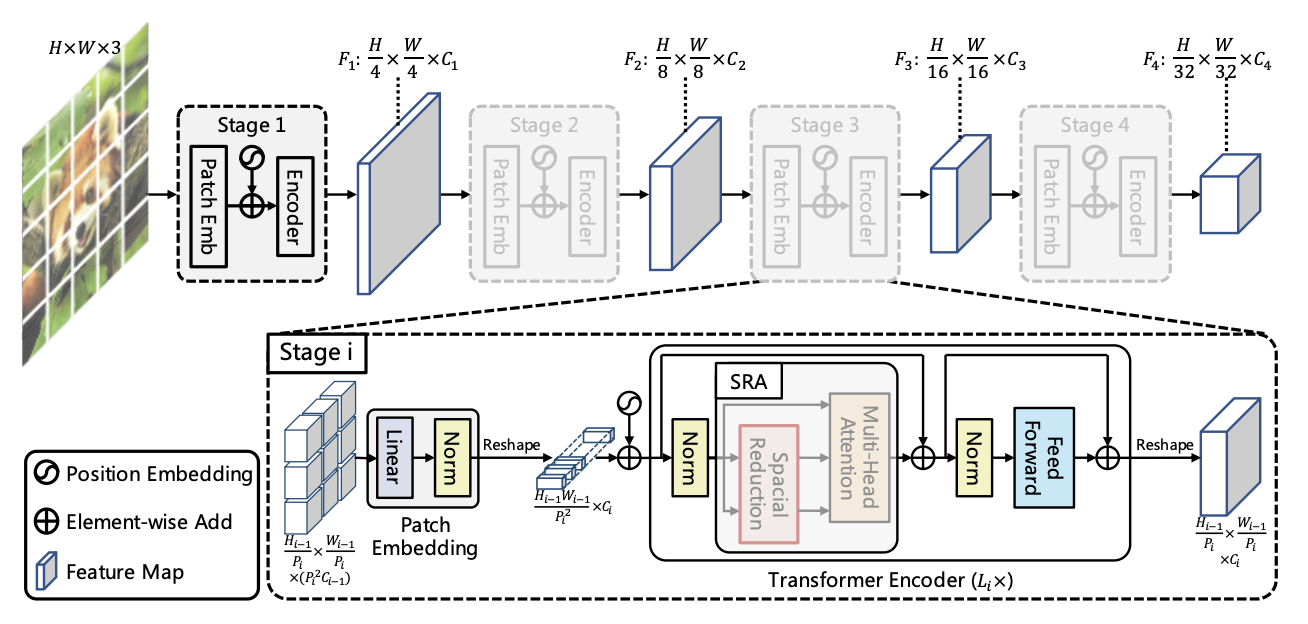

高效神经网络架构的正确打开方式! | EMO:结合 CNN 和 Transformer

Title: Rethinking Mobile Block for Efficient Neural ModelsAuthor:Jiangning Zhang et al. (腾讯优图、浙大、北大、武大)Paper: https://arxiv.org/pdf/2301.01146Github: ...

高效神经网络架构的正确打开方式 | EMO:结合 CNN 和 Transformer 的现代倒残差移动模块设计

Title: Rethinking Mobile Block for Efficient Neural ModelsAuthor:Jiangning Zhang et al. (腾讯优图、浙大、北大、武大)Paper: https://arxiv.org/pdf/2301.01146Github: ...

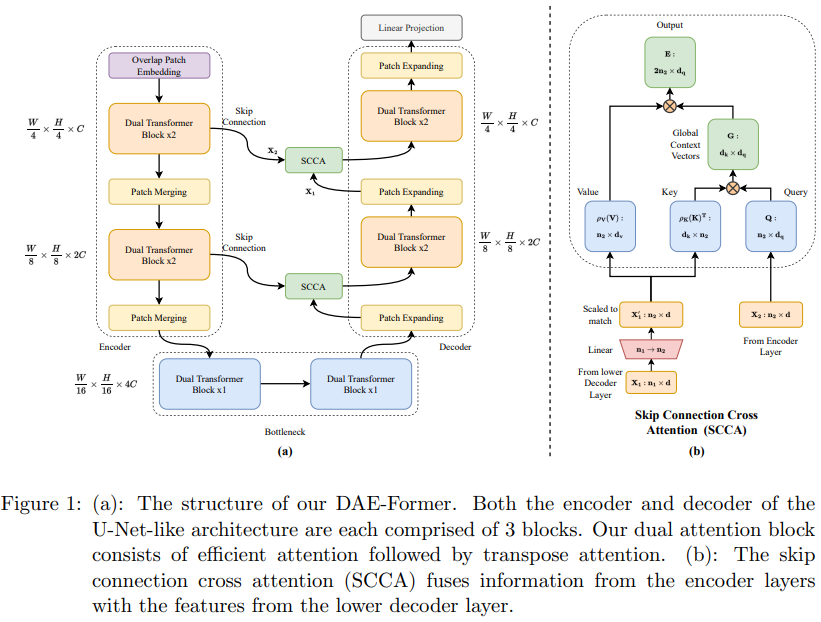

卷麻了 | DAE-Former:高效双重注意力引导的Transformer网络称霸医学图像分割任务

Title: DAE-Former: Dual Attention-guided Efficient Transformer for Medical Image SegmentationAuthor: Reza Azad et al. (亚琛工业大学)Paper: https://arxiv.org...

NeuraIPS 2022 | 最新类别感知对抗Transformer分割网络CASTformer

Title: Class-Aware Adversarial Transformers for Medical Image SegmentationPaper: https://arxiv.org/pdf/2201.10737v5.pdf | Accepted by NeurlIPS 2022Aut...

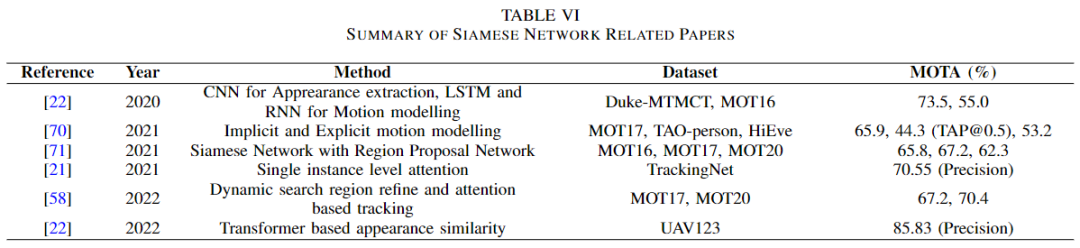

万字长文 | 多目标跟踪最新综述(基于Transformer/图模型/检测和关联/孪生网络)(下)

Siamese Network两帧之间的相似性信息对目标跟踪有很大的帮助。因此,Siamese网络试图学习相似之处,并区分输入。该网络由两个并行子网络共享相同的权值和参数空间。最后将双子网络之间的参数绑定在一定的损失函数上进行训练,以度量双子网络之间的语义相似度。下表给出了Siamese网络在MOT...

万字长文 | 多目标跟踪最新综述(基于Transformer/图模型/检测和关联/孪生网络)(上)

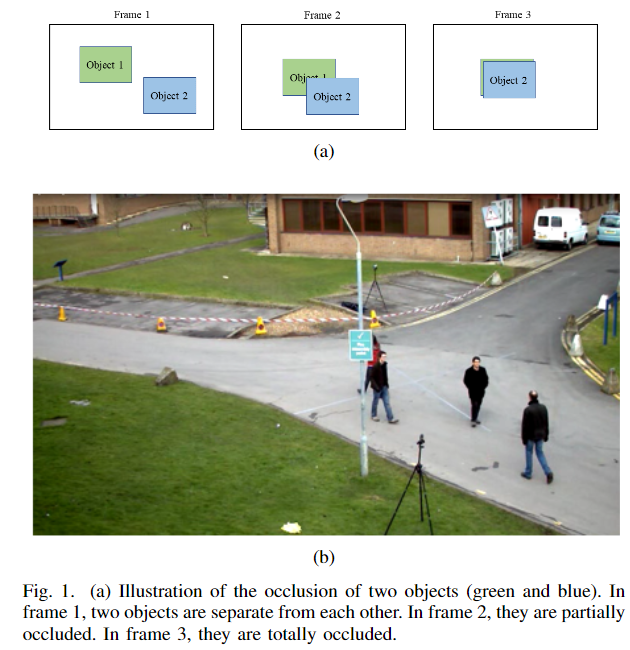

摘要随着自动驾驶技术的发展,多目标跟踪已成为计算机视觉领域研究的热点问题之一。MOT 是一项关键的视觉任务,可以解决不同的问题,例如拥挤场景中的遮挡、相似外观、小目标检测困难、ID切换等。为了应对这些挑战,研究人员尝试利用transformer的注意力机制、利用图卷积神经网络获得轨迹的相关性、不同帧...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。