[帮助文档] 如何通过DataWorks数据集成同步异构数据源间的数据_云原生大数据计算服务 MaxCompute(MaxCompute)

本教程以MySQL中的用户基本信息(ods_user_info_d)表及OSS中的网站访问日志数据(user_log.txt)文件,通过数据集成离线同步任务分别同步至MaxCompute的ods_user_info_d、ods_raw_log_d表为例,为您介绍如何通过DataWorks数据集成实现...

[帮助文档] MaxCompute数据集成的实现方案_云原生大数据计算服务 MaxCompute(MaxCompute)

MaxCompute支持通过DataWorks数据集成功能将其他数据源数据同步至MaxCompute,数据集成作业主要有三种类型:离线同步、实时同步、同步解决方案。本文为您介绍MaxCompute数据集成的实现方案。

[帮助文档] 如何创建DataX类型任务

DataX任务类型,用于执行DataX程序。本文为您介绍创建DataX类型任务时涉及的参数。

[帮助文档] 如何通过数据集成实时入湖_大数据开发治理平台 DataWorks(DataWorks)

本文以Kafka实时入湖写入至OSS场景为例,为您介绍如何通过数据集成实时入湖。

大数据计算MaxCompute数据集成时,如果正常运行直到结束,那么就可以查到数据。但是如果终止那?

问题1:大数据计算MaxCompute数据集成时,如果正常运行直到结束,那么就可以查到数据。但是如果终止那么数据就不现实。这是为什么呢?问题2:那如果这个分区本来就有数据,我重新同步一遍,然后终止,那原来数据也会删除吗

大佬 ,大数据计算MaxCompute新版本数据集成,选择克隆操作,数据源不能筛选了?

大佬 ,大数据计算MaxCompute新版本数据集成,选择克隆操作,数据源不能筛选了?感觉有一丢丢不太方便

大数据计算MaxCompute数据集成到mysql的时候,导入前准备语句没执行,这个是什么情况啊?

大数据计算MaxCompute数据集成到mysql的时候,导入前准备语句没执行,这个是什么情况啊?

数据处理 、大数据、数据抽取 ETL 工具 DataX 、Kettle、Sqoop

@[toc] 数据处理 、大数据、数据抽取 ETL 工具 DataX 、Kettle、Sqoop 1、DataX 2、Kettle Kettle 一个开源的 ETL 工具,后面改名为 Pentaho Data Integration (但是国内仍然喜欢叫 Kettle) 参考 https://bai...

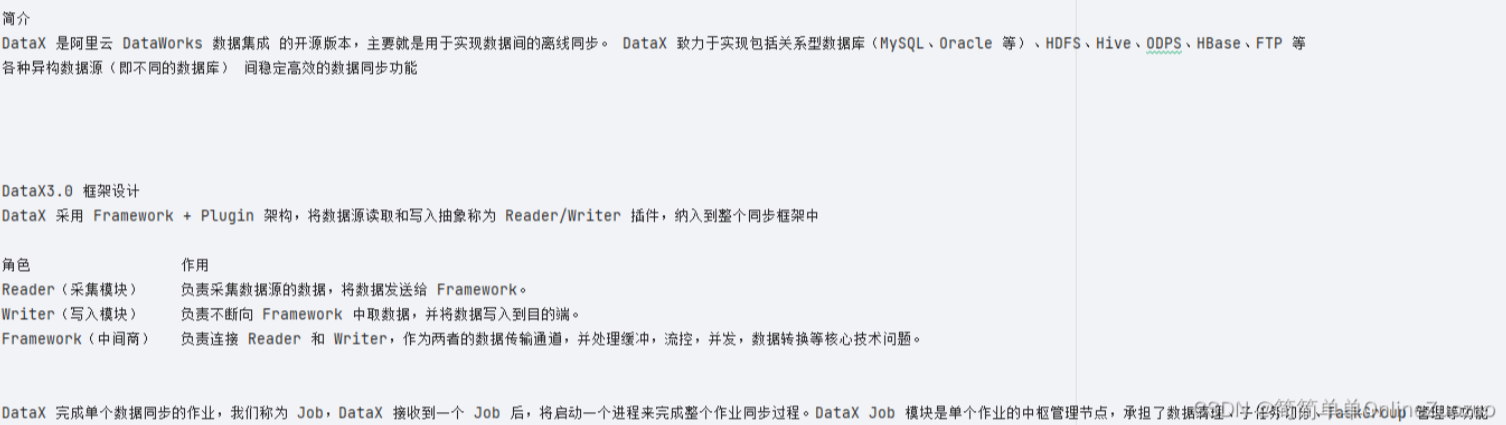

大数据数据采集的数据迁移(同步/传输)的Sqoop之DataX

DataX简介 DataX是一款可扩展、高效的数据集成框架,支持多种数据源之间的数据传输。它由阿里巴巴集团开发,通过配置文件来定义数据源和执行任务,可以快速地进行各种数据格式之间的转换。基本原理 DataX通过脚本或者Web界面来配置输入和输出的数据源,并通过插件机制实现了各种数据源之间的数据迁移。...

[帮助文档] 什么是Serverless StarRocks DataX Writer

DataX Writer插件实现了写入数据到StarRocks目的表的功能。在底层实现上,DataX Writer通过Stream Load以CSV或JSON格式导入数据至StarRocks。内部将Reader读取的数据进行缓存后批量导入至StarRocks,以提高写入性能。阿里云DataWorks...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

社区圈子

数据集成 Data Integration您可能感兴趣

- 数据集成 Data Integration公共资源

- 数据集成 Data Integration dataworks

- 数据集成 Data Integration资源组

- 数据集成 Data Integration资源

- 数据集成 Data Integration字段

- 数据集成 Data Integration数据

- 数据集成 Data Integration odps

- 数据集成 Data Integration映射

- 数据集成 Data Integration报错

- 数据集成 Data Integration任务

- 数据集成 Data Integration同步

- 数据集成 Data Integration数据源

- 数据集成 Data Integration配置

- 数据集成 Data Integration mysql

- 数据集成 Data Integration maxcompute

- 数据集成 Data Integration离线

- 数据集成 Data Integration数据同步

- 数据集成 Data Integration数据库

- 数据集成 Data Integration表

- 数据集成 Data Integration实时同步

- 数据集成 Data Integration flink

- 数据集成 Data Integration集成

- 数据集成 Data Integration治理

- 数据集成 Data Integration全链路