【Spark 应用】实现分组取topN

一、文本格式class1 90 class2 56 class1 87 class1 76 class2 88 class1 95 class1 74 class2 87 class2 67 class2 77二、代码如下package com.scala import org.apache.spa...

【Spark】(task2)PySpark数据统计和分组聚合

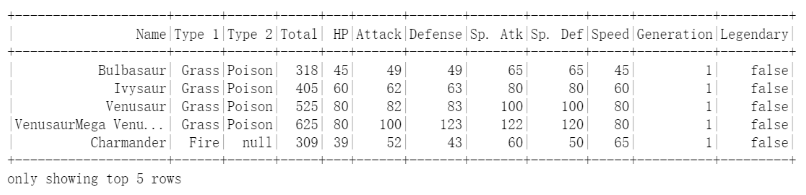

一、数据统计1.1 读取文件步骤1:读取文件https://cdn.coggle.club/Pokemon.csvimport pandas as pd from pyspark.sql import SparkSession # 创建spark应用 spark = SparkSession.bui...

如何使用Spark解决分组排序问题?

如何使用Spark解决分组排序问题?

Apache Spark:根据条件将不同的行分组在一起

我试图简化Apache Spark(Python)中的数据帧。我有这样的数据帧person X N A B C DNCC1701 1 16309 false true false falseNCC1864 1 16309 false false true false...我想对每一行的X和N进行分组...

spark 按照key 分组 然后统计每个key对应的最大、最小、平均值思路——使用groupby,或者reduceby

What you're getting back is an object which allows you to iterate over the results. You can turn the results of groupByKey into a list by calling list...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

社区圈子

apache spark您可能感兴趣

- apache spark Hadoop

- apache spark数据

- apache spark分析

- apache spark Python

- apache spark可视化

- apache spark数据处理

- apache spark入门

- apache spark大数据

- apache spark配置

- apache spark安装

- apache spark SQL

- apache spark streaming

- apache spark Apache

- apache spark rdd

- apache spark MaxCompute

- apache spark运行

- apache spark集群

- apache spark summit

- apache spark模式

- apache spark学习

- apache spark机器学习

- apache spark实战

- apache spark Scala

- apache spark flink

- apache spark程序

- apache spark操作