Flink DataStream keyby以后reduce,如果只想保留最后的结果有什么好办法吗?

Flink DataStream keyby 以后reduce,发现只是后一个记录的数值相加了,但原来第一个记录也还在reduce以后的流里面,记录并没有减少,如果只想保留最后的结果有什么好办法吗?

[AIGC] Flink中的Max和Reduce操作:区别及使用场景

Apache Flink提供了一系列的操作,用于对流数据进行处理和转换。在这篇文章中,我们将重点关注两种常见的操作:Max和Reduce。虽然这两种操作在表面上看起来类似——都是对数据进行一些形式的聚合,但它们在应用和行为上有一些关键的区别。 Max操作 Max操作是针对一个字段进行的,它返回当前观...

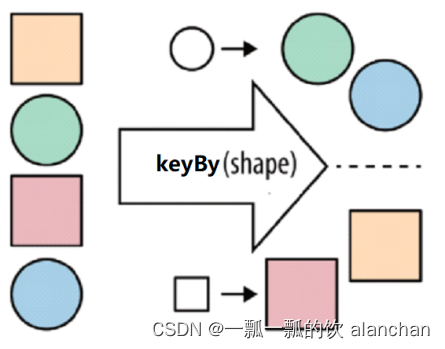

【flink番外篇】1、flink的23种常用算子介绍及详细示例(2)- keyby、reduce和Aggregations

Flink 系列文章一、Flink 专栏Flink 专栏系统介绍某一知识点,并辅以具体的示例进行说明。1、Flink 部署系列本部分介绍Flink的部署、配置相关基础内容。2、Flink基础系列本部分介绍Flink 的基础部分,比如术语、架构、编程模型、编程指南、基本的datastream api用...

Flink触发器定义了何时触发计算,但是reduce这种每来一个元素就计算?

Flink触发器定义了何时触发计算,但是reduce这种每来一个元素就计算。那是不是理解触发器和窗口函数有关系?但是文档说默认触发器和窗口分配器有关,似乎和窗口函数无关?

Flink CDC map reduce是什么意思啊?

Flink CDC map reduce是什么意思啊?

Flink CDC map reduce是什么东东?

Flink CDC map reduce是什么东东?

是否从Flink设计角度来说,就不支持在reduce和aggregate

Hi all, 在flink里面尝试使用RichReduceFunction和RichAggregateFunction,但是收到了UnsupportedOperationException。 看了下源代码,在reduce和aggregate方法里面会检测到是RichFunction的话就会直接抛异...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

实时计算 Flink版您可能感兴趣

- 实时计算 Flink版高斯

- 实时计算 Flink版db

- 实时计算 Flink版版本

- 实时计算 Flink版中文乱码

- 实时计算 Flink版cdc3.1

- 实时计算 Flink版新功能

- 实时计算 Flink版连接

- 实时计算 Flink版格式

- 实时计算 Flink版生产

- 实时计算 Flink版报错

- 实时计算 Flink版数据

- 实时计算 Flink版同步

- 实时计算 Flink版任务

- 实时计算 Flink版oracle

- 实时计算 Flink版表

- 实时计算 Flink版配置

- 实时计算 Flink版设置

- 实时计算 Flink版 CDC

- 实时计算 Flink版模式

- 实时计算 Flink版运行

- 实时计算 Flink版数据库

- 实时计算 Flink版库

- 实时计算 Flink版作业

- 实时计算 Flink版全量

- 实时计算 Flink版参数

- 实时计算 Flink版日志

- 实时计算 Flink版集群