微软开源DeepSpeed Chat,人人可快速训练百亿、千亿级ChatGPT大模型(33)

有效吞吐量和可扩展性分析(I) 有效吞吐量分析。在 RLHF 训练的第 3 阶段,DeepSpeed-HE 的有效吞吐量取决于它在生成和 RL 训练阶段所实现的吞吐量。在我们的 RLHF (详见 benchmarking setting)中,生成阶段占总计算的约 20%,而 RL 训练阶段占剩余的 ...

微软开源DeepSpeed Chat,人人可快速训练百亿、千亿级ChatGPT大模型(2)

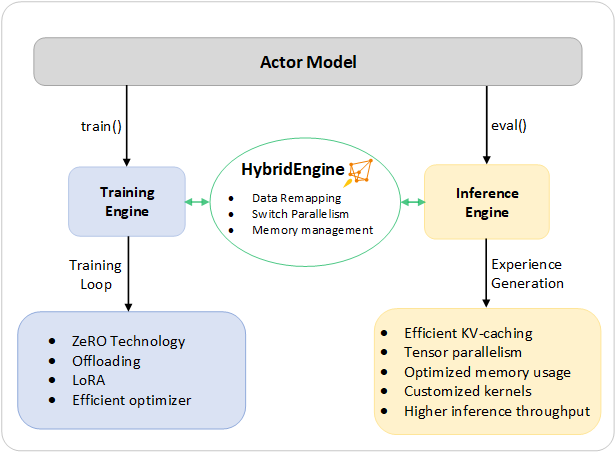

DeepSpeed Hybrid Engine统一的高效混合引擎为 RLHF 训练提供动力并进行优化DeepSpeed-Chat 流程的前两步与大型模型的常规微调相似,得益于基于 ZeRO 的内存管理优化和 DeepSpeed 训练中的并行策略灵活组合,实现了规模和速度的提升。然而,流程的第三步在性...

微软开源DeepSpeed Chat,人人可快速训练百亿、千亿级ChatGPT大模型(1)

微软开源DeepSpeed Chat,人人可快速训练百亿、千亿级ChatGPT大模型机器之心 2023-04-13 13:07 发表于北京机器之心专栏微软DeepSpeed组昨日,微软开源的 DeepSpeed Chat 引起了AI社区的广泛关注。它让我们能够以更低的成本、更快的速度训练类...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

ChatGPT开源相关内容

ChatGPT您可能感兴趣

- ChatGPT小技巧

- ChatGPT图片

- ChatGPT计算

- ChatGPT ai

- ChatGPT安全

- ChatGPT sse

- ChatGPT分析

- ChatGPT部署

- ChatGPT sql

- ChatGPT优化

- ChatGPT api

- ChatGPT面试

- ChatGPT测试

- ChatGPT大模型

- ChatGPT软件测试

- ChatGPT python

- ChatGPT架构

- ChatGPT功能

- ChatGPT开发

- ChatGPT abap

- ChatGPT能力

- ChatGPT方法

- ChatGPT数据库

- ChatGPT网络

- ChatGPT数据分析

- ChatGPT编程

- ChatGPT java

- ChatGPT产品