英特尔提出新型卷积 | 让ResNet/MobileNet/ConvNeXt等Backbone一起涨点

动态卷积学习了一个由n个静态卷积核线性混合而成的混合卷积核,通过它们的样本相关注意力进行加权,与普通卷积相比表现出卓越的性能。然而,现有的设计在参数效率方面存在问题:它们将卷积参数的数量增加了n倍。这一问题以及优化的难度导致动态卷积领域没有取得研究进展,无法允许使用较大的n值(例如,n > 1...

即插即用 | 5行代码实现NAM注意力机制让ResNet、MobileNet轻松涨点(超越CBAM)

1简介注意力机制是近年来研究的热点之一。之前的许多研究都关注于通过注意力操作捕捉显著特征。这些方法成功地利用了特征不同维度上的相互信息。然而,它们缺乏对权重的影响因素的考虑,进而进一步抑制不显著的通道或像素。而本文的目标是利用权重的贡献因子来改善注意力机制。使用批归一化的比例因子,它使用标准差来表示...

RMNet推理去除残差结构让ResNet、MobileNet、RepVGG Great Again(必看必看)(二)

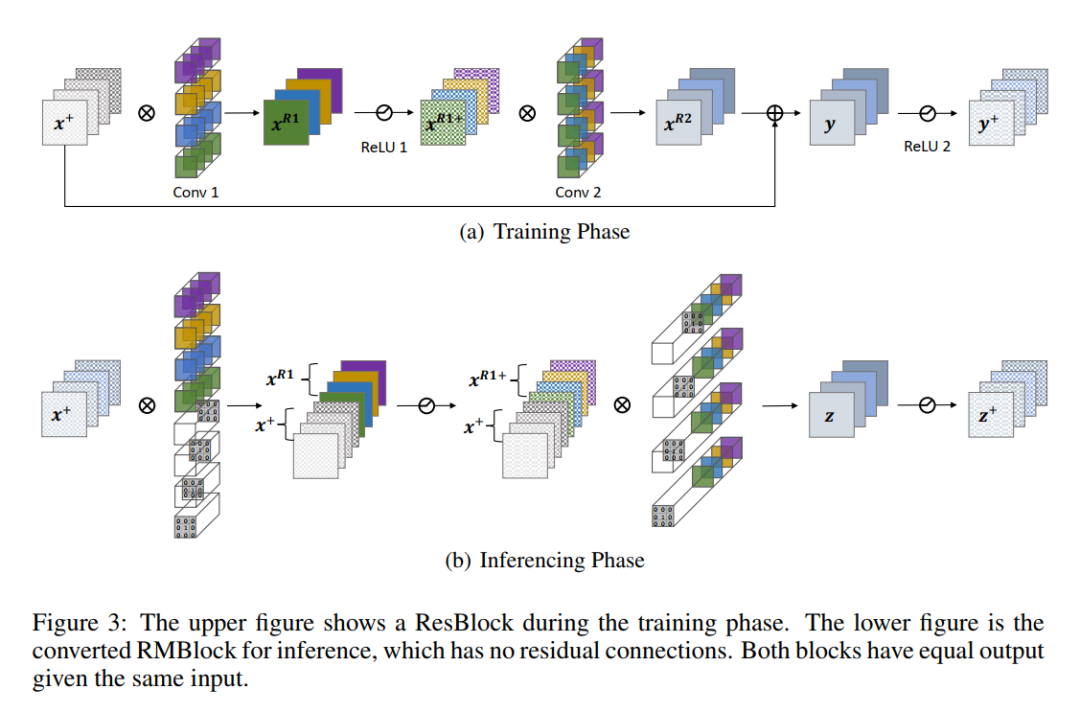

4RM操作和RMNET:迈向高效的Plain Network4.1 RM操作图3显示了RM操作等效去除残差连接的过程。为简单起见,在图中没有显示BN层,输入通道、中间通道和输出通道的数量相同,并赋值为C。1、Reserving首先在Conv 1中插入几个Dirac initialized filte...

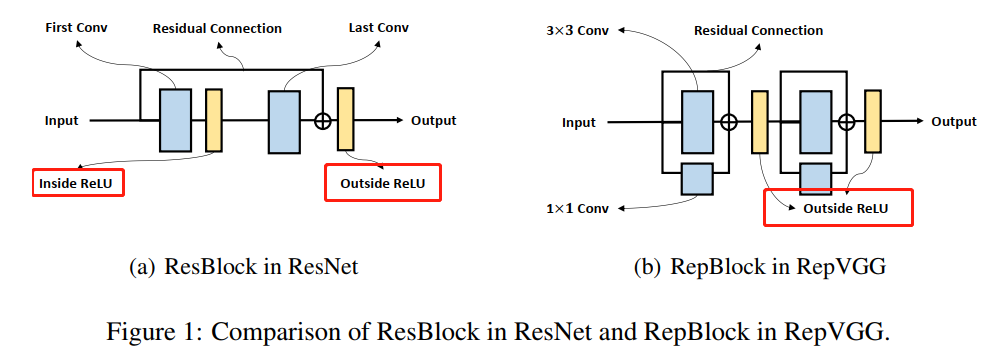

RMNet推理去除残差结构让ResNet、MobileNet、RepVGG Great Again(必看必看)(一)

1简介自从AlexNet问世以来,CNN最先进的架构变得越来越深入。例如,AlexNet只有5层卷积层,很快VGG网络和GoogLeNet分别将其扩展到19层和22层。然而,简单叠加层的深度网络很难训练,因为梯度反向传播到后面比较深的层时梯度可能会消失和爆炸(重复乘法可能会使梯度无穷小或无穷大)。标...

一文读懂物体分类AI算法:LeNet-5 AlexNet VGG Inception ResNet MobileNet

1 引言 当前深度学习十分火热,深度学习网络模型对于降低错误率的重要作用不言而喻。深度学习应用场景主要分为三类:物体识别与分类,物体检测,自然语言处理。在物体识别与分类领域,随着AlexNet在2012年一炮走红,深度学习重新燃起了一片热情。从Lenet5第一次使用卷积开始,经历了AlexNet V...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。