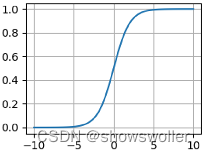

PyTorch基础之激活函数模块中Sigmoid、Tanh、ReLU、LeakyReLU函数讲解(附源码)

需要源码请点赞关注收藏后评论区留言私信~~~激活函数是神经网络中的重要组成部分。在多层神经网络中,上层节点的输出和下层节点的输入之间有一个函数关系。如果这个函数我们设置为非线性函数,深层网络的表达能力将会大幅度提升,几乎可以逼近任何函数,这里,我们把这些非线性函数叫做激活函数。激活函数的作用就是给网...

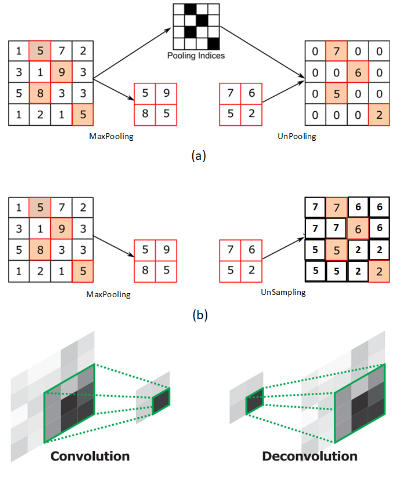

Pytorch学习笔记(5):torch.nn---网络层介绍(卷积层、池化层、线性层、激活函数层)

前期回顾: Pytorch学习笔记(1):基本概念、安装、张量操作、逻辑回归Pytorch学习笔记(2):数据读取机制(DataLoader与Dataset)Pytorch学习笔记(3):图像的预处理(transfo...

PyTorch: 池化-线性-激活函数层

文章和代码已经归档至【Github仓库:https://github.com/timerring/dive-into-AI 】或者公众号【AIShareLab】回复 pytorch教程 也可获取。 nn网络层-池化-线性-激活函数层 池化层 池化的作用则体现在降采样:保留显著特征、降低特征维度,增大...

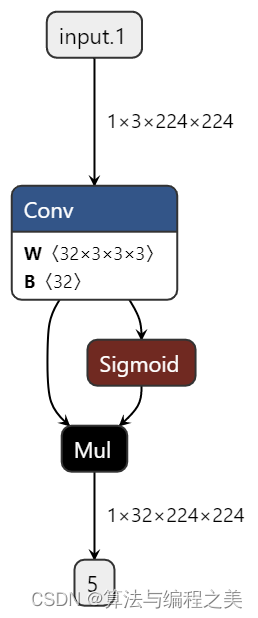

【PyTorch】SiLU激活函数

问题方法SiLU激活函数介绍SiLU激活函数介绍import torch from torch import nn class Net(nn.Module): def __init__(self) -> None: super().__init__() self.conv = nn.Conv2...

【深度学习】2、Pytorch自行实现常见的11个激活函数的Fashion Minist项目实践对比(你需要的这里都有了!)(三)

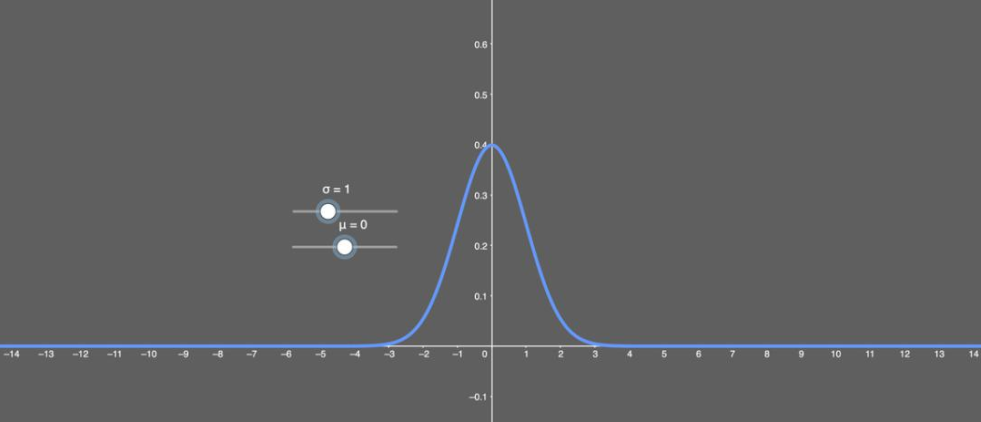

11、SELU的特例 SELU激活能够对神经网络进行自归一化(self-normalizing)。这是什么意思? 首先,我们先看看什么是归一化(normalization)。简单来说,归一化首先是减去均值,然后除以标准差。因此,...

【深度学习】2、Pytorch自行实现常见的11个激活函数的Fashion Minist项目实践对比(你需要的这里都有了!)(二)

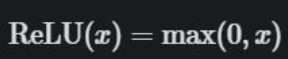

5、整流线性单元(ReLU) 整流线性单元是我们解决梯度消失问题的方法,但这是否会导致其它问题呢?请往下看。ReLU 的公式如下: ReLU 公式表明:如果输入 x 小于 0,则令输出等于 0;如果输入 x 大于 0,则令输出等于输入。&n...

【深度学习】2、Pytorch自行实现常见的11个激活函数的Fashion Minist项目实践对比(你需要的这里都有了!)(一)

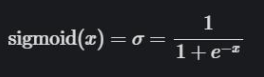

简介神经网络为什么需要激活函数:首先数据的分布绝大多数是非线性的,而一般神经网络的计算是线性的,引入激活函数,是在神经网络中引入非线性,强化网络的学习能力。所以激活函数的最大特点就是非线性。 激活函数对神经网络的重要性自不必多言,来自丹麦技术大学的 Casper Hanse...

【Pytorch神经网络理论篇】 07 激活函数+Sigmoid+tanh+ReLU+Swish+Mish+GELU

同学你好!本文章于2021年末编写,获得广泛的好评!故在2022年末对本系列进行填充与更新,欢迎大家订阅最新的专栏,获取基于Pytorch1.10版本的理论代码(2023版)实现,Pytorch深度学习·理论篇(2023版)目录地址为:CSDN独家 | 全网首发 | Pytorch深度学习·理论篇(...

![Pytorch教程[05]torch.nn---卷积、池化、线性、激活函数层](https://ucc.alicdn.com/pic/developer-ecology/973f57e4d50d4b0985728373f395b24d.png)

Pytorch教程[05]torch.nn---卷积、池化、线性、激活函数层

一、Convolution Layers1.1 nn.Conv2d功能:对多个二维信号进行二维卷积主要参数:• in_channels:输入通道数• out_channels:输出通道数,等价于卷积核个数• kernel_size:卷积核尺寸• stride:步长• padding :...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。