pytorch在GPU上运行模型实现并行计算

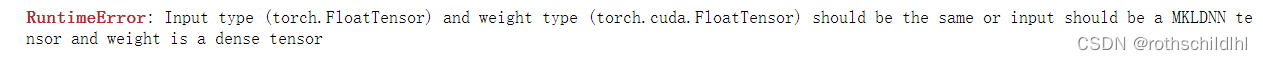

pytorch在GPU上运行模型十分简单,只需要以下两部:model = model.cuda():将模型的所有参数都转存到GPU上input.cuda():将输入数据放置到GPU上至于如何在多块GPU上进行并行计算,PyTorch也提供了两个函数,可以实现简单、高效的GPU并行计算。nn.para...

基于Pytorch使用GPU运行模型方法及可能出现的问题解决方法

基于Pytorch使用GPU运行模型方法及注意事项一、在基于pytorch深度学习进行模型训练和预测的时候,往往数据集比较大,而且模型也可能比较复杂,但如果直接训练调用CPU运行的话,计算运行速度很慢,因此使用GPU进行模型训练和预测是非常有必要的,可以大大提高实验效率。如果还没有配置好运行环境的博...

这是什么情况?GPU实例在运行中,不能接受请求了?

这是什么情况? GPU实例在运行中,不能接受请求了?

指定GPU运行和训练python程序 、深度学习单卡、多卡 训练GPU设置【一文读懂】

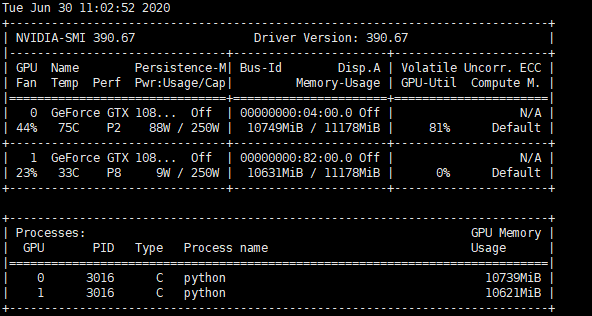

版权: 本文由【墨理学AI】原创、各位大佬、欢迎和墨理一起学AI # 深度学习模型训练基础环境搭建相关教程————❤️ 不负光阴不负卿 ❤️ 查看服务器显卡使用情况一、命令行运行python程序时首先查看哪些GPU空闲,nvidia-smi显示当前GPU使用情况nvidia-smi如下图所示:服务器...

在Docker Compose上使用GPU运行TensorFlow

容器化和AI是目前开发的大趋势。理想情况下,容器化可以将环境无缝迁移,将配置环境的成本无限降低:但是在容器中配置CUDA并运行TensorFlow一向是个难题。对于初学者以及没有深度学习工作站的用户,AWS和Azure推出了带独立显卡的云服务:但是按需实例价格不便宜,竞价式实例价格公道然而虚拟机不能...

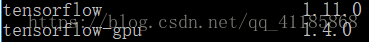

成功解决:Win系统下的Tensorflow使用CPU而不使用GPU运行加速

解决问题解决思路版本不一致导致!解决方法

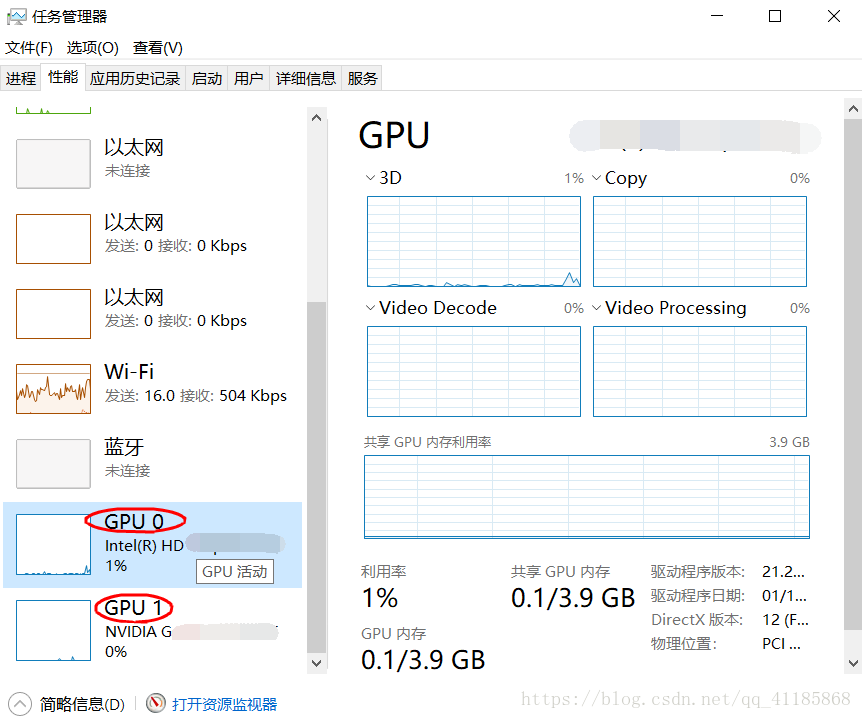

TF之Windows:Windows系统下设置Tensorflow运行方式为GPU加速运行的详细攻略

软件环境1、第一步安装好CUDA软件程序推荐文章:Py之TF/Cuda/Cudnn:Win10下安装深度学习框架Tensorflow+Cuda+Cudnn最简单最快捷最详细攻略Ubuntu:Ubuntu下安装Anocuda和Tensorflow最详细攻略2、第二步安装好tensorflow-gpu库...

使用DSW时跑深度学习代码时,在右侧栏显示使用CPU在跑。请问如何使自己的代码在GPU上运行。

使用DSW时跑深度学习代码时,在右侧栏显示使用CPU在跑。请问如何使自己的代码在GPU上运行。

GPU服务器可以运行安卓模拟器吗

类似带显卡的服务器效果,可以运行安卓模拟器

在浏览器中运行Keras模型,并支持GPU

Keras.js 推荐一下网页上的 demo https://transcranial.github.io/keras-js/#/ 加载的比较慢,但是识别的非常快。 Run Keras models (trained using Tensorflow backend) in your browser...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。