[帮助文档] 在DataWorks中使用Spark Distribution SQL Engine开发Spark SQL作业

若您需要在DataWorks中开发Spark SQL作业,可以通过注册CDH集群的方式,将AnalyticDB for MySQL的Spark Distribution SQL Engine服务注册为一种支持SQL的执行引擎,从而满足您在DataWorks中使用Spark Distribution ...

DataWorks产品使用合集之在DataWorks中,通过spark访问外网的步骤如何解决

问题一:DataWorks如何通过spark访问外网呢? DataWorks如何通过spark访问外网呢? 参考回答: 在DataWorks中创建一个支持外网访问的虚拟私有云(VPC),并将Spark作业所在的节点加入到该VPC中。这样,作业就可以通过VPC访问外部网络。 关于本问题的更多回答可点击...

DataWorks中spark任务是有办法跨空间取表数据吗?

DataWorks中spark任务是有办法跨空间取表数据吗?

Dataworks运行scala-spark程序一直不动?

Dataworks运行scala-spark程序一直不动?

DataWorks中ODDS Spark链接EMR Starrocks报链接超时该如何处理?

DataWorks中ODDS Spark链接EMR Starrocks报链接超时该如何处理?

DataWorks中ODPS Spark找不到自己的stdout,如何解决?

DataWorks中ODPS Spark找不到自己的stdout?

DataWorks大致就这么多,我在官方文档上看是有ODPS Spark,但是实际看来是并没有的?

DataWorks大致就这么多,我在官方文档上看是有ODPS Spark,但是实际看来是并没有的?

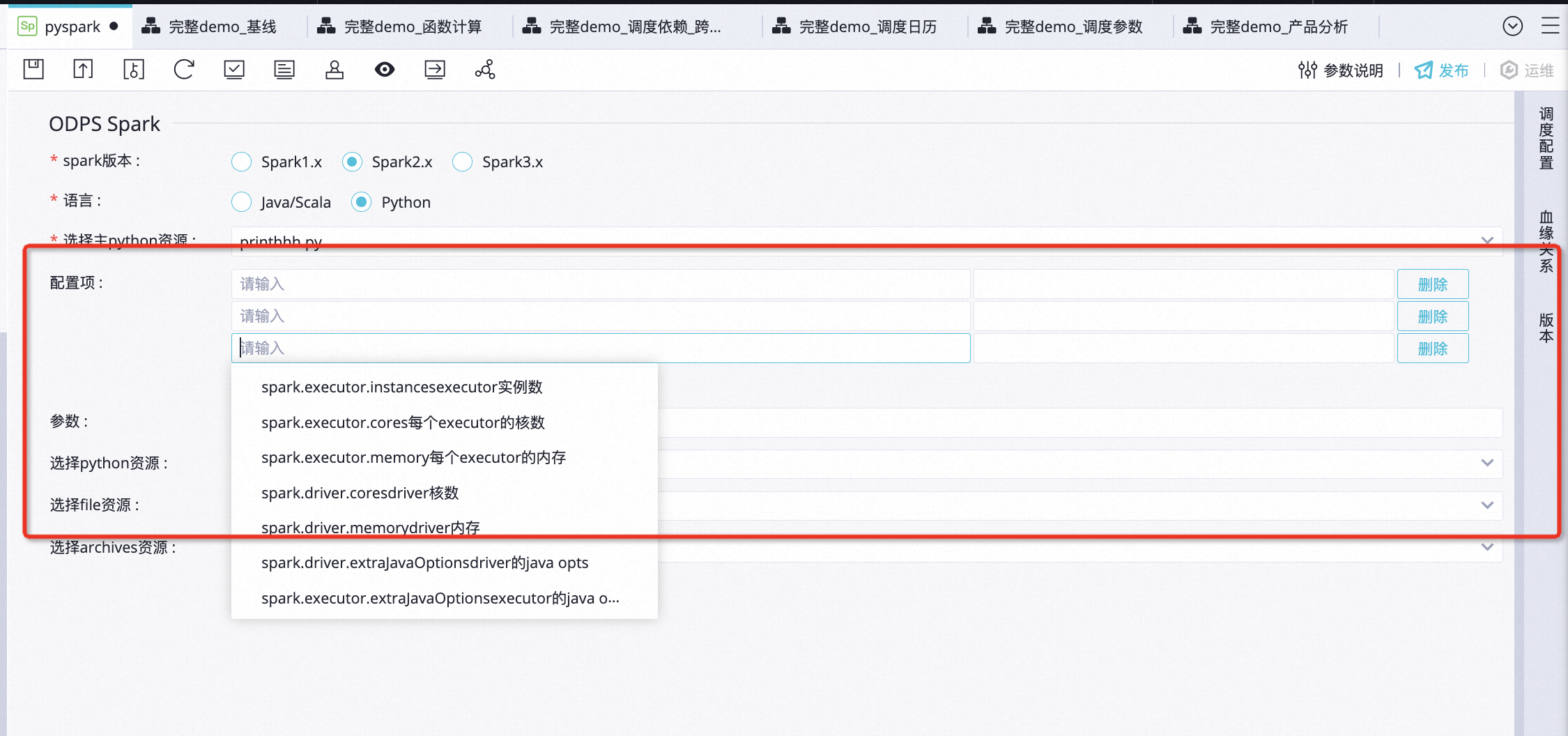

DataWorks下面的Datastudio模块没有ODPS Spark了吗,是已经移除了吗?

DataWorks下面的Datastudio模块没有ODPS Spark了吗,是已经移除了吗?

[帮助文档] 如何创建CDH Spark节点

Spark是一个通用的大数据分析引擎,具有高性能、易用和普遍性等特点,可用于进行复杂的内存分析,构建大型、低延迟的数据分析应用。DataWorks为您提供CDH Spark节点,便于您在DataWorks上进行Spark任务的开发和周期性调度。本文为您介绍如何创建及使用CDH Spark节点。

在dataworks的数据开发下面的spark节点,为什么查询ots的时候,发现没有数据?

在dataworks的数据开发下面的spark节点,使用spark读取maxcompute数据,并且写入tablestore。我是对于tablestore建立了maxcompute外表,spark写入ots程序没有报错,但是为什么查询ots的时候,发现没有数据?

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

大数据开发治理平台 DataWorks更多spark相关

大数据开发治理平台 DataWorks您可能感兴趣

- 大数据开发治理平台 DataWorks parquet

- 大数据开发治理平台 DataWorks数据导出

- 大数据开发治理平台 DataWorks数据集

- 大数据开发治理平台 DataWorks oss

- 大数据开发治理平台 DataWorks文件

- 大数据开发治理平台 DataWorks maxcompute

- 大数据开发治理平台 DataWorks datahub

- 大数据开发治理平台 DataWorks优先级

- 大数据开发治理平台 DataWorks python

- 大数据开发治理平台 DataWorks连通性

- 大数据开发治理平台 DataWorks数据

- 大数据开发治理平台 DataWorks任务

- 大数据开发治理平台 DataWorks同步

- 大数据开发治理平台 DataWorks节点

- 大数据开发治理平台 DataWorks配置

- 大数据开发治理平台 DataWorks报错

- 大数据开发治理平台 DataWorks集成

- 大数据开发治理平台 DataWorks表

- 大数据开发治理平台 DataWorks数据源

- 大数据开发治理平台 DataWorks数据集成

- 大数据开发治理平台 DataWorks资源

- 大数据开发治理平台 DataWorks调度

- 大数据开发治理平台 DataWorks odps

- 大数据开发治理平台 DataWorks sql

- 大数据开发治理平台 DataWorks运行

- 大数据开发治理平台 DataWorks资源组

- 大数据开发治理平台 DataWorks参数

- 大数据开发治理平台 DataWorks设置

- 大数据开发治理平台 DataWorks mysql