【Flume】Flume 监听日志文件案例分析

Flume监听日志文件案例分析 在实际应用中,经常需要实时地监控和收集日志文件中的数据,以进行进一步的处理和分析。Flume提供了一个名为Spooling Directory Source的组件,可以用于监听指定目录下的日志文件,并将其中的数据实时传输到指定的目的地。下面我们将通过一个案例来演示如何...

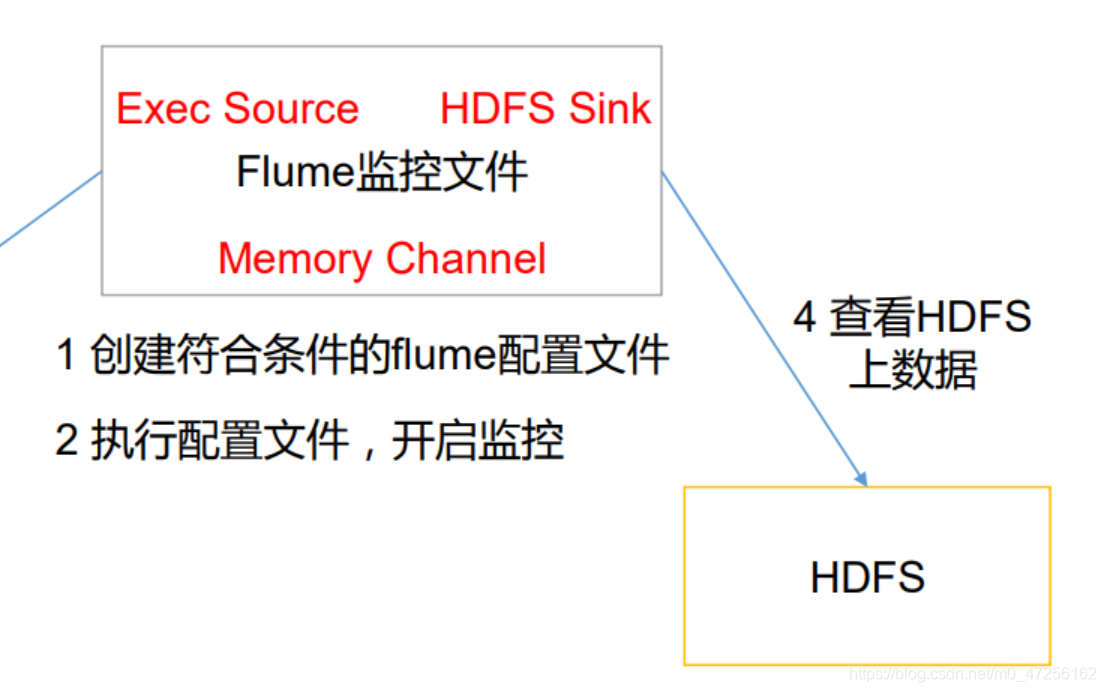

【Flume中间件】(3)实时监听文件到HDFS系统

实时监听文件到HDFS系统之前测试了监听一个文件的新内容,然后打印到了控制台,现在我们需要将监控到的内容放到HDFS中进行存储,其实和控制台一样,只不过是将sink源改到HDFS,修改一下相关的配置。a1.sources = r1 a1.sinks = k1 a1.channels = c1 a1....

【Flume中间件】(2)实时监听一个文件末尾产生的数据

实时监听一个文件末尾产生的数据有时我们会产生需求实时的监控一个文件的数据,一般来说是日志这种信息,这种情况我们可以使用Flume进行解决,我们需要将source端改为exec,它是按照给定指令进行监控,一般监控文件末尾数据就是tail -F /home/file,这里的-F有一定的讲究就是,如果我们...

设置Flume监听文件内容

应用场景 按照Hadoop完全分布式安装Flume博文,测试使用了Flume监听文件夹,当文件夹中添加了文件,Flume设置会立马进行收集文件夹中的添加的文件,那么这是一种应用场景,但是如果我们想收集文件中的内容,该如何办呢?比如,linux目录下有一个文件,我会往这个文件里不断的新增内容,那么怎么...

Flume监听文件夹中的文件变化,并把文件下沉到hdfs

1、采集目录到HDFS 采集需求:某服务器的某特定目录下,会不断产生新的文件,每当有新文件出现,就需要把文件采集到HDFS中去 根据需求,首先定义以下3大要素 采集源,即source——监控文件目录 : spooldir 下沉目标,即sink——HDFS文件系统 : hdfs sink source...

模拟使用Flume监听日志变化,并且把增量的日志文件写入到hdfs中

1.采集日志文件时一个很常见的现象 采集需求:比如业务系统使用log4j生成日志,日志内容不断增加,需要把追加到日志文件中的数据实时采集到hdfs中。 1.1.根据需求,首先定义一下3大要素: 采集源,即source—监控日志文件内容更新:exec ‘tail -F file’ 下沉目标,即sink...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。