[帮助文档] 如何使用新版FlinkConnector将数据写入MaxCompute,有哪些参数

当前MaxCompute为您提供了新版的Flink Connector插件,新版插件支持将Flink数据写入至MaxCompute的普通表和Transaction Table2.0类型表,提高了Flink数据写入MaxCompute的便捷性。本文为您介绍新版Flink Connector写入MaxC...

[帮助文档] Flink Connector 相关配置

Flink Connector 使用

flink kafka connector源码解读(超详细)

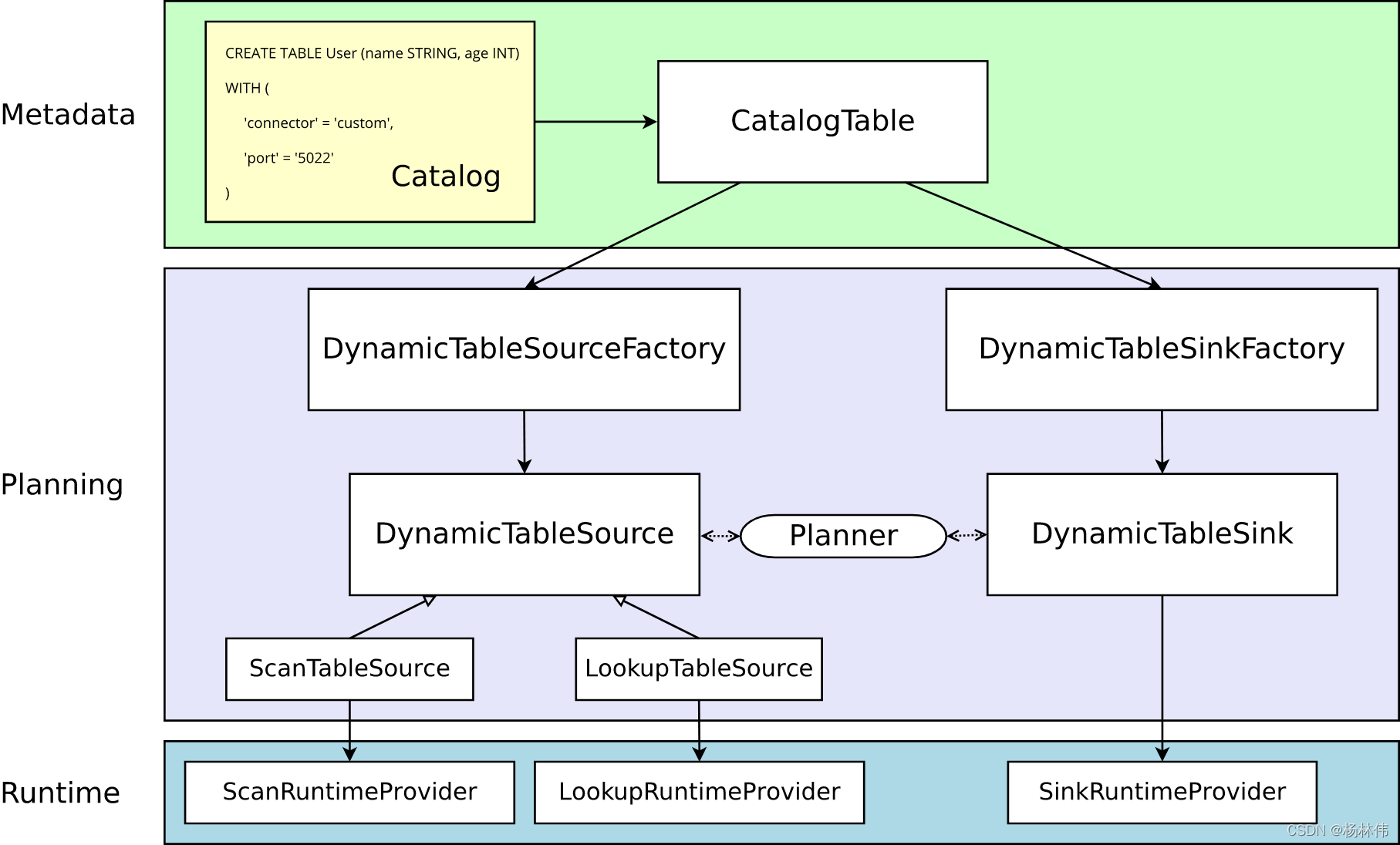

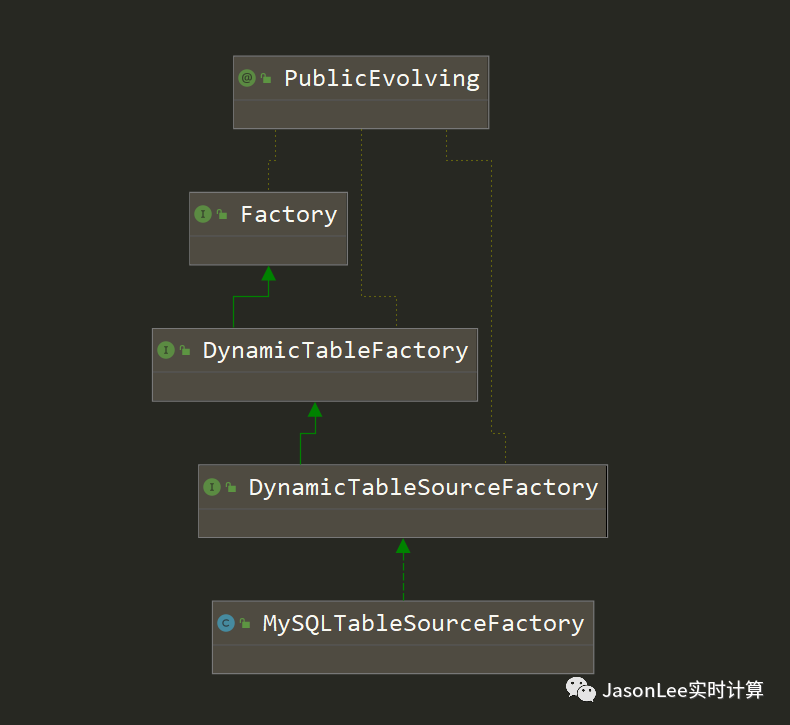

01 引言在上一节《Flink自定义Connector》,我们知道了Flink自定义Connector的基本流程,其流程图如下:进入代码层面,开发者自定义connector的流程如下:首先定义Flink SQL的DDL;创建解析和验证选项的工厂(DynamicTableSourceFactory、D...

谁知道flink jdbc connector 1.14的源码在哪里吗?

谁知道flink jdbc connector 1.14的源码在哪里吗?

[帮助文档] 如何使用FlinkConnector,内部实现原理是什么

Flink Connector内部实现是通过缓存并批量由Stream Load导入。本文为您介绍Flink Connector的使用方式及示例。

[帮助文档] FlinkConnector的使用方式及示例

Flink Connector内部实现是通过缓存并批量由Stream Load导入。本文为您介绍Flink Connector的使用方式及示例。

怎么找 flink es connector 1.13.6版本的 源码呢?

怎么找 flink es connector 1.13.6版本的 源码呢?

Flink mysql-cdc connector 源码解析

在 Flink 1.11 引入了 CDC 机制,CDC 的全称是 Change Data Capture,用于捕捉数据库表的增删改查操作,是目前非常成熟的同步数据库变更方案。Flink CDC Connectors 是 Apache Flink 的一组源连接器,是可以从 MySQL、PostgreS...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

实时计算 Flink版connector相关内容

- 实时计算 Flink版sqlserver connector

- 实时计算 Flink版自定义connector

- 实时计算 Flink版mysql connector

- 实时计算 Flink版hudi connector

- 实时计算 Flink版官网connector

- 实时计算 Flink版connector jdbc

- 实时计算 Flink版connector仓库

- 实时计算 Flink版connector依赖

- connector实时计算 Flink版

- 实时计算 Flink版jdbc connector

- 实时计算 Flink版依赖connector

- 实时计算 Flink版kafka connector

- 实时计算 Flink版集成connector

- 实时计算 Flink版pipeline connector

- 实时计算 Flink版opengauss connector

- 实时计算 Flink版es connector

- 实时计算 Flink版sql connector

- 实时计算 Flink版mongo connector

- 实时计算 Flink版jdbc connector一致性

- 实时计算 Flink版pulsar connector

- 实时计算 Flink版connector开发

- 实时计算 Flink版connector自定义

- datahub实时计算 Flink版connector

- 实时计算 Flink版connector clickhouse

- 实时计算 Flink版connector存储

- 实时计算 Flink版connector文档

- 实时计算 Flink版connector怎么配置

- 实时计算 Flink版connector办法

- 实时计算 Flink版jdbc connector连接池模型

- 实时计算 Flink版connector format

- 实时计算 Flink版datastream connector

- 实时计算 Flink版connector解析

- 实时计算 Flink版doris connector入库

- 实时计算 Flink版cdc jdbc connector同步方案

- 实时计算 Flink版connector功能

- pravega实时计算 Flink版connector

- jindofs实时计算 Flink版connector

- 实时计算 Flink版connector如何配置

- 实时计算 Flink版connector

- 实时计算 Flink版connector机制

实时计算 Flink版您可能感兴趣

- 实时计算 Flink版json

- 实时计算 Flink版oracle

- 实时计算 Flink版数组

- 实时计算 Flink版临时文件

- 实时计算 Flink版配置参数

- 实时计算 Flink版堆内存

- 实时计算 Flink版捕获

- 实时计算 Flink版办法

- 实时计算 Flink版表

- 实时计算 Flink版pg

- 实时计算 Flink版CDC

- 实时计算 Flink版数据

- 实时计算 Flink版SQL

- 实时计算 Flink版mysql

- 实时计算 Flink版同步

- 实时计算 Flink版报错

- 实时计算 Flink版任务

- 实时计算 Flink版版本

- 实时计算 Flink版kafka

- 实时计算 Flink版Apache

- 实时计算 Flink版配置

- 实时计算 Flink版设置

- 实时计算 Flink版 CDC

- 实时计算 Flink版模式

- 实时计算 Flink版运行

- 实时计算 Flink版数据库

- 实时计算 Flink版Yarn

- 实时计算 Flink版checkpoint