[帮助文档] 如何使用新版FlinkConnector将数据写入MaxCompute,有哪些参数

当前MaxCompute为您提供了新版的Flink Connector插件,新版插件支持将Flink数据写入至MaxCompute的普通表和Transaction Table2.0类型表,提高了Flink数据写入MaxCompute的便捷性。本文为您介绍新版Flink Connector写入MaxC...

[帮助文档] Flink Connector 相关配置

Flink Connector 使用

Flink 提供了与 Kafka 集成的官方 Connector,使得 Flink 能够消费 Kafka 数据

Apache Flink 是一个开源的分布式流处理框架,自 1.11 版本起,Flink 提供了与 Kafka 集成的官方 Connector,使得 Flink 能够消费 Kafka 数据。在 Flink 1.14.4 版本中,确实支持将 Kafka 偏移量保存在外部系统,如Kafka本身,并且可以...

Flink使用 kafka connector 报错 Caused by:有人知道为什么吗?

Flink使用 kafka connector 报错 Caused by: java.lang.ClassNotFoundException: org.apache.flink.connector.kafka.source.KafkaSource 有人知道为什么吗?

flink kafka connector源码解读(超详细)

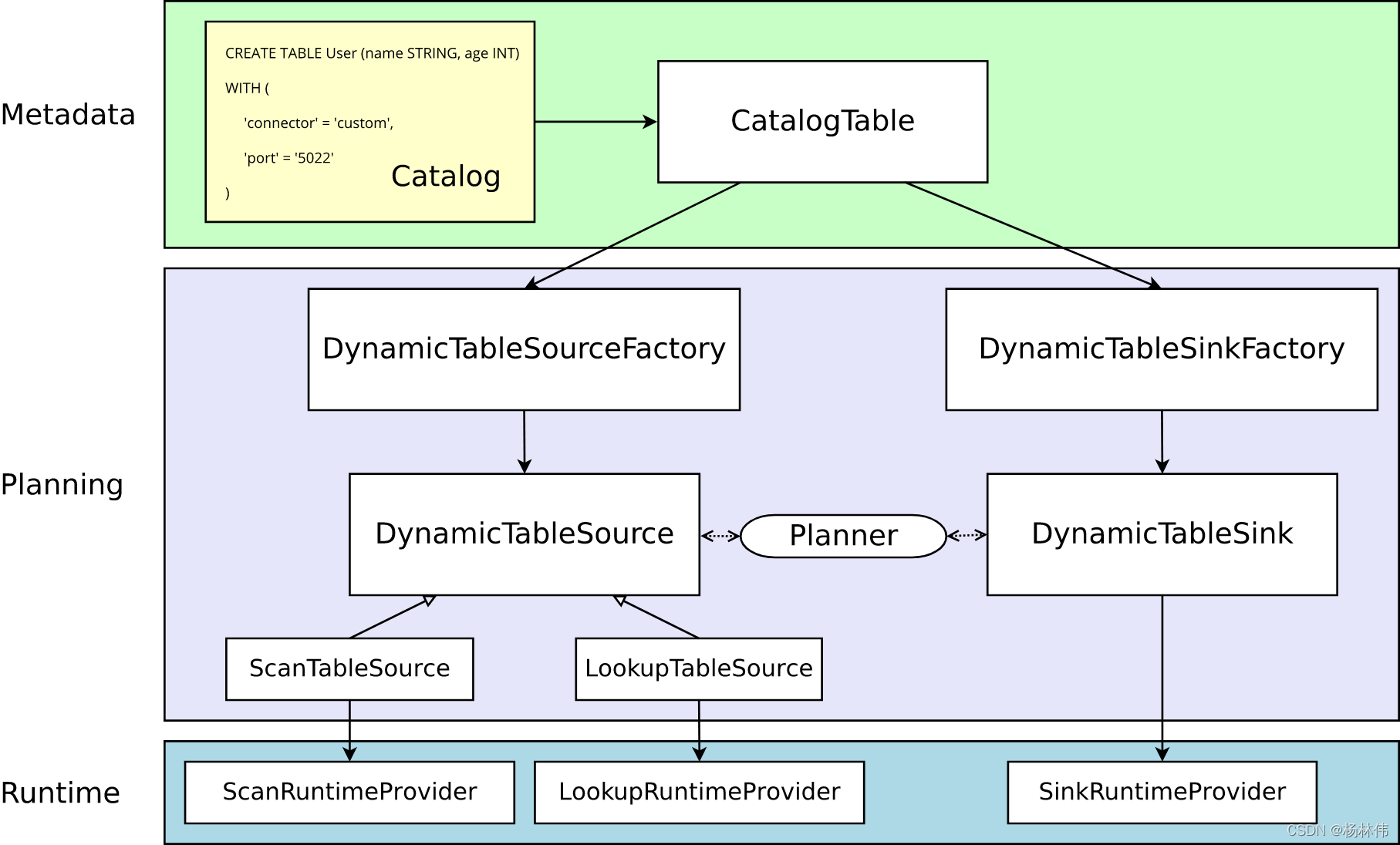

01 引言在上一节《Flink自定义Connector》,我们知道了Flink自定义Connector的基本流程,其流程图如下:进入代码层面,开发者自定义connector的流程如下:首先定义Flink SQL的DDL;创建解析和验证选项的工厂(DynamicTableSourceFactory、D...

[帮助文档] 如何使用FlinkConnector,内部实现原理是什么

Flink Connector内部实现是通过缓存并批量由Stream Load导入。本文为您介绍Flink Connector的使用方式及示例。

[帮助文档] FlinkConnector的使用方式及示例

Flink Connector内部实现是通过缓存并批量由Stream Load导入。本文为您介绍Flink Connector的使用方式及示例。

Flink 1.14.0 全新的 Kafka Connector

Apache Kafka Connector#Flink 提供了一个 Apache Kafka 连接器,用于从 Kafka Topic 读取数据和向 Kafka Topic 写入数据,并保证恰好一次次语义。Dependency#Apache Flink 附带了一个通用的 Kafka 连接器,它试图跟...

请问一下老师们,flink SQL kafka connector中的startup mode 选择

请问一下老师们,flink SQL kafka connector中的startup mode 选择【timestamp】模式没有按照预期从指定时间戳开始取数可能是什么问题?

Flink SQL kafka connector有办法获取到partition、offset信息嘛

如题,需要获取到kafka的partition、offset进行处理 *来自志愿者整理的flink邮件归档

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

实时计算 Flink版connector相关内容

- 实时计算 Flink版自定义connector

- 实时计算 Flink版mysql connector

- 实时计算 Flink版hudi connector

- 实时计算 Flink版官网connector

- 实时计算 Flink版connector jdbc

- 实时计算 Flink版connector仓库

- 实时计算 Flink版connector依赖

- connector实时计算 Flink版

- 实时计算 Flink版jdbc connector

- 实时计算 Flink版依赖connector

- 实时计算 Flink版集成connector

- 实时计算 Flink版pipeline connector

- 实时计算 Flink版opengauss connector

- 实时计算 Flink版sql connector

- 实时计算 Flink版mongo connector

- 实时计算 Flink版jdbc connector一致性

- 实时计算 Flink版pulsar connector

- 实时计算 Flink版connector开发

- 实时计算 Flink版connector源码

- 实时计算 Flink版connector自定义

- 实时计算 Flink版connector clickhouse

- 实时计算 Flink版connector存储

- 实时计算 Flink版connector文档

- 实时计算 Flink版connector怎么配置

- 实时计算 Flink版connector办法

- 实时计算 Flink版jdbc connector连接池模型

- 实时计算 Flink版connector format

- 实时计算 Flink版datastream connector

- 实时计算 Flink版connector解析

- 实时计算 Flink版doris connector入库

- 实时计算 Flink版cdc jdbc connector同步方案

- pravega实时计算 Flink版connector

- jindofs实时计算 Flink版connector

- 实时计算 Flink版connector如何配置

- 实时计算 Flink版connector

- 实时计算 Flink版connector机制

实时计算 Flink版您可能感兴趣

- 实时计算 Flink版高斯

- 实时计算 Flink版db

- 实时计算 Flink版版本

- 实时计算 Flink版中文乱码

- 实时计算 Flink版cdc3.1

- 实时计算 Flink版新功能

- 实时计算 Flink版连接

- 实时计算 Flink版格式

- 实时计算 Flink版生产

- 实时计算 Flink版报错

- 实时计算 Flink版数据

- 实时计算 Flink版同步

- 实时计算 Flink版任务

- 实时计算 Flink版oracle

- 实时计算 Flink版表

- 实时计算 Flink版配置

- 实时计算 Flink版设置

- 实时计算 Flink版 CDC

- 实时计算 Flink版模式

- 实时计算 Flink版运行

- 实时计算 Flink版数据库

- 实时计算 Flink版库

- 实时计算 Flink版作业

- 实时计算 Flink版全量

- 实时计算 Flink版参数

- 实时计算 Flink版日志

- 实时计算 Flink版集群