PyTorch基础之优化器模块、训练和测试模块讲解(附源码)

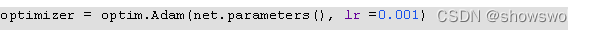

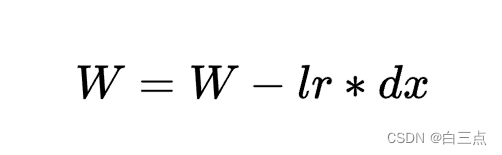

一、优化器模块torch.optim是一个具备各种优化算法的库,可以支持大部分常用的优化方法,并且这个接口具备足够的通用性,这使得它能够集成更加复杂的优化算法1:optimizer的使用构建一个optimizer对象参数设置(需要优化的参数、设置学习率等)另外,还可以单独设置每个参数值表示model...

Pytorch基本使用——优化器

🎏目录🎈1 SGD🎄1.1 原理🎄1.2 构造🎄1.3 参数详解——momentum🎈2 Adam及AdamW🎄2.1 更新规则🎄2.2 理解一阶估计变量m和二阶估计变量v及探讨Adam如何利用的它们🎄2.3 AdamW✨1 SGD损失函数是用来度量模型...

算法工程师的修养 | pytorch 优化器与学习率

学习率设置对于学习过程来说相当重要。学习率过低会导致学习速度太慢,学习率过高又容易导致难以收敛。在很多学习过程中,都会采用动态调整学习率的方法。刚开始训练的时候,学习率设置大一点,以加快学习速度;之后逐渐减小学习率,来寻找最优解。那么在Pytorch中,如在训练过程中动态地调整学习率呢?目录优化器O...

pytorch优化器与学习率设置详解

身为一名深度学习炼丹师,我们知道学习率对于模型训练效果来说相当重要。然鹅,学习率过低会导致学习速度太慢,学习率过高又容易导致难以收敛。因此,很多炼丹师都会采用动态调整学习率的方法。刚开始训练时,学习率大一点,以加快学习速度;之后逐渐减小来寻找最优解。那么在Pytorch中,如何在训练过...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。