实时计算 Flink版产品使用合集之可以支持 MySQL 数据源的增量同步到 Hudi 吗

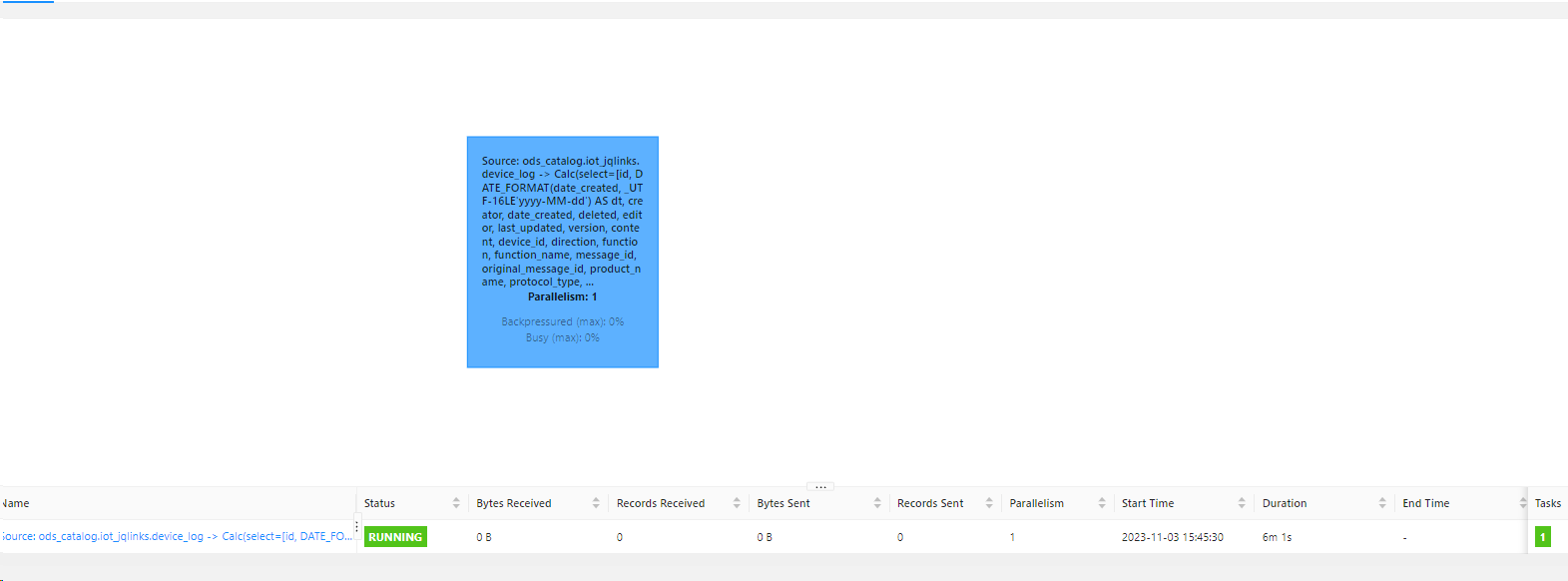

问题一:flink并行度为1,接收发送字节都为0,有什么办法显示接收和发送字节数? flink并行度为1,接收发送字节都为0,有什么办法显示接收和发送字节数? 参考回答: 把你的算子链断开 ...

DataWorks产品使用合集之在DataWorks中,要实现MySQL数据源的增量同步如何解决

问题一:DataWorks如何导入客户端数据? DataWorks如何导入客户端数据? 参考回答: 在DataWorks中导入客户端数据,需要经过以下步骤: 选择要导入的数据源类型,并填写相应的连接信息和认证信息。单击“创建”按钮,完成数据源的创建。 在DataWorks工作空间中新建一个数据表,然...

[帮助文档] 将AnalyticDB for MySQL3.0实例创建为DataWorks的AnalyticDB for MySQL3.0数据源

若您要使用DataWorks进行AnalyticDB for MySQL3.0任务的开发、管理,需先将您的AnalyticDB for MySQL3.0实例创建为DataWorks的AnalyticDB for MySQL3.0数据源。创建完成后,可在DataWorks的各功能模块使用该数据源连接A...

[帮助文档] Dataphin如何创建AnalyticDBforMySQL3.0数据源

通过创建AnalyticDB for MySQL 3.0数据源能够实现Dataphin读取AnalyticDB for MySQL 3.0的业务数据或向AnalyticDB for MySQL 3.0写入数据。本文为您介绍如何创建AnalyticDB for MySQL 3.0数据源。

[帮助文档] 如何创建MySQL数据源

通过创建MySQL数据源能够实现Dataphin读取MySQL的业务数据或向MySQL写入数据。本文为您介绍如何创建MySQL数据源。

用 mysql cdc 以 polardb 作数据源,在增量同步的时候每隔一段时间就断开。怎么回事?

有个一 flink 作业,用 mysql cdc 以 polardb 作数据源,在增量同步的时候每隔一段时间就断开。怎么回事?其他作业没有问题PS:有问题的作业数据量较其他作业数据量稍大,但是有整库同步都没有问题,这个只有一张表

[帮助文档] Spark读写OSS-HDFS数据源

AnalyticDB for MySQL湖仓版(3.0)Spark支持访问OSS-HDFS数据源,本文介绍如何使用Spark来操作OSS-HDFS数据。

[帮助文档] 通过Spark SQL访问JDBC MySQL数据源

AnalyticDB MySQL湖仓版(3.0)支持提交Spark SQL作业,您可以通过View或Catalog两种方式访问自建MySQL数据库或云数据库RDS MySQL、云原生数据库 PolarDB MySQL。本文以RDS MySQL为例,介绍如何通过Spark SQL访问RDS MySQL...

DataWorks中Mysql 数据源 增量同步如何操作?

DataWorks中Mysql 数据源 增量同步如何操作?

Flink中MySQL作为数据源,能支持增量同步到Hudi?

Flink中MySQL作为数据源,能支持增量同步到Hudi?

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

云数据库 RDS MySQL 版数据源相关内容

- 产品云数据库 RDS MySQL 版数据源

- 产品云数据库 RDS MySQL 版数据源增量同步

- maxcompute数据源云数据库 RDS MySQL 版

- 云数据库 RDS MySQL 版数据源maxcompute

- dms云数据库 RDS MySQL 版数据源

- 云数据库 RDS MySQL 版数据源集成

- 云数据库 RDS MySQL 版数据源独享数据集成

- 编辑云数据库 RDS MySQL 版数据源

- 数据源云数据库 RDS MySQL 版目标

- 云数据库 RDS MySQL 版数据源ssl

- 数据集成云数据库 RDS MySQL 版数据源

- 集成云数据库 RDS MySQL 版数据源

- 数据集成数据源云数据库 RDS MySQL 版

- 云数据库 RDS MySQL 版数据源公共资源组

- 云数据库 RDS MySQL 版ip数据源

- datav数据源云数据库 RDS MySQL 版

- sphinx云数据库 RDS MySQL 版数据源

云数据库 RDS MySQL 版您可能感兴趣

- 云数据库 RDS MySQL 版新建

- 云数据库 RDS MySQL 版dataworks

- 云数据库 RDS MySQL 版hive

- 云数据库 RDS MySQL 版数据同步

- 云数据库 RDS MySQL 版阿里云

- 云数据库 RDS MySQL 版连接

- 云数据库 RDS MySQL 版系统源码

- 云数据库 RDS MySQL 版java

- 云数据库 RDS MySQL 版生产

- 云数据库 RDS MySQL 版数据库

- 云数据库 RDS MySQL 版数据

- 云数据库 RDS MySQL 版安装

- 云数据库 RDS MySQL 版sql

- 云数据库 RDS MySQL 版查询

- 云数据库 RDS MySQL 版mysql

- 云数据库 RDS MySQL 版同步

- 云数据库 RDS MySQL 版配置

- 云数据库 RDS MySQL 版报错

- 云数据库 RDS MySQL 版索引

- 云数据库 RDS MySQL 版rds

- 云数据库 RDS MySQL 版flink

- 云数据库 RDS MySQL 版表

- 云数据库 RDS MySQL 版优化

- 云数据库 RDS MySQL 版cdc

- 云数据库 RDS MySQL 版linux

- 云数据库 RDS MySQL 版操作

- 云数据库 RDS MySQL 版实例

- 云数据库 RDS MySQL 版备份