[帮助文档] 如何创建SSH数据源

在DataWorks中,您可通过创建SSH数据源并配置主机访问信息的方式远程访问主机,随后,SSH节点可通过该数据源远程访问主机并触发主机脚本执行。例如,您可通过此方式实现在DataWorks远程访问ECS(Elastic Compute Service)并触发ECS中的脚本周期性调度执行。本文为您...

[帮助文档] 使用DataWorks周期性执行SSH任务

DataWorks的SSH节点可通过指定SSH数据源的方式,在DataWorks远程访问该数据源连接的主机,并触发脚本在远程主机执行。例如,您可通过此方式实现在DataWorks远程访问ECS(Elastic Compute Service)并触发ECS中的脚本周期性调度执行。本文为您介绍使用SSH...

[帮助文档] 使用DataWorks周期性执行MariaDB任务

DataWorks的MariaDB节点可进行MariaDB任务的开发和周期性调度,以及与其他作业的集成操作。本文为您介绍使用MariaDB节点进行任务开发的主要流程。

[帮助文档] 使用DataWorks周期性执行GBase 8a任务

DataWorks的GBase 8a节点可进行GBase 8a任务的开发和周期性调度,以及与其他作业的集成操作。本文为您介绍使用GBase 8a节点进行任务开发的主要流程。

[帮助文档] 使用DataWorks周期性执行DB2任务

DataWorks的DB2节点可进行DB2任务的开发和周期性调度,以及与其他作业的集成操作。本文为您介绍使用DB2节点进行任务开发的主要流程。

DataWorks数据开发与运行如何将本地数据上传到maxcompute表中?

DataWorks数据开发与运行如何将本地数据上传到maxcompute表中?

通过DataWorks等数据开发工具将数据增量插入(INSERT INTO)MaxCompute表(

通过DataWorks等数据开发工具将数据增量插入(INSERT INTO)MaxCompute表(或表分区)时,每次进行数据增量插入都会产生1个文件。若每次插入10条,则每天累计插入10000条记录,即会产生1000个小文件。我如何查看这些小文件的占用呢

DataWorks_数据开发_EMR Spark节点_计算Pi和对接MaxCompute案例

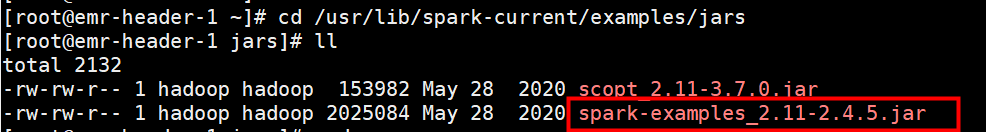

示例一:spark自带示例项目SparkPi:计算Pi本文以Spark自带示例项目计算Pi为例测试当前EMR Spark环境是否可用,示例详情请参见EMR示例项目使用说明。准备工作:获取spark自带example的jar包spark-examples_2.11-2.4.5.jar存放路径,spar...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

云原生大数据计算服务 MaxComputedataworks相关内容

- dataworks云原生大数据计算服务 MaxCompute数据开发

- dataworks云原生大数据计算服务 MaxCompute建表

- dataworks云原生大数据计算服务 MaxCompute控制台

- dataworks云原生大数据计算服务 MaxCompute函数odps

- dataworks云原生大数据计算服务 MaxCompute least函数

- dataworks产品云原生大数据计算服务 MaxCompute如何解决

- dataworks产品云原生大数据计算服务 MaxCompute自定义资源如何解决

- dataworks产品云原生大数据计算服务 MaxCompute资源

- dataworks数据集成实时同步云原生大数据计算服务 MaxCompute

- dataworks云原生大数据计算服务 MaxCompute如何解决

- dataworks云原生大数据计算服务 MaxCompute资源信息

- dataworks产品云原生大数据计算服务 MaxCompute

- dataworks云原生大数据计算服务 MaxCompute信息

- dataworks云原生大数据计算服务 MaxCompute步骤

- dataworks云原生大数据计算服务 MaxCompute自定义函数jar

- dataworks云原生大数据计算服务 MaxCompute jar

- dataworks es云原生大数据计算服务 MaxCompute

- dataworks函数云原生大数据计算服务 MaxCompute

- dataworks字段云原生大数据计算服务 MaxCompute

- dataworks odps云原生大数据计算服务 MaxCompute

- 云原生大数据计算服务 MaxCompute dataworks绑定

- 云原生大数据计算服务 MaxCompute产品dataworks

- 云原生大数据计算服务 MaxCompute dataworks数据源

- 云原生大数据计算服务 MaxCompute dataworks配置

- 云原生大数据计算服务 MaxCompute dataworks数据集成数据源

- 云原生大数据计算服务 MaxCompute dataworks udf

- 云原生大数据计算服务 MaxCompute dataworks异常

- 云原生大数据计算服务 MaxCompute dataworks接口

- dataworks库云原生大数据计算服务 MaxCompute任务

- dataworks云原生大数据计算服务 MaxCompute实时同步

- dataworks云原生大数据计算服务 MaxCompute实例

- dataworks云原生大数据计算服务 MaxCompute数据迁移

- 云原生大数据计算服务 MaxCompute项目dataworks工作空间

- dataworks云原生大数据计算服务 MaxCompute holo

- dataworks云原生大数据计算服务 MaxCompute外表

- dataworks云原生大数据计算服务 MaxCompute配置调度

- dataworks云原生大数据计算服务 MaxCompute调度资源组

- dataworks云原生大数据计算服务 MaxCompute表增加字段

- dataworks云原生大数据计算服务 MaxCompute表结构

- dataworks导出云原生大数据计算服务 MaxCompute

- 云原生大数据计算服务 MaxCompute dataworks账号

- dataworks连接云原生大数据计算服务 MaxCompute数据源

- dataworks云原生大数据计算服务 MaxCompute选项

- dataworks云原生大数据计算服务 MaxCompute导出

- dataworks云原生大数据计算服务 MaxCompute绑定

- dataworks云原生大数据计算服务 MaxCompute空间绑定

- dataworks云原生大数据计算服务 MaxCompute空间

- dataworks业务流程云原生大数据计算服务 MaxCompute

- dataworks云原生大数据计算服务 MaxCompute查询

云原生大数据计算服务 MaxCompute更多dataworks相关

- dataworks云原生大数据计算服务 MaxCompute报错

- dataworks数据集成云原生大数据计算服务 MaxCompute

- dataworks云原生大数据计算服务 MaxCompute数据源

- dataworks云原生大数据计算服务 MaxCompute配置

- dataworks实时同步云原生大数据计算服务 MaxCompute

- dataworks云原生大数据计算服务 MaxCompute字段

- dataworks云原生大数据计算服务 MaxCompute函数

- dataworks云原生大数据计算服务 MaxCompute文件

- dataworks云原生大数据计算服务 MaxCompute节点

- dataworks云原生大数据计算服务 MaxCompute同步

- dataworks云原生大数据计算服务 MaxCompute oss

- dataworks连接云原生大数据计算服务 MaxCompute

- dataworks云原生大数据计算服务 MaxCompute监控

- dataworks云原生大数据计算服务 MaxCompute任务

- dataworks绑定云原生大数据计算服务 MaxCompute

- dataworks库云原生大数据计算服务 MaxCompute

- dataworks tunnelupload云原生大数据计算服务 MaxCompute管理员

- dataworks云原生大数据计算服务 MaxCompute增量

- dataworks云原生大数据计算服务 MaxCompute功能

- dataworks云原生大数据计算服务 MaxCompute分区表

- dataworks云原生大数据计算服务 MaxCompute访问

- dataworks云原生大数据计算服务 MaxCompute计算

- dataworks云原生大数据计算服务 MaxCompute资源

- 云原生大数据计算服务 MaxCompute dataworks设置

- dataworks绑定云原生大数据计算服务 MaxCompute引擎

- dataworks云原生大数据计算服务 MaxCompute自定义函数

- dataworks库离线同步云原生大数据计算服务 MaxCompute

- dataworks云原生大数据计算服务 MaxCompute区别

- dataworks云原生大数据计算服务 MaxCompute前提条件

- dataworks云原生大数据计算服务 MaxCompute周期

- dataworks离线同步云原生大数据计算服务 MaxCompute同步

- 云原生大数据计算服务 MaxCompute dataworks脚本

- 云原生大数据计算服务 MaxCompute dataworks权限

- dataworks云原生大数据计算服务 MaxCompute cu

- dataworks云原生大数据计算服务 MaxCompute服务

- dataworks空间云原生大数据计算服务 MaxCompute

- dataworks数据同步云原生大数据计算服务 MaxCompute

- dataworks访问云原生大数据计算服务 MaxCompute

- dataworks同步云原生大数据计算服务 MaxCompute

- dataworks云原生大数据计算服务 MaxCompute类型

- dataworks云原生大数据计算服务 MaxCompute映射

- dataworks云原生大数据计算服务 MaxCompute规则

- 云原生大数据计算服务 MaxCompute spark dataworks参数

- dataworks环境云原生大数据计算服务 MaxCompute

- 云原生大数据计算服务 MaxCompute dataworks控制台

- dataworks hologres云原生大数据计算服务 MaxCompute

- dataworks云原生大数据计算服务 MaxCompute hologres

- 云原生大数据计算服务 MaxCompute dataworks功能

- dataworks配置云原生大数据计算服务 MaxCompute分区表达式

- dataworks云原生大数据计算服务 MaxCompute table

云原生大数据计算服务 MaxCompute您可能感兴趣

- 云原生大数据计算服务 MaxCompute基因组

- 云原生大数据计算服务 MaxCompute云平台

- 云原生大数据计算服务 MaxCompute成本

- 云原生大数据计算服务 MaxCompute阿里云

- 云原生大数据计算服务 MaxCompute应用

- 云原生大数据计算服务 MaxCompute计算

- 云原生大数据计算服务 MaxCompute按钮

- 云原生大数据计算服务 MaxCompute set

- 云原生大数据计算服务 MaxCompute跨项目

- 云原生大数据计算服务 MaxCompute返回结果

- 云原生大数据计算服务 MaxCompute MaxCompute

- 云原生大数据计算服务 MaxCompute大数据计算

- 云原生大数据计算服务 MaxCompute数据

- 云原生大数据计算服务 MaxCompute sql

- 云原生大数据计算服务 MaxCompute分析

- 云原生大数据计算服务 MaxCompute技术

- 云原生大数据计算服务 MaxCompute表

- 云原生大数据计算服务 MaxCompute报错

- 云原生大数据计算服务 MaxCompute spark

- 云原生大数据计算服务 MaxCompute大数据

- 云原生大数据计算服务 MaxCompute同步

- 云原生大数据计算服务 MaxCompute任务

- 云原生大数据计算服务 MaxCompute hadoop

- 云原生大数据计算服务 MaxCompute查询

- 云原生大数据计算服务 MaxCompute平台

- 云原生大数据计算服务 MaxCompute项目