[帮助文档] 使用TensorRT-LLM优化大语言模型在GPU上的推理性能

在处理大语言模型任务时,您可以选择在GPU云服务器环境下安装推理引擎TensorRT-LLM,然后通过使用TensorRT-LLM工具实现大语言模型(例如Llama模型、ChatGLM模型、百川Baichuan模型等)在GPU上的高性能推理优化功能。

[帮助文档] 安装和使用AI通信加速库Deepnccl

Deepnccl是为阿里云神龙异构产品开发的用于多GPU互联的AI通信加速库,能够无感地加速基于NCCL通信算子调用的分布式训练或多卡推理等任务。本文主要介绍在Ubuntu或CentOS操作系统的GPU实例上安装和使用Deepnccl的操作方法。

[帮助文档] 使用DeepGPU-LLM实现大语言模型在GPU上的推理优化

在处理大语言模型任务中,您可以根据实际业务部署情况,选择在不同环境(例如GPU云服务器环境或Docker环境)下安装推理引擎DeepGPU-LLM,然后通过使用DeepGPU-LLM工具实现大语言模型(例如Llama模型、ChatGLM模型、百川Baichuan模型或通义千问Qwen模型)在GPU上...

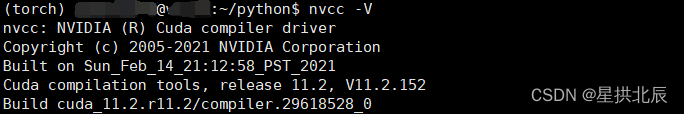

[帮助文档] 手动安装CUDA

如果您想要在GPU云服务器上进行GPU加速计算任务(例如科学计算或大规模并行计算等),则需要安装CUDA开发运行环境。CUDA提供了一整套工具和库,可以帮助您进行GPU加速的程序开发,以充分发挥NVIDIA GPU的计算潜力,提高计算性能和加速运行效率。本文为您介绍如何手动安装CUDA。

[帮助文档] 使用Deepytorch Inference实现模型的推理性能优化

Deepytorch Inference是阿里云自研的AI推理加速器,针对Torch模型,可提供显著的推理加速能力。本文主要介绍安装并使用Deepytorch Inference的操作方法,以及推理效果展示。

Docker【部署 07】镜像内安装tensorflow-gpu及调用GPU多个问题处理Could not find cuda drivers+unable to find libcuda.so...

1.安装tensorflow-gpuBuilding wheels for collected packages: tensorflow-gpu Building wheel for tensorflow-gpu (setup.py): started Building wheel for tens...

tensorflow-gpu-2.3.1安装 tensorflow安装 GPU版本tensorflow安装 tensorflow搭建

1.首先打开Anaconda Prompt终端2. 搭建tensorflow2.3.1 python 3.8.3环境请输入以下代码🎈conda create --name tensorflow2.3.1 python==3.8.3 遇到Process,直接输入“y”,回车就好!3.激活tensor...

Conda安装TensorFlow和PyTorch的GPU支持包

Conda基本操作这里的Conda可以包括Miniconda和Anaconda,是一个统称。配置conda镜像:vim ~/.condarc内容:channels: - defaults show_channel_urls: true default_channels: - https://mirr...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。