参数量不到10亿的OctopusV3,如何媲美GPT-4V和GPT-4?

在人工智能领域,多模态AI代理的发展正迅速改变我们与技术的互动方式。这些AI代理能够处理和学习包括自然语言、视觉和音频输入在内的各种类型的数据,以指导其行动。尽管在整合视觉数据的大型语言模型方面取得了进展,如GPT-4V,但将基于图像的数据有效地转化为AI代理的可操作结果仍然是一个挑战。斯坦福大学的...

没有RLHF,一样媲美GPT-4、Bard,Meta发布650亿参数语言模型LIMA

不需要 RLHF,LIMA 就能和 GPT-4、Bard、DaVinci003 相媲美,甚至更好。作为当前 AI 领域的顶流,ChatGPT、GPT-4 等大模型在文本理解、生成、推理等方面展现出强大的能力,这离不开其背后的生成领域训练新范式 ——RLHF (Reinforcement Learni...

斯坦福70亿参数开源模型媲美GPT-3.5,100美元即可复现

机器之心编辑部学界或许没有业界的算力优势,但可以使用 self-instruct 方法直面大规模语言模型的挑战。随着大规模语言模型的日渐强大,人们对 AI 模型提出了伦理道德方面的更高要求。业界在模型规模扩展方面具有算力资源优势,但要想让模型更规范、可靠,需要学术界的努力。近日,斯坦福基于 Meta...

发布日志记录、公开所有代码,Meta开放1750亿参数大模型,媲美GPT-3

OPT-175B,使人工智能更加开放和可复制。Meta AI 在昨天公布的一篇论文可谓是炸开了锅,论文网站 paperswithcode 热搜榜第一,众多 AI 大佬推荐:LSTM 提出者和奠基者,奥地利人工智能高级研究所(IARAI)创始人 Sepp Hochreiter 教授就在推特上进行了宣传...

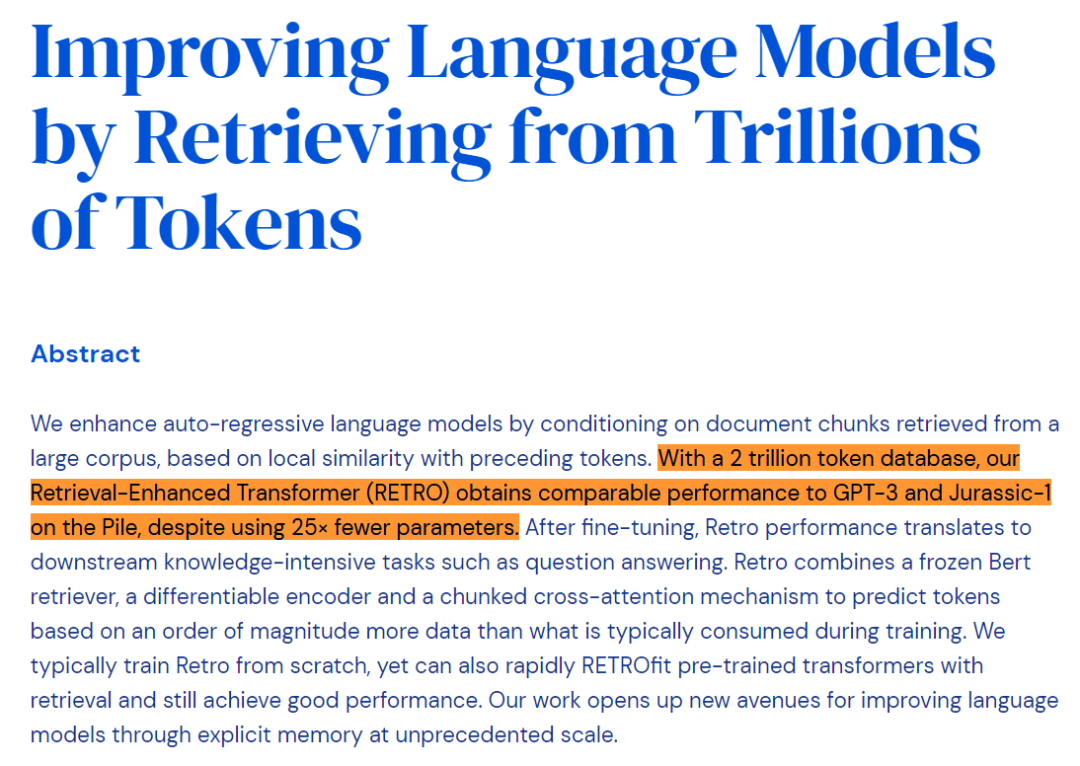

参数量仅为4%,性能媲美GPT-3:开发者图解DeepMind的RETRO

构建越来越大的模型并不是提高性能的唯一方法。从 BERT 到 GPT-2 再到 GPT-3,大模型的规模是一路看涨,表现也越来越惊艳。增大模型规模已经被证明是一条可行的改进路径,而且 DeepMind 前段时间的一些研究表明:这条路还没有走到头,继续增大模型依然有着可观的收益。但与此同时,我们也知道...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。