Flink流式处理百万数据量CSV文件(下)

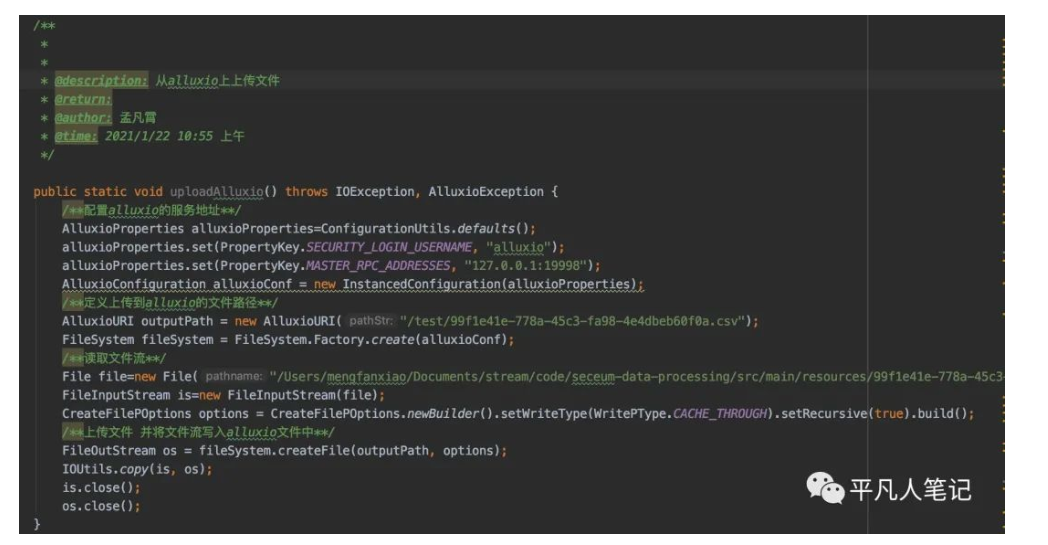

将文件流写入本地源码https://gitee.com/pingfanrenbiji/resource/tree/master/flink/code/alluxioFlink流式处理数据结合当前业务梳理流程来源数据源:数百万数据量的CSV文件 结果保存数据:CSV或Mysql略过表头在已知几列的情况...

Flink流式处理百万数据量CSV文件(中)

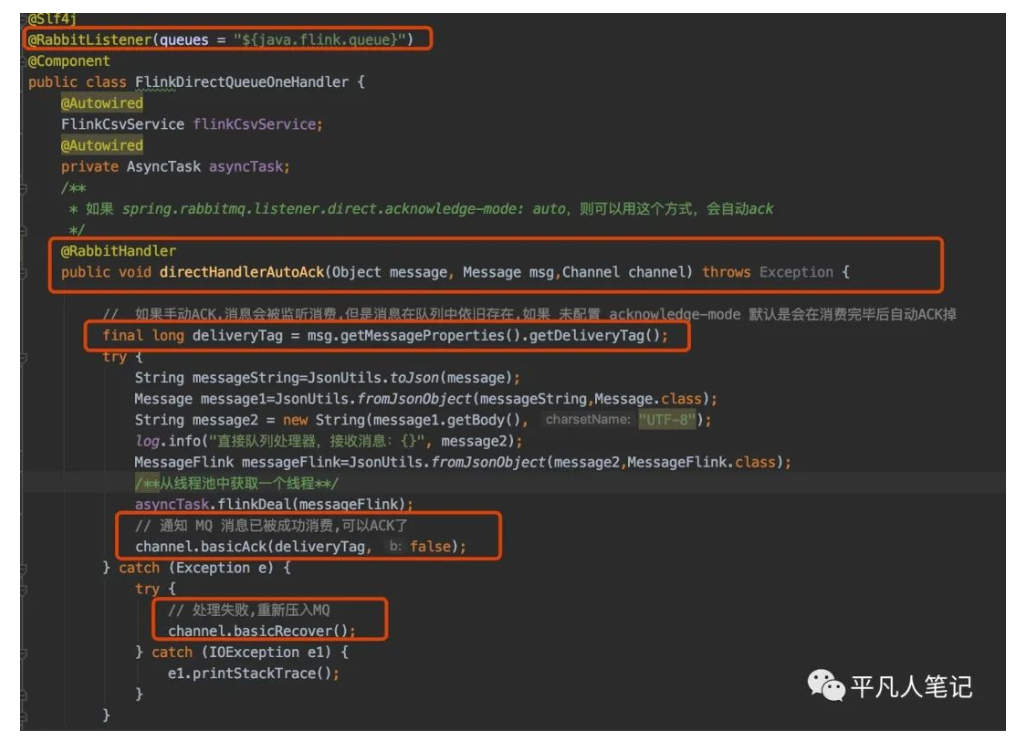

方式二 注解方式对类添加@RabbitListener(queues = "${java.flink.queue}")注解指定队列名称 可从配置文件中读取对方法添加 @RabbitHandler 注解三个参数Object message任意类型的消息 # 解析mq消息 String messageS...

Flink流式处理百万数据量CSV文件(上)

前言最近公司让做一个'没有必要'的需求需求针对的对象这是同一个csv文件的不同展示形式Excel展示形式这个csv文件中可能有数百万条数据需求将所有的异常数据检测出来什么样的数据是异常数据圈红的数据我手动添加了一个a原本是数字类型现在变成了一个字符串类型那么程序中将字符串类型转换为数字类型的话就会报...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

实时计算 Flink版您可能感兴趣

- 实时计算 Flink版cp

- 实时计算 Flink版设置

- 实时计算 Flink版HDFS

- 实时计算 Flink版SQL

- 实时计算 Flink版版本

- 实时计算 Flink版任务

- 实时计算 Flink版sp

- 实时计算 Flink版oracle

- 实时计算 Flink版消耗

- 实时计算 Flink版迁移

- 实时计算 Flink版CDC

- 实时计算 Flink版数据

- 实时计算 Flink版mysql

- 实时计算 Flink版同步

- 实时计算 Flink版报错

- 实时计算 Flink版kafka

- 实时计算 Flink版表

- 实时计算 Flink版Apache

- 实时计算 Flink版配置

- 实时计算 Flink版实时计算

- 实时计算 Flink版flink

- 实时计算 Flink版 CDC

- 实时计算 Flink版模式

- 实时计算 Flink版运行

- 实时计算 Flink版数据库