json作为csv一个列 flink ddl可以直接把json内字段解析出来吗?

json作为csv一个列 flink ddl可以直接把json内字段解析出来吗? eg: name1,18,{'k1':'v1'}

Flink CDC中csv文件是bgk的,需要转成utf8,否则就乱码了?

Flink CDC中csv文件是bgk的,需要转成utf8,否则就乱码了?

求问各位大佬,Flink中如果数据源为kafka,每条数据格式为结构化的csv格式,把接收到的数据?

求问各位大佬,Flink中如果数据源为kafka,每条数据格式为结构化的csv格式,把接收到的数据insert到hive中,能把数据源的更新和删除同步到hive吗?如何告诉flink这条数据流是insert、update还是delete么?

Flink如何读取远程服务器上的csv文件数据?

请问大神们Flink如何读取远程服务器上的csv文件数据?目前根据官方文档能看到的基本上是读取本地文件的方法,方法如下? public class ExploreCsvFileService { public static void main(String[] args) throws Except...

flink怎么读取csv表格数据?

flink怎么读取csv表格数据?

Flink 我在sql cli执行连接kafka建表sql(该kafka接收csv数据),然后有一条

Flink 我在sql cli执行连接kafka建表sql(该kafka接收csv数据),然后有一条数据造的不符合字段格式,导致报错,然后该flink作业就无法继续running了,请问该如何处理呢?

Flink流式处理百万数据量CSV文件(下)

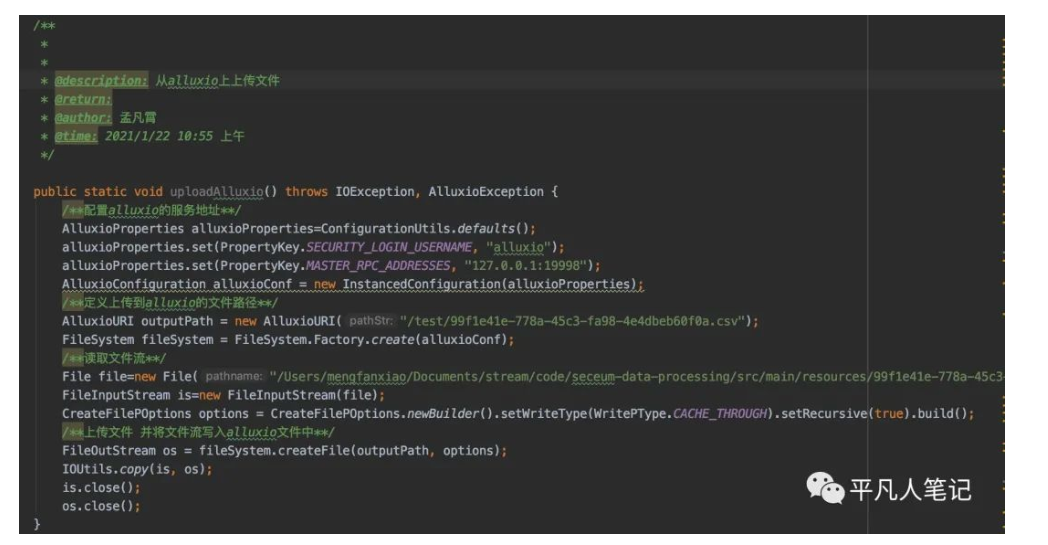

将文件流写入本地源码https://gitee.com/pingfanrenbiji/resource/tree/master/flink/code/alluxioFlink流式处理数据结合当前业务梳理流程来源数据源:数百万数据量的CSV文件 结果保存数据:CSV或Mysql略过表头在已知几列的情况...

Flink流式处理百万数据量CSV文件(中)

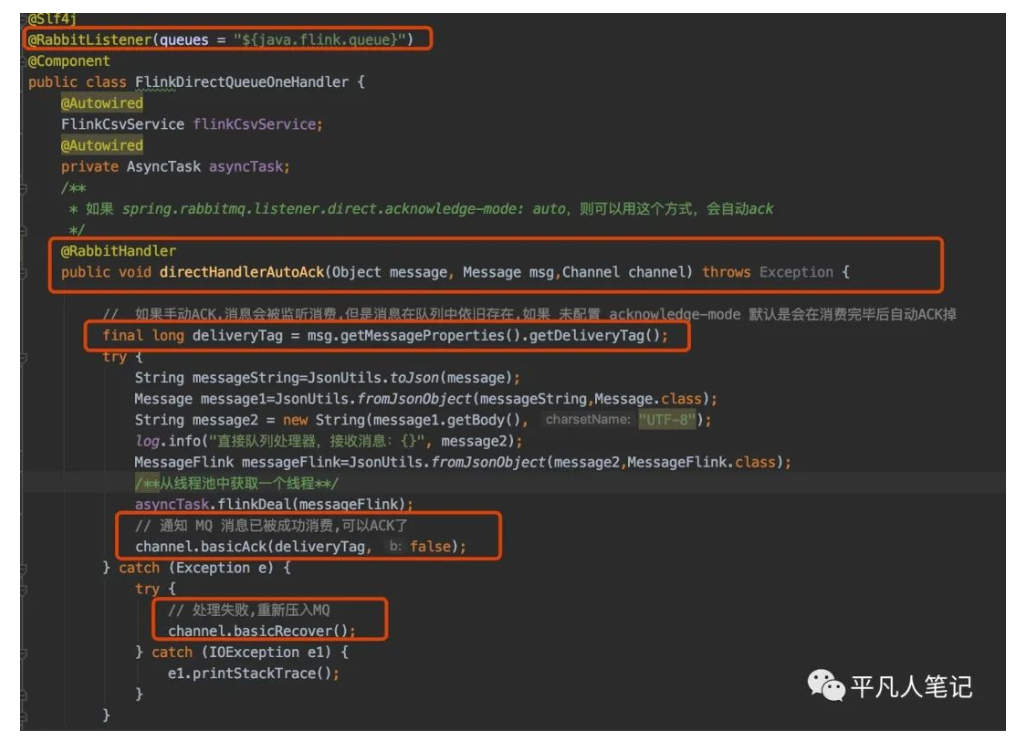

方式二 注解方式对类添加@RabbitListener(queues = "${java.flink.queue}")注解指定队列名称 可从配置文件中读取对方法添加 @RabbitHandler 注解三个参数Object message任意类型的消息 # 解析mq消息 String messageS...

Flink流式处理百万数据量CSV文件(上)

前言最近公司让做一个'没有必要'的需求需求针对的对象这是同一个csv文件的不同展示形式Excel展示形式这个csv文件中可能有数百万条数据需求将所有的异常数据检测出来什么样的数据是异常数据圈红的数据我手动添加了一个a原本是数字类型现在变成了一个字符串类型那么程序中将字符串类型转换为数字类型的话就会报...

Flink SQL csv格式分隔符设置失败怎么解决?

Flink 版本:1.11.1 我的flink sql: create table stream_tmp.t1( log string) with ( 'connector' = 'kafka', 'topic' = 't1', 'properties.bootstrap.servers' = 'x...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

实时计算 Flink版csv相关内容

实时计算 Flink版您可能感兴趣

- 实时计算 Flink版并行度

- 实时计算 Flink版数据

- 实时计算 Flink版回滚

- 实时计算 Flink版同步

- 实时计算 Flink版killed

- 实时计算 Flink版批处理

- 实时计算 Flink版任务

- 实时计算 Flink版实践

- 实时计算 Flink版作业

- 实时计算 Flink版合流

- 实时计算 Flink版报错

- 实时计算 Flink版oracle

- 实时计算 Flink版版本

- 实时计算 Flink版表

- 实时计算 Flink版配置

- 实时计算 Flink版设置

- 实时计算 Flink版 CDC

- 实时计算 Flink版模式

- 实时计算 Flink版运行

- 实时计算 Flink版数据库

- 实时计算 Flink版连接

- 实时计算 Flink版库

- 实时计算 Flink版全量

- 实时计算 Flink版参数

- 实时计算 Flink版集群

- 实时计算 Flink版日志