手把手教会你使用Python进行jieba分词

一、引言 在自然语言处理和文本分析中,中文分词是至关重要的一步。正确的分词可以为后续的文本处理任务提供更好的基础。jieba库作为Python中常用的中文分词工具,受到了广泛的欢迎。本文将详细介绍如何使用jieba库进行中文分词,帮助你从零开始掌握这一技能。 ...

【Python学习笔记】使用jieba分词,输出字符长度大于2词组成的列表(计算机二级题目)

问题: jieba库是中文分词的第三方库,可以将文本通过分词获得词语。请你根据以下要求编写程序:1.程序允许输入一段文本,并使用“精准模式”将该文本进行分词;2、找出所有字符长度大于等于2的词,存入列表并打印该列表。输入格式字符串语句输出格式列表输入输出示例 示例1示例2输入我与父亲不相见已二年余了...

【Python数据处理】jieba分词统计词频数与word搜索数不一致的问题

问题:运用python中的jieba语句进行分词时,得到的词频统计与word搜索数不一致 原因:cut_all参数设置的问题 >>import jieba >>seg_list_exact = jieba.cut(data,cut_all = False) cut_all参...

Python数据分析(4):jieba分词详解

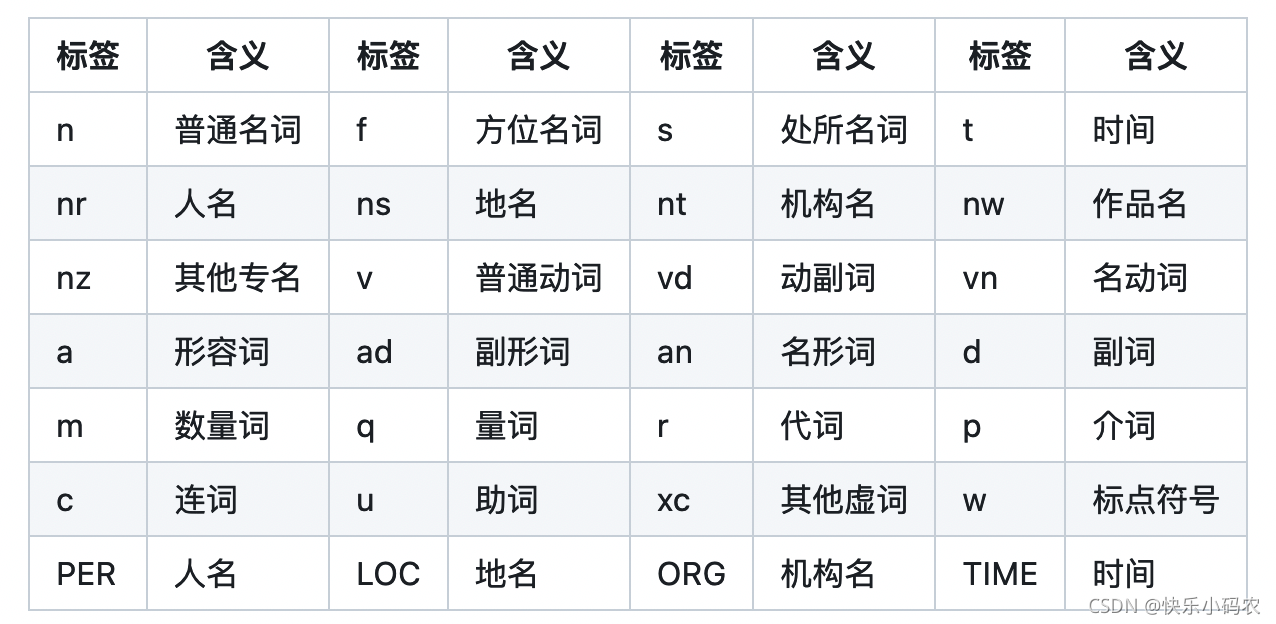

jieba分词器1. jieba分词器的分词模式说明jieba分词器提供4种分词模式,并且支持简体/繁体分词、自定义词典、关键词提取、词性标注。(1)精确模式该模式会将句子最精确地切分开,适合在文本分析时使用。(2)全模式该模式会将句子中所有成词的词语都扫描出来,速度也非常快,缺点是不...

Python大数据:jieba分词,词频统计

实验目的 学习如何读取一个文件 学习如何使用DataFrame 学习jieba中文分词组件及停用词处理原理 了解Jupyter Notebook 概念 中文分词 在自然语言处理过程中,为了能更好地处理句子,往往需要把句子拆开分成一个一个的词语,这样能更好的分析句子的特性,这个过程叫就叫做分词。由于中...

python结巴(jieba)分词

一、特点 1、支持三种分词模式: (1)精确模式:试图将句子最精确的切开,适合文本分析。 (2)全模式:把句子中所有可以成词的词语都扫描出来,速度非常快,但是不能解决歧义。 (3)搜索引擎模式:在精确模式的基础上,对长词再次切分,提高召回率,适合用于搜索引擎分词。2、支持繁体分词3、支持自定义...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。