关于Prompt Engineering你该了解啥?OpenAI应用研究负责人帮你梳理了(2)

增强语言模型[Mialon et al. (2023) ] 对增强语言模型进行的一项调查。涵盖了多类增强推理技能和使用外部工具能力的语言模型。推荐读者可以读一下。检索通常,我们需要在模型预训练时间截止或内部 / 私有知识库之后,完成需要最新知识的任务。在这种情况下,如果不在 prompt 中显式提供...

关于Prompt Engineering你该了解啥?OpenAI应用研究负责人帮你梳理了(1)

关于Prompt Engineering你该了解啥?OpenAI应用研究负责人帮你梳理了机器之心 2023-04-22 12:21 发表于北京选自Lil’Log机器之心编译编辑:rome rome随着 ChatGPT、GPT-4 等模型的兴起,人们对如何创建提示以获得想要的输出越来越感兴趣...

为内存塞不下Transformer犯愁?OpenAI应用AI研究负责人写了份指南(3)

为了更好地处理长序列数据,Scaling Transformer 进一步配备了来自 Reformer 的 LSH(局部敏感哈希)注意力和 FFN 块循环,从而产生了 Terraformer 模型。混合专家系统 MoE专家混合系统 (MoE) 模型是一种专家网络的集合,每个样本仅激活网络的一个子集来获...

为内存塞不下Transformer犯愁?OpenAI应用AI研究负责人写了份指南(2)

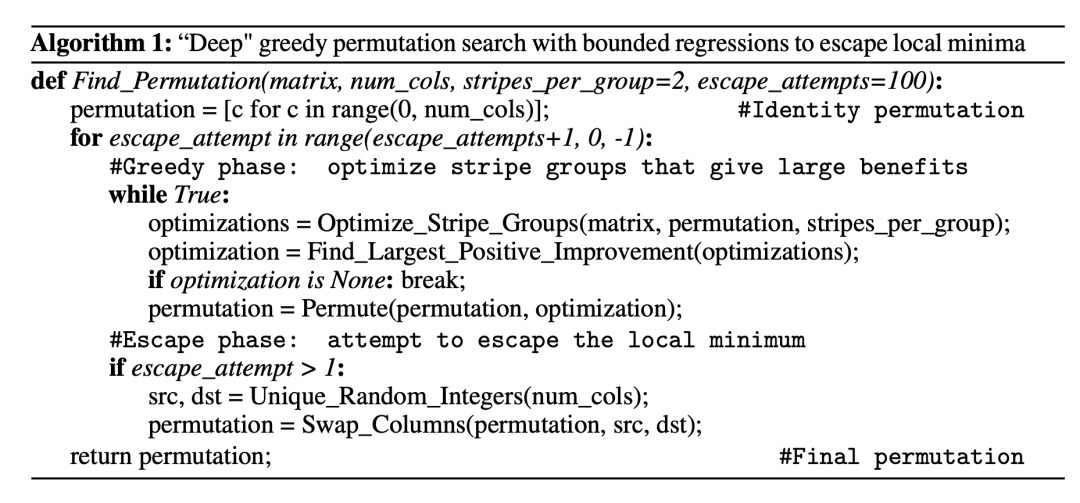

为了推动 N:M 结构稀疏化,需要将一个矩阵的列拆分为 M 列的多个 slide(也称为 stripe),这样可以很容易地观察到每个 stripe 中的列顺序和 stripe 的顺序对 N:M 稀疏化产生的限制。Pool 和 Yu 提出了一种迭代式的贪心算法来寻找最优排列,使 N:M 稀疏化的权重幅...

为内存塞不下Transformer犯愁?OpenAI应用AI研究负责人写了份指南(1)

本文是一篇综述性的博客,探讨总结当下常用的大型 transformer 效率优化方案。大型 Transformer 模型如今已经成为主流,为各种任务创造了 SOTA 结果。诚然这些模型很强大,但训练和使用起来代价非常昂贵。在时间和内存方面存在有极高的推理成本。概括来说,使用大型 Transforme...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。