预训练语言模型中Transfomer模型、自监督学习、BERT模型概述(图文解释)

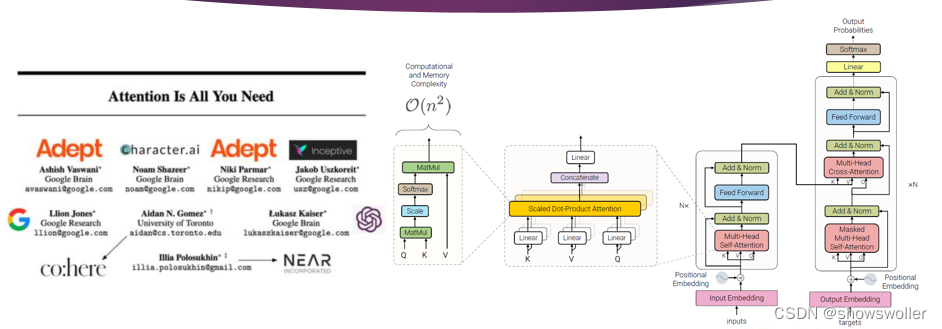

一、Transformer变换器模型Transformer模型的编码器是由6个完全相同的层堆叠而成,每一层有两个子层 。第一个子层是多头自注意力机制层,第二个子层是由一一个简单的、按逐个位置进行全连接的前馈神经网络。在两个子层之间通过残差网络结构进行连接,后接一一个层正则化层。可以得出,每一一个子层...

大型语言模型:SBERT — 句子BERT

了解 siamese BERT 网络如何准确地将句子转换为嵌入 简介 Transformer 在 NLP 领域取得了进化性的进步,这已不是什么秘密。基于 Transformer,还发展出了许多其他机器学习模型。其中之一是 BERT,它主要由几个堆叠的 Transformer 编码器组成。除了用于一系...

![大语言模型的预训练[1]:基本概念原理、神经网络的语言模型、Transformer模型原理详解、Bert模型原理介绍](https://ucc.alicdn.com/fnj5anauszhew_20230717_e843a02529534b84bf8ff46d8b43e094.png)

大语言模型的预训练[1]:基本概念原理、神经网络的语言模型、Transformer模型原理详解、Bert模型原理介绍

大语言模型的预训练[1]:基本概念原理、神经网络的语言模型、Transformer模型原理详解、Bert模型原理介绍 1.大语言模型的预训练 1.LLM预训练的基本概念 预训练属于迁移学习的范畴。现有的神经网络在进行训练时,一般基于反向传播(Back Propagation,BP)算法,先对网络中的...

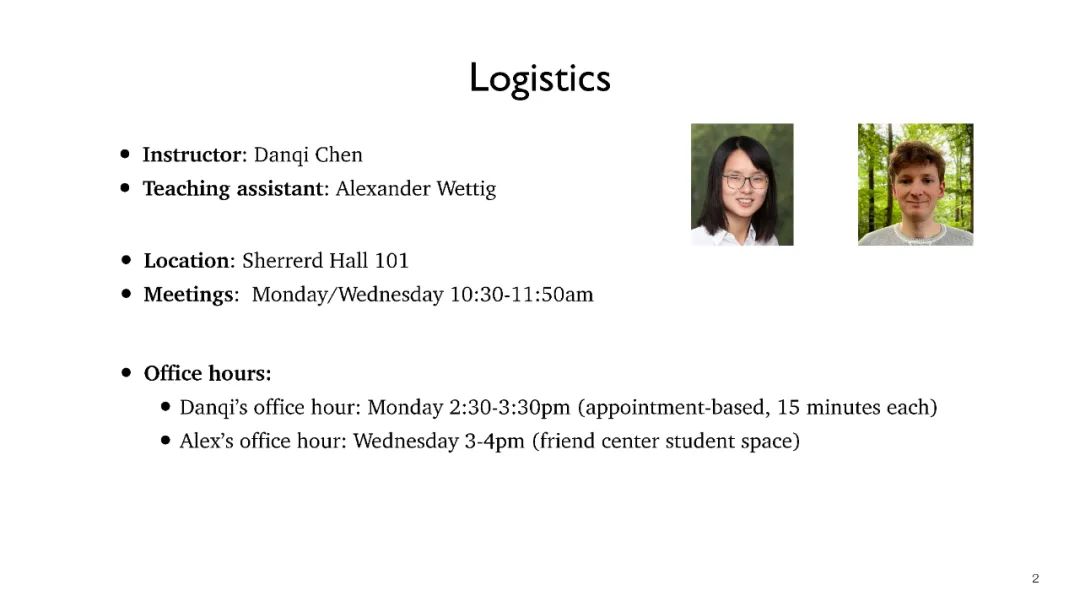

不可错过!普林斯顿陈丹琦最新《大语言模型理解》2022课程!全面讲述BERT、GPT、T5等大模型,附Slides

【新智元导读】本课程旨在帮助您在自然语言处理方面进行前沿研究,特别是与预训练语言模型相关的主题。在过去3-4年中,大型语言模型(LLMs)彻底改变了自然语言处理(NLP)领域。它们构成了最先进的系统的基础,在解决广泛的自然语言理解和生成任务时无处不在。随着前所未有的潜力和能力,这些模型也带来了新的道...

BERT:深度双向预训练语言模型

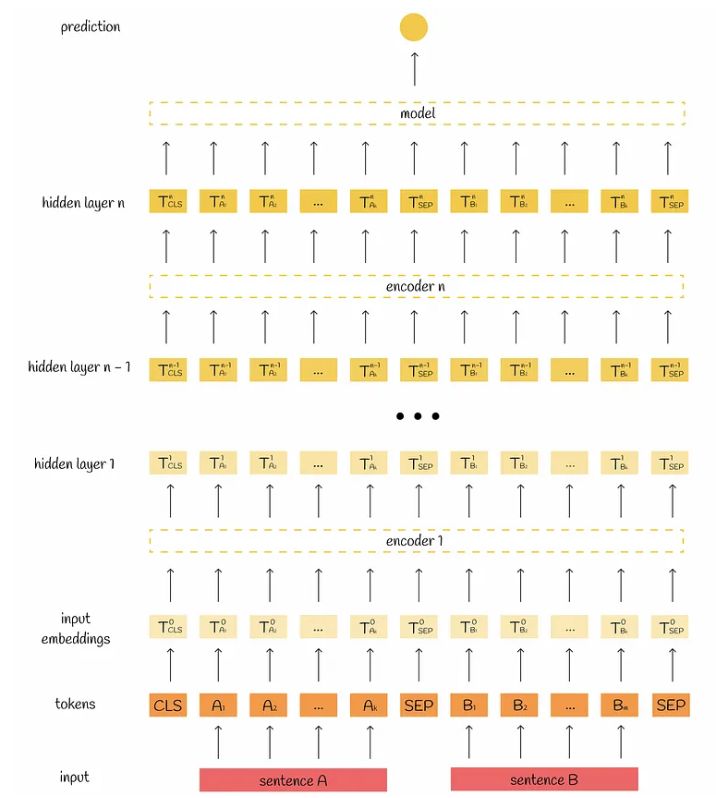

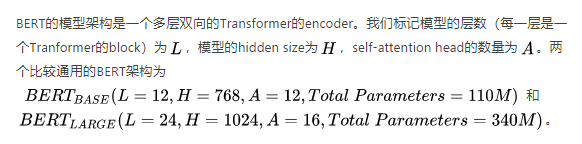

论文标题:BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding论文链接:https://arxiv.org/abs/1810.04805一、概述简介BERT(Bidirectional Enc...

【NLP】(task3上)预训练语言模型——BERT

一、前言将Transformer模型结构发扬光大的一个经典模型:BERT。BERT在2018年出现。2018 年是机器学习模型处理文本(或者更准确地说,自然语言处理或 NLP)的转折点。我们对这些方面的理解正在迅速发展:如何最好地表示单词和句子,从而最好地捕捉基本语义和关系?此外,NL...

用BERT构建最先进语言模型

2018年,在引入了迁移学习之后,自然语言处理(NLP,Natural Language Processing)领域发生了革命性的变化。BERT(Bidirectional Encoder Representations from Transformers)是谷歌人工智能团队在2018年推出的一个典...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。