函数计算FC切换模型咋还内存不足?

函数计算FC切换模型咋还内存不足?

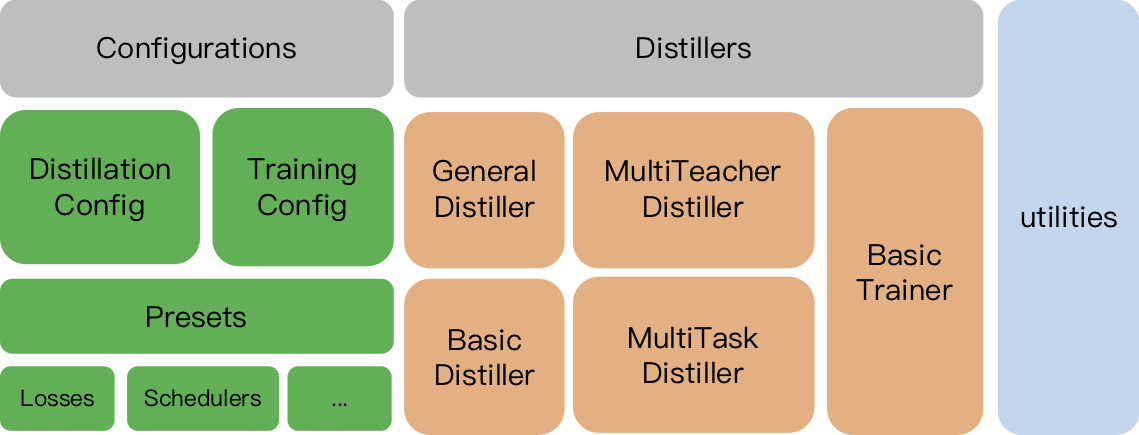

TextBrewer:融合并改进了NLP和CV中的多种知识蒸馏技术、提供便捷快速的知识蒸馏框架、提升模型的推理速度,减少内存占用

TextBrewer:融合并改进了NLP和CV中的多种知识蒸馏技术、提供便捷快速的知识蒸馏框架、提升模型的推理速度,减少内存占用 TextBrewer是一个基于PyTorch的、为实现NLP中的知识蒸馏任务而设计的工具包,融合并改进了NLP和CV中的多种知识蒸馏技术,提供便捷快速的知识蒸馏框架,用于...

函数计算FC的sd 配置,是否需要加载模型在内存?

函数计算FC的sd 配置,是否需要加载模型在内存?如果存在请求时切换模型的需求,此时如何配置更好一些?

您好,请问ModelScope:我使用魔塔平台提供的模型,运行,出现内存不够,请问如何操作?最大16

您好,请问ModelScope:我使用魔塔平台提供的模型,运行,出现内存不够,请问如何操作?最大16G显存不够用?是需要自动搭建更大显存的服务器吗? 模型,使用官方推荐的免费试用服务器,显示内存不够,可以自定义这个显卡内存吗?

LeCun转赞:在苹果M1/M2芯片上跑LLaMA!130亿参数模型仅需4GB内存

新智元报道 编辑:好困【新智元导读】现在,Meta最新的大语言模型LLaMA,可以在搭载苹果芯片的Mac上跑了!前不久,Meta前脚发布完开源大语言模型LLaMA,后脚就被网友放出了无门槛下载链接,「惨遭」开放。消息一出,圈内瞬间就热闹了起来,大家纷纷开...

求助,调用模型后,为什么modelscope library进程不结束,内存就无法释放?

求助,调用模型后,为什么modelscope library进程不结束,内存就无法释放?

《Java 并发编程》共享模型之内存

Java 内存模型(Java Memory Model,JMM),定义了主存、工作内存抽象概念,底层对应着 CPU 寄存器、缓存、硬件内存和 CPU 指令优化等。JMM 体现在以下几个方面:原子性:保证指令不受到线程上下文的影响。可见性:保证指令不会受 CPU 缓存的影响。有序性&#x...

ModelScope调用翻译模型时候,80g的gpu内存几乎占满了,在哪里设置内存分配比例?

ModelScope调用翻译模型时候,80g的gpu内存几乎占满了,在哪里设置内存分配比例?

ModelScope中OFA模型对于内存容量有要求吗?

ModelScope中OFA模型对于内存容量有要求吗?

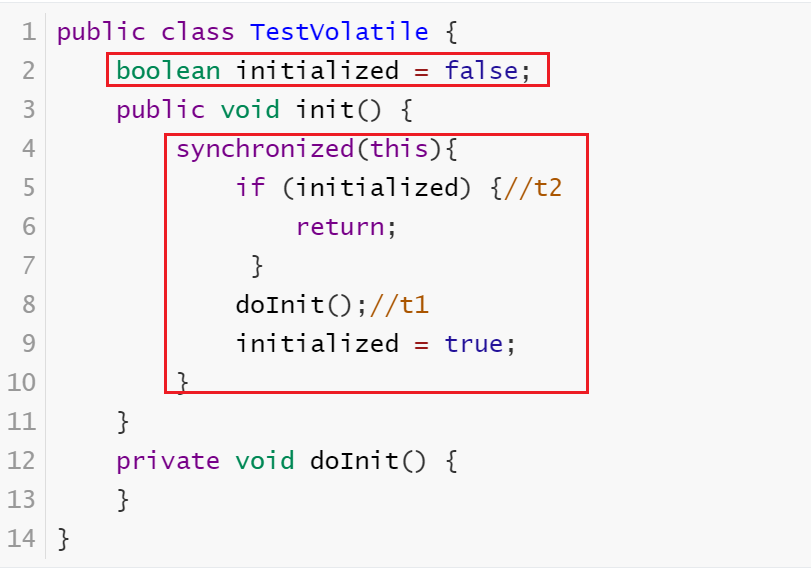

《JUC并发编程 - 高级篇》04 -共享模型之内存 (Java内存模型 | 可见性 | 有序性 )(下)

5.4 习题5.4.1 balking 模式习题希望 doInit() 方法仅被调用一次,下面的实现是否有问题,为什么?public class TestVolatile { boolean initialized = false; public void init() { synchronized...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

产品推荐

最佳实践