[帮助文档] 清理过期数据

清理过期数据可以释放存储空间,优化资源利用并提升系统运行效率等。本文为您介绍如何清理Paimon表过期数据,包括调整快照文件过期时间、设置分区的过期时间、以及清理废弃文件。

[帮助文档] Paimon表数据写入和消费

本文为您介绍如何在实时计算开发控制台向Paimon表中插入、更新、覆写或删除数据,以及从Paimon表消费数据,并指定消费位点。

[帮助文档] 使用UDAF实现数据排序和聚合

本文提供了一个自定义聚合函数(UDAF),实现将多行数据合并为一行并按照指定列进行排序,并以居民用电户电网终端数据为例,介绍如何在实时计算控制台使用该函数进行数据聚合和排序。

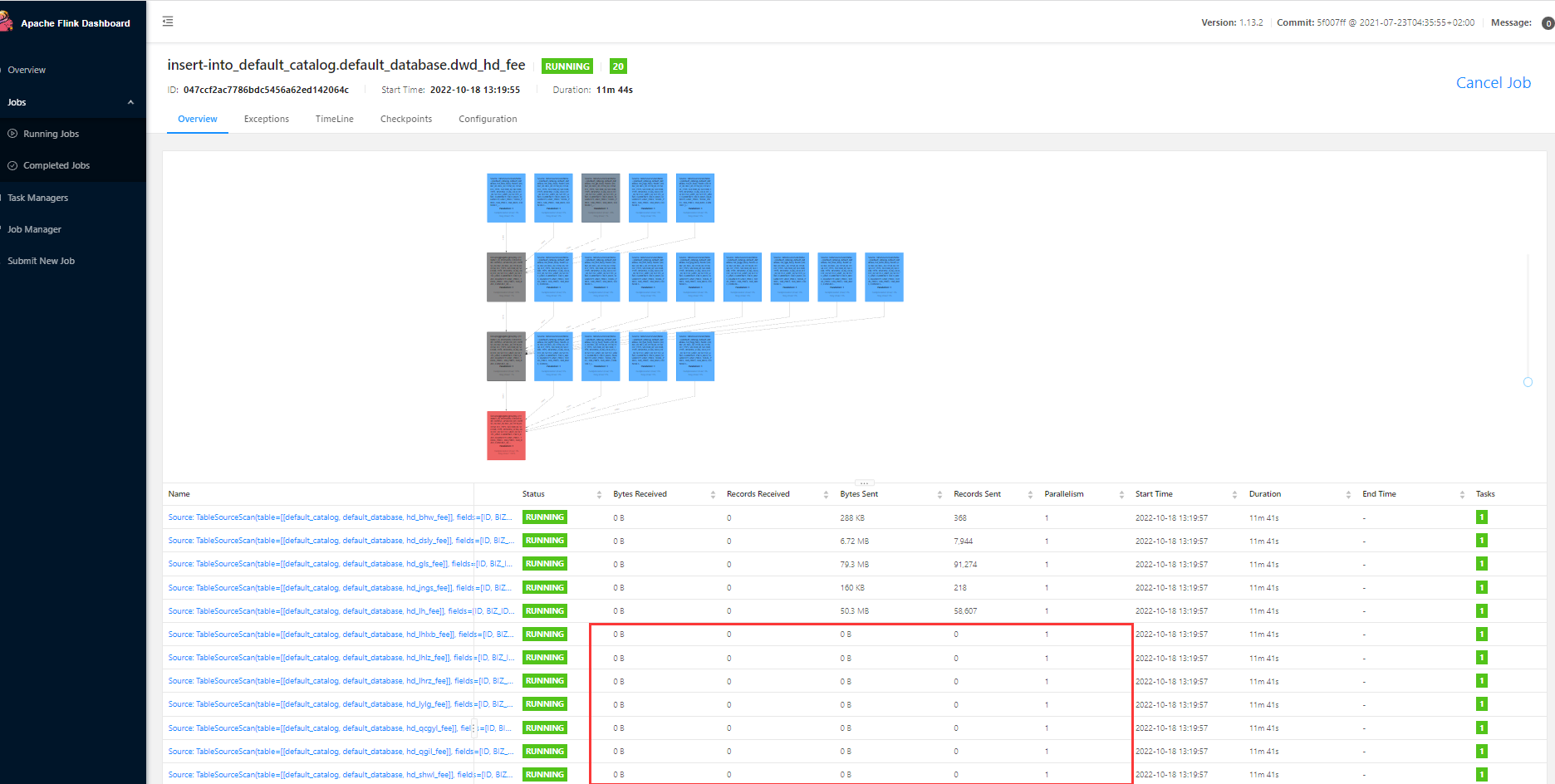

Flink数据源问题合集之结果超过源数据如何解决

问题一:flink sql 1.9 可以通过sql的方式 join 关联外部数据源吗? 想问一下,目前flink sql 1.9 可以通过sql的方式 join 关联外部数据源吗? 比如说通过sql DDL 定义一个Hbase的维表数据源,然后用sql join关联上。 CREATETABLEMyU...

Flink数据源问题合集之无法写入数据如何解决

问题一:linksql 如何保证我的维度表是新的维度表呢?就是比如我的数据源是 hive, 每天处理一次,flinkstreaming join 的表 就是 T-1 的维度表,运行到第T+1 天怎么确保,我join 的维度表是 T 天的维度表 请教个技术问题,flinksql 如何保证我的维度表是新...

Flink数据源问题合集之数据删除如何解决

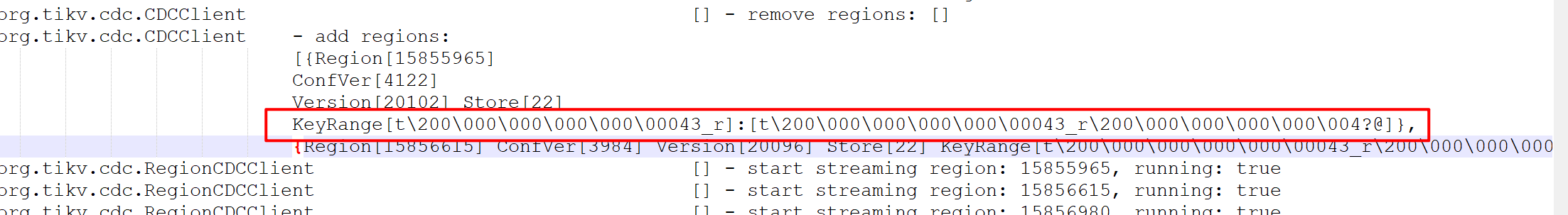

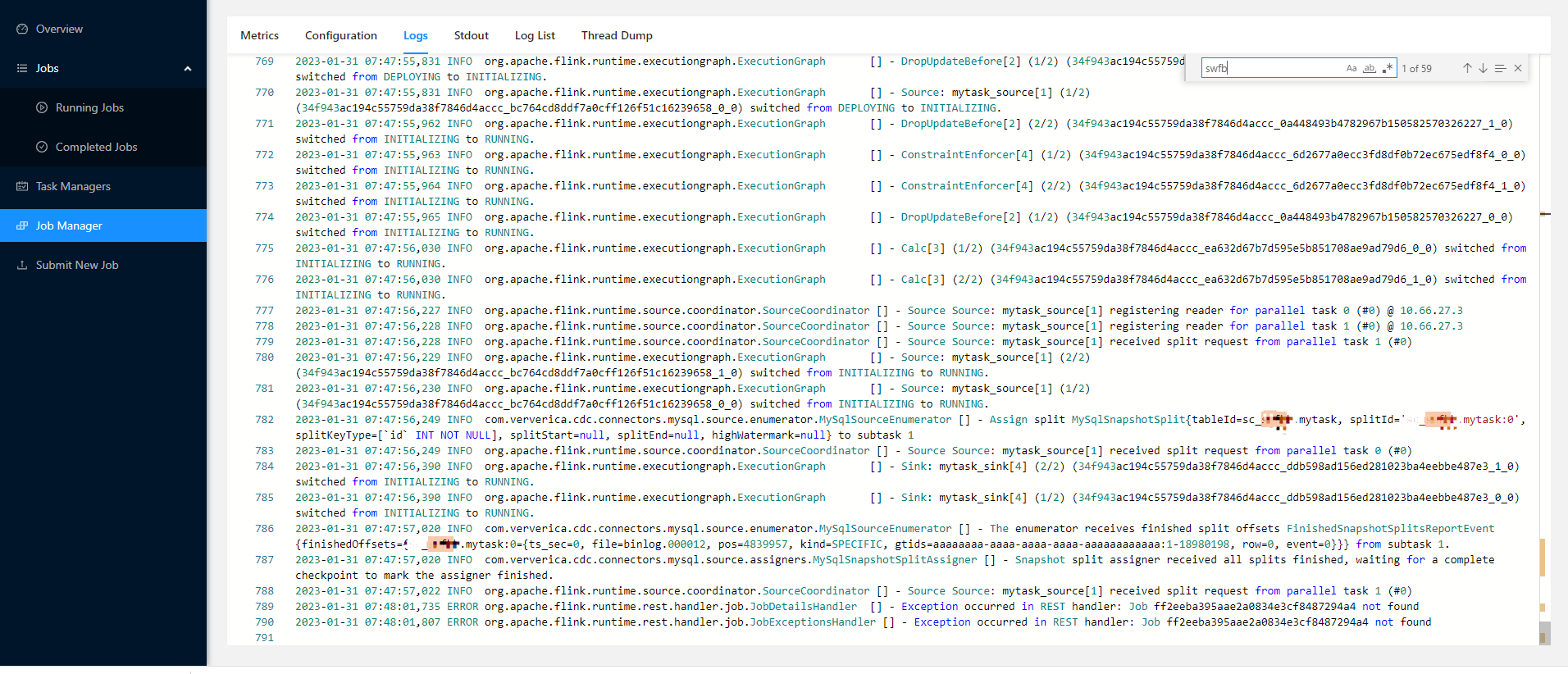

问题一:flink 1.16.0没捕获到源mysql表数据的变化,请问又可能是什么原因呢? flink 1.16.0没捕获到源mysql表数据的变化,请问又可能是什么原因呢?源库的binlog是开启了的 ...

Flink数据源问题合集之无法读取源数据如何解决

问题一:用flinksql同步数据,后续如果源表有删数据的操作,结果表不会删除怎么办? 用flinksql同步数据,后续如果源表有删数据的操作,结果表不会删除怎么办? 参考回答: 会同步,一般都是软删。 关于本问题的更多回答可点击原文查看:https://developer.aliyun.com/a...

[帮助文档] 实时计算Flink版集成物联网平台数据的连接器

在使用Flink SQL开发作业集成物联网平台数据时,需要使用SQL连接器连接物联网平台的数据表(产品属性时序数据、产品事件数据和自定义时序存储表)。物联网平台提供了连接器作为实时计算Flink全托管自定义连接器使用。本文介绍如何使用实时计算Flink版集成物联网平台数据的连接器(IoT Conne...

[帮助文档] 通过实时计算Flink集成向量数据

云原生数据仓库AnalyticDB PostgreSQL版支持通过flink-adbpg-connector集成向量化数据。本文以将Kafka数据导入至AnalyticDB PostgreSQL版为例,介绍如何将向量数据导入AnalyticDB PostgreSQL版。

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

实时计算 Flink版数据相关内容

- 实时计算 Flink版数据checkpoint

- 实时计算 Flink版同步数据checkpoint

- 实时计算 Flink版同步全量数据checkpoint

- 实时计算 Flink版全量数据checkpoint

- 实时计算 Flink版产品全量数据

- 实时计算 Flink版全量数据

- 实时计算 Flink版同步数据

- 实时计算 Flink版产品同步数据

- 实时计算 Flink版产品数据

- 实时计算 Flink版同步全量数据

- 实时计算 Flink版产品全量数据checkpoint

- 实时计算 Flink版服务数据

- 实时计算 Flink版加载数据

- 实时计算 Flink版jdbc数据

- 实时计算 Flink版clickhouse数据

- 实时计算 Flink版数据目标表

- 实时计算 Flink版数据名称

- 实时计算 Flink版sqlclient数据

- 实时计算 Flink版数据oceanbase

- 实时计算 Flink版存量数据

- 实时计算 Flink版内存数据

- 实时计算 Flink版产品增量数据

- 实时计算 Flink版增量数据

- 实时计算 Flink版timestamp数据

- 实时计算 Flink版ttl数据

- 实时计算 Flink版设置数据

- 实时计算 Flink版产品设置数据

- 实时计算 Flink版设置ttl数据

- 实时计算 Flink版ckp数据

- 实时计算 Flink版统计数据数据

- 实时计算 Flink版产品mysql数据库数据

- 实时计算 Flink版数据变动

- 实时计算 Flink版监听mysql数据

- 实时计算 Flink版mysql数据库数据

- 实时计算 Flink版mysql数据

- 实时计算 Flink版产品监听数据

- 实时计算 Flink版监听数据

- 实时计算 Flink版日期统计数据撤回库

- 实时计算 Flink版mysql-cdc监听数据变动

- 实时计算 Flink版日期数据

- 实时计算 Flink版数据延迟

- 实时计算 Flink版mysql数据增量

- 实时计算 Flink版数据增量

- 实时计算 Flink版产品数据增量

- 实时计算 Flink版版本同步数据

- 实时计算 Flink版报错kafka数据

- 实时计算 Flink版sql protobuf数据

- 实时计算 Flink版kafka数据

- 实时计算flink实时计算 Flink版数据

实时计算 Flink版更多数据相关

- 实时计算 Flink版cdc mysql数据

- 数据实时计算 Flink版

- 实时计算 Flink版任务数据

- 实时计算 Flink版数据报错

- 实时计算 Flink版采集数据

- 实时计算 Flink版同步数据库

- 实时计算 Flink版库数据

- 实时计算 Flink版数据kafka

- 实时计算 Flink版数据配置

- 实时计算 Flink版cdc sql数据

- 实时计算 Flink版数据字段

- 实时计算 Flink版sink数据

- 实时计算 Flink版数据doris

- 实时计算 Flink版窗口数据

- 实时计算 Flink版binlog数据

- 实时计算 Flink版source数据

- 实时计算 Flink版数据变更

- 实时计算 Flink版doris数据

- 实时计算 Flink版cdc监听数据

- 实时计算 Flink版数据任务

- 实时计算 Flink版连接数据

- 实时计算 Flink版捕获数据

- 实时计算 Flink版数据参数

- 实时计算 Flink版数据设置

- 实时计算 Flink版sqlserver数据

- 实时计算 Flink版维表数据

- 实时计算 Flink版oracle同步数据

- 实时计算 Flink版初始化数据

- 实时计算 Flink版日志数据

- 实时计算 Flink版数据es

- 实时计算 Flink版数据sink

- 实时计算 Flink版数据全量

- 实时计算 Flink版报错数据

- 实时计算 Flink版运行数据

- 实时计算 Flink版库同步数据

- 实时计算 Flink版checkpoint数据

- 实时计算 Flink版数据hudi

- 实时计算 Flink版字段数据

- 实时计算 Flink版mongodb数据

- 实时计算 Flink版flinksql数据

- 实时计算 Flink版pg数据

- 实时计算 Flink版数据异常

- 实时计算 Flink版datastream数据

- 实时计算 Flink版json数据

- 实时计算 Flink版源表数据

- 实时计算 Flink版数据办法

- 实时计算 Flink版格式数据

- 实时计算 Flink版hive数据

- 实时计算 Flink版模式数据

- 实时计算 Flink版数据日志

实时计算 Flink版您可能感兴趣

- 实时计算 Flink版flink

- 实时计算 Flink版任务启动

- 实时计算 Flink版产品

- 实时计算 Flink版初始化

- 实时计算 Flink版参数

- 实时计算 Flink版存储

- 实时计算 Flink版全量

- 实时计算 Flink版同步

- 实时计算 Flink版api

- 实时计算 Flink版CDC

- 实时计算 Flink版SQL

- 实时计算 Flink版mysql

- 实时计算 Flink版报错

- 实时计算 Flink版任务

- 实时计算 Flink版oracle

- 实时计算 Flink版版本

- 实时计算 Flink版kafka

- 实时计算 Flink版表

- 实时计算 Flink版Apache

- 实时计算 Flink版配置

- 实时计算 Flink版设置

- 实时计算 Flink版 CDC

- 实时计算 Flink版模式

- 实时计算 Flink版运行

- 实时计算 Flink版数据库

- 实时计算 Flink版实时计算