DataWorks报错问题之集成hive数据源报错如何解决

问题一:DataWorks中 di节点从mc同步数据到FTP txt文本产生Exception 怎么回事? DataWorks中 di节点从mc同步数据到FTP txt文本产生Exception in thread "pool-2-thread-1" java.lang.OutOfMemoryErr...

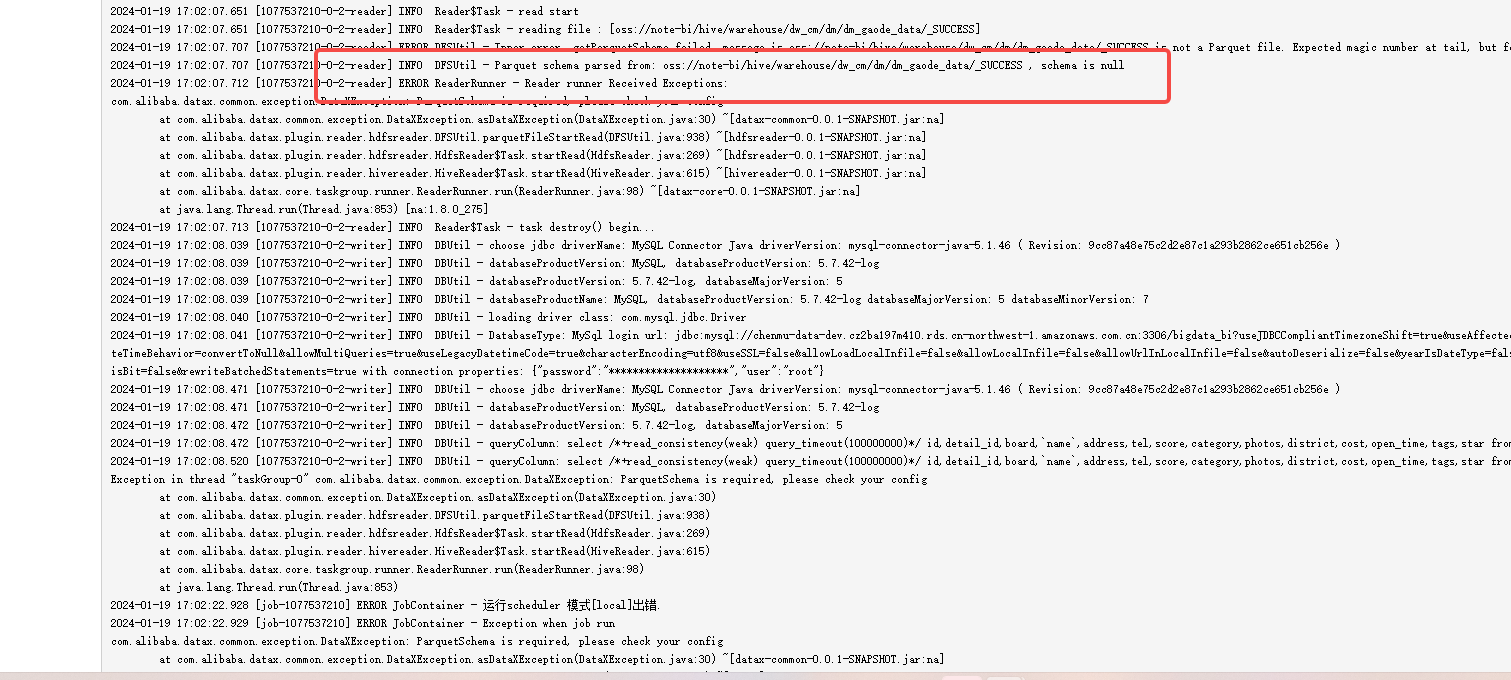

DataWorks报错问题之从hive到mysql报错如何解决

问题一:DataWorks目前数据集成支持的MongoDB数据版本有哪些? DataWorks目前数据集成支持的MongoDB数据版本有哪些? 参考答案: DataWorks目前支持的MongoDB数据版本包括4.x和5.x。 DataWorks是一个大数据开发与治理平台,它提供了丰富的数据集成功能...

Flink报错问题之flink-1.11写hive报错如何解决

问题一:JobManager responsible for xxx lost the leadersh JobManager responsible for ff2118284beed21ac220ee7cc0a639c0 lost the leadership. 这种错误原因是什么,会导致任务重...

Flink报错问题之使用hive udf函数报错如何解决

问题一:用flink 1.11.2 查询hive表自关联(self inner join) 结果不正确 我用相同的一个表自己 inner join 自己,取不同时间点,得到相同值 sql是这样,p5m 和 p0m 都是 snmpprobe.p_snmp_ifxtable 表,时间不同 select ...

Flink报错问题之写入Hive报错如何解决

问题一:flink sql消费kafka join普通表为何会性能爬坡? 大家好, flink sql消费kafka join普通表是会性能爬坡吗? 背景是flink 1.12.0 使用flink sql在yarn per-job发布,消费kafka topic=trades,然后join 数据库里...

[帮助文档] Dataphin代码任务报错Caused by: org.apache.hive.service.cli.HiveSQLException: Error while compiling statement: FAILED: ParseException line 3:28 cannot recognize input near 'AS' '"AAA"' ',' in selection target[KB:613625]

问题描述Dataphin代码任务报错Caused by: org.apache.hive.service.cli.HiveSQLException: Error while compiling statement: FAILED: ParseException line 3:28 cannot re...

[帮助文档] Dataphin自定义组件创建Hive自定义数据源,集成任务执行的时候报错连接数据库失败[KB:606830]

问题描述本文主要描述了Dataphin自定义组件创建Hive自定义数据源,集成任务执行的时候报错连接数据库失败的解决方法。问题原因数据源的链接地址格式不正确。解决方案正确格式如下:jdbc:hive2://{ip}:{port}/{db}适用于Dataphinv2.9.4.5

flink报错踩坑:org.apache.flink.table.catalog.hive.client.HiveShimV100.registerTemporaryFunction

出错场景当想使用本地开发环境运行flink读写线上hive数据来运行时报错。我使用maven管理的开发环境依赖。由于代码发布到测试环境集群上跑时并没有报错,而测试环境对应的依赖都是使用放在上面的依赖jar的,并不使用本地maven管理的依赖(也就是没有打入项目jar)。所以我猜测是本地运行环境依赖有...

[帮助文档] Dataphin从FTP同步数据到HIVE报错“您尝试读取的列越界,源文件该行有 [1] 列,您尝试读取第 [2] 列”[KB:604743]

问题描述用户从FTP同步数据到HIVE报错“您尝试读取的列越界,源文件该行有 [1] 列,您尝试读取第 [2] 列”。问题原因文件编码格式错误。解决方案检查文件编码格式,需要保持和选择的格式一样。适用于Dataphin列越界

[帮助文档] Dataphin管道任务同步数据,hive源表报错“ERROR DlinkTaskPluginCollector - 脏数据”[KB:604329]

问题描述Dataphin管道任务同步数据,hive源表报错“ERROR DlinkTaskPluginCollector - 脏数据”。问题原因hive源表字段数据中有单个双引号,导致同步时数据分割错了,抛出了“ERROR DlinkTaskPluginCollector - 脏数据”错误。解决方案...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。