[帮助文档] 售电子商务数仓搭建环境准备

为保证您可以顺利完成本次教程,您需要准备教程所需的MaxCompute引擎、DataWorks工作空间,并做好相关的环境配置。本文为您介绍进行本次实验所需的必要环境。

[帮助文档] 使用DataWorks进行任务开发前的环境准备工作

DataWorks是为您提供专业高效、安全可靠的一站式大数据开发与治理平台,使用其进行数据开发前,您需做好相关准备工作,保障后续开发任务可顺利执行。本文为您介绍DataWorks的购买及环境准备流程,帮助您快速开通DataWorks并准备所需开发环境。

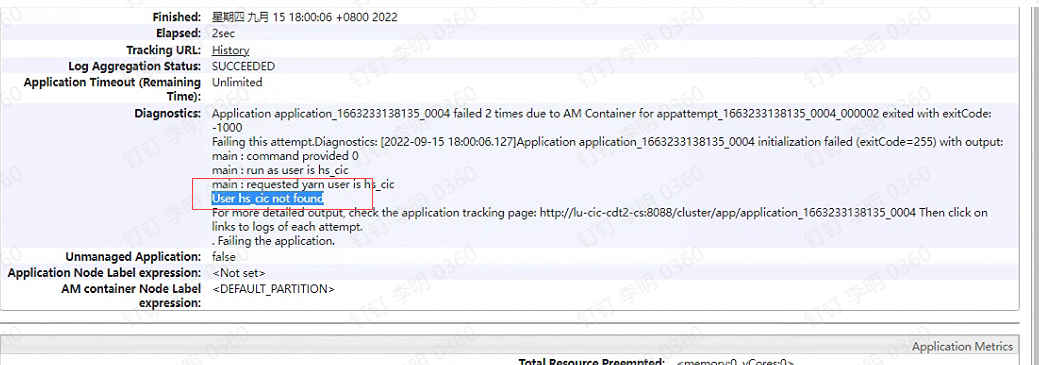

开启 Kerberos 安全的大数据环境中,Yarn Container 启动失败导致作业失败

大数据问题排查系列 - 开启 Kerberos 安全的大数据环境中,Yarn Container 启动失败导致 spark/hive 作业失败前言大家好,我是明哥!最近在若干个不同客户现场,都遇到了 大数据集群中开启 Kerberos 后,spark/hive 作业提交到YARN 后,因 YARN ...

[帮助文档] PySpark中的Python环境介绍

EMR DataLake和自定义集群安装的Spark版本对Python环境的依赖各不相同。本文以Python3为例,介绍不同Spark版本所对应的Python版本,以及安装Python第三方库的方法。

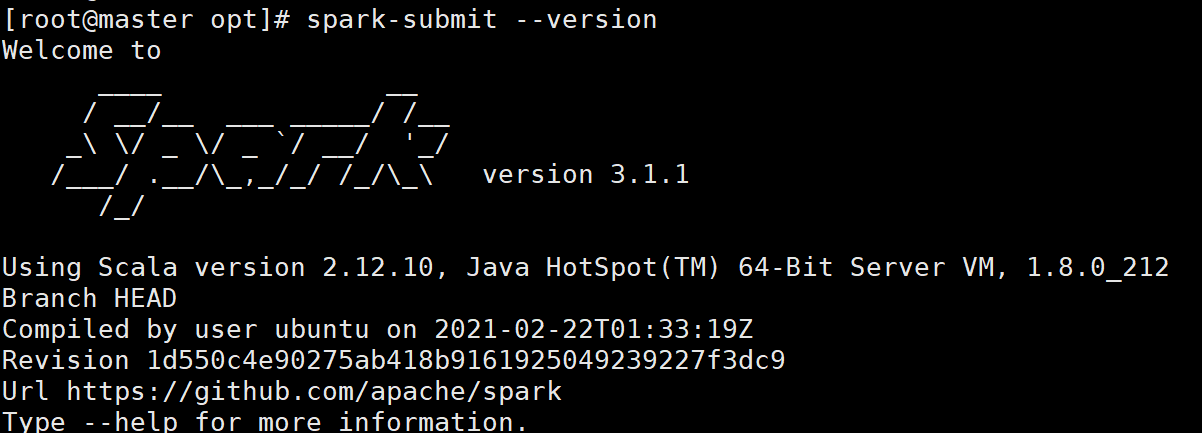

大数据平台搭建(容器环境)——Spark3.X on Yarn安装配置

Spark3.X on Yarn安装配置 一、解压 1. 将Spark包解压到路径/opt/module路径中 tar -zxvf /opt/software/spark-3.1.1-bin-hadoop3.2.tgz -C /opt/module/ 2. 改名(可不做) mv spark-3.1....

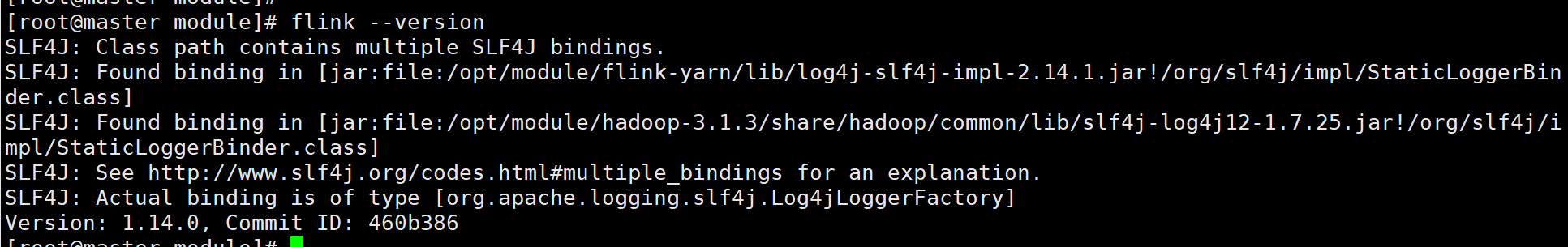

大数据平台搭建(容器环境)——Flink on Yarn安装配置

Flink on Yarn安装配置 一、解压 1. 将Flink包解压到路径/opt/module路径中 tar -zxvf /opt/software/flink-1.14.0-bin-scala_2.12.tgz -C /opt/module/ 2. 改名(可不做) mv flink-1.14....

[帮助文档] 如何实现开发生产等多套环境隔离

使用DataWorks进行大数据开发时,支持对开发、测试、生产等环境进行隔离,当您联合使用了其他阿里云产品时,也可根据环境隔离诉求进行对应业务的环境设置与隔离,本文以DataWorks联合EMR、OSS等产品为例,为您介绍如何实现开发生产等多套环境隔离。

[帮助文档] 如何在本地搭建Spark的调试环境(以IDEA为例)

本文为您介绍如何在本地搭建Spark的调试环境(以IDEA为例)。

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

云原生大数据计算服务 MaxCompute环境相关内容

- 环境云原生大数据计算服务 MaxCompute

- 云原生大数据计算服务 MaxCompute maxcompute环境

- 云原生大数据计算服务 MaxCompute dev环境

- 云原生大数据计算服务 MaxCompute部署环境

- 云原生大数据计算服务 MaxCompute安装环境

- 云原生大数据计算服务 MaxCompute环境配置

- 云原生大数据计算服务 MaxCompute环境开发

- 云原生大数据计算服务 MaxCompute组件环境

- 云原生大数据计算服务 MaxCompute环境hbase安装

- 云原生大数据计算服务 MaxCompute环境kafka

- 环境云原生大数据计算服务 MaxCompute引擎

- 云原生大数据计算服务 MaxCompute伪分布环境部署

- 云原生大数据计算服务 MaxCompute环境datax

- 云原生大数据计算服务 MaxCompute环境jdk

- mac构建云原生大数据计算服务 MaxCompute伪分布环境

- 云原生大数据计算服务 MaxCompute环境sqoop

- 云原生大数据计算服务 MaxCompute环境步骤

- 云原生大数据计算服务 MaxCompute环境方法

云原生大数据计算服务 MaxCompute您可能感兴趣

- 云原生大数据计算服务 MaxCompute期末

- 云原生大数据计算服务 MaxCompute adbmysql

- 云原生大数据计算服务 MaxCompute数据推送

- 云原生大数据计算服务 MaxCompute adb

- 云原生大数据计算服务 MaxCompute安装配置

- 云原生大数据计算服务 MaxCompute表格

- 云原生大数据计算服务 MaxCompute dataworks

- 云原生大数据计算服务 MaxCompute文件

- 云原生大数据计算服务 MaxCompute任务

- 云原生大数据计算服务 MaxCompute日志

- 云原生大数据计算服务 MaxCompute MaxCompute

- 云原生大数据计算服务 MaxCompute大数据计算

- 云原生大数据计算服务 MaxCompute数据

- 云原生大数据计算服务 MaxCompute sql

- 云原生大数据计算服务 MaxCompute分析

- 云原生大数据计算服务 MaxCompute应用

- 云原生大数据计算服务 MaxCompute阿里云

- 云原生大数据计算服务 MaxCompute技术

- 云原生大数据计算服务 MaxCompute表

- 云原生大数据计算服务 MaxCompute报错

- 云原生大数据计算服务 MaxCompute spark

- 云原生大数据计算服务 MaxCompute大数据

- 云原生大数据计算服务 MaxCompute计算

- 云原生大数据计算服务 MaxCompute同步

- 云原生大数据计算服务 MaxCompute hadoop

- 云原生大数据计算服务 MaxCompute查询

- 云原生大数据计算服务 MaxCompute平台

- 云原生大数据计算服务 MaxCompute项目