通过比喻理解-MapReduce的数据处理流程

通过比喻理解-MapReduce的数据处理流程什么是MapReduce我们把MapReduce比作一场大型的烹饪比赛。假设你是一位厨师,你的任务是为一场大型的宴会准备食物。你有很多的食材,比如土豆、胡萝卜和鸡肉等。但是,你一个人无法处理这么多的食材,所以你决定招募一些助手来帮助你。这就是MapRed...

MapReduce 的原理、流程【重要】

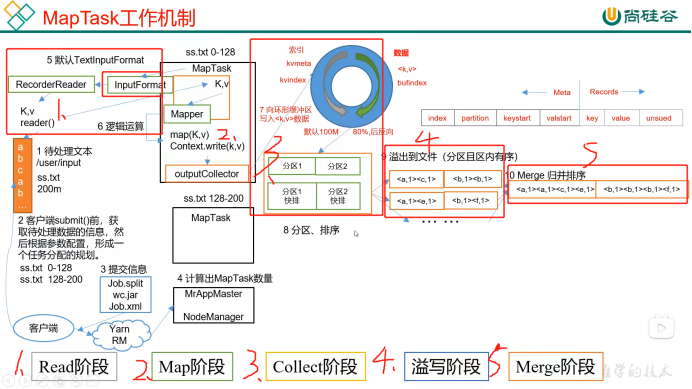

MapReduce 分为两个阶段,Map 阶段和 Reduce 阶段:MapTask 工作机制:首先是 Map 阶段,Map 有五个阶段:Read 阶段、Map 阶段、Collect 阶段、溢写阶段、Merge 阶段(1)Read 阶段:默认用 TextInputFormat 进行读取...

Mapreduce概念及流程介绍

Mapreduce框架:MapReduce过程MapReduce是采用一种分而治之的思想设计出来的分布式计算框架,它由两个阶段组成:map阶段和reduce阶段。在map阶段中:首先读取HDFS中的文件,每个文件都以一个个block形式存在,block中的数据会被解析成多个kv对,然后调用map t...

Hadoop中的MapReduce框架原理、Job提交流程源码断点在哪断并且介绍相关源码、切片与MapTask并行度决定机制、MapTask并行度决定机制

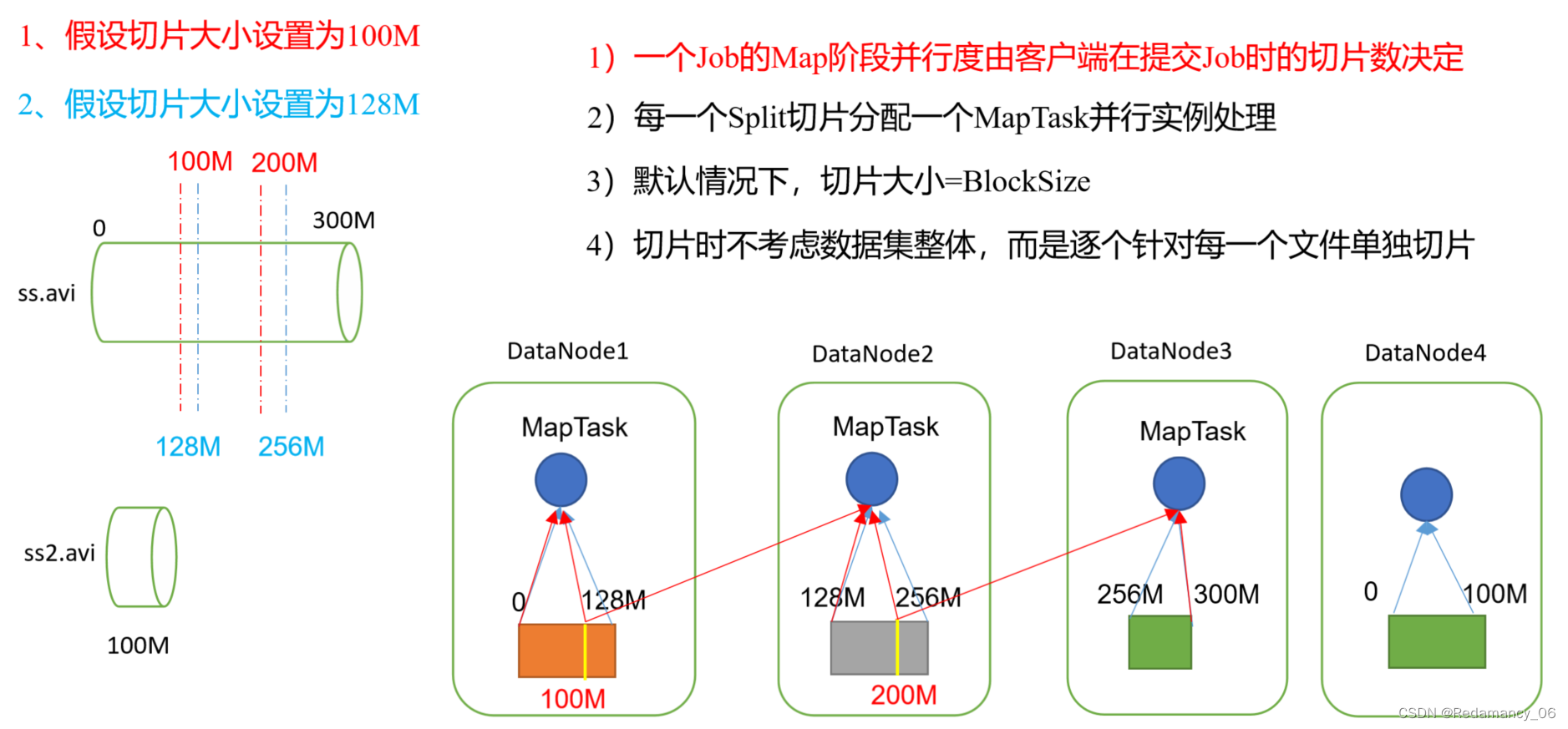

@[toc]13.MapReduce框架原理13.1InputFormat数据输入13.1.1切片与MapTask并行度决定机制13.1.1.1问题引出MapTask的并行度决定Map阶段的任务处理并发度,进而影响到整个Job的处理速度 思考:1G的数据,启动8个MapTask,可以提高集群的...

mapreduce的大致流程是什么?

mapreduce的大致流程是什么?

mapreduce 的大致流程

mapreduce 的大致流程

Hadoop MapReduce工作详细流程(Partitioner/SortComparator/GroupingComparator)

转自:http://blog.sina.com.cn/s/blog_7581a4c30102veem.html map阶段 1. 使用job.setInputFormatClass(TextInputFormat)做为输入格式。注意输出应该符合自定义Map中定义的输出。 2. 进入Mapper的ma...

MapReduce的数据流程、执行流程

MapReduce的数据流程: 预先加载本地的输入文件 经过MAP处理产生中间结果 经过shuffle程序将相同key的中间结果分发到同一节点上处理 Recude处理产生结果输出 将结果输出保存在hdfs上 MAP 在map阶段,使用job.setInputFormatClass定义的InputFo...

MapReduce源码分析之作业Job状态机解析(一)简介与正常流程浅析

作业Job状态机维护了MapReduce作业的整个生命周期,即从提交到运行结束的整个过程。Job状态机被封装在JobImpl中,其主要包括14种状态和19种导致状态发生的事件。 作业Job...

Yarn源码分析之MRAppMaster上MapReduce作业处理总流程(二)

本文继《Yarn源码分析之MRAppMaster上MapReduce作业处理总流程(一)》,接着讲述MapReduce作业在MRAppMaster上处理总流程,继上篇讲到作业初始化之后的作业启动,关于作业初始化主体流程的详细介绍,请参见《Yar...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

产品推荐

mapreduce流程相关内容

mapreduce您可能感兴趣

- mapreduce hive

- mapreduce oss

- mapreduce访问

- mapreduce配置

- mapreduce sdk

- mapreduce策略

- mapreduce优化

- mapreduce模型

- mapreduce编程

- mapreduce实战

- mapreduce hadoop

- mapreduce集群

- mapreduce hdfs

- mapreduce spark

- mapreduce maxcompute

- mapreduce程序

- mapreduce yarn

- mapreduce数据

- mapreduce运行

- mapreduce任务

- mapreduce wordcount

- mapreduce map

- mapreduce大数据

- mapreduce作业

- mapreduce案例

- mapreduce入门