Transformer 自然语言处理(一)

Transformer 自然语言处理(一)

【机器学习】Transformer:自然语言处理的巅峰之作

自然语言处理领域自从引入Transformer模型以来,经历了一场技术革命。Transformer不仅仅是一个模型,更是一种范式的颠覆,为自然语言处理技术的进步开创了新的时代。本文将深入剖析Transforme...

Transformers自然语言处理第一章 你好Transformer

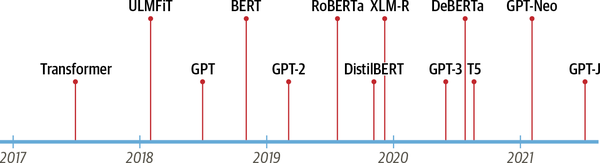

2017年,Google的研究人员发表了一篇论文,提出了一种新的用于序列建模(sequence modeling)的神经网络架构[1]。称之为Transformer,这种架构在机器翻译任务中的表现无论在翻译质量还是训练成本层面均优于循环神经网络(RNN)。 同时,一种称为ULMFiT的高效迁移学习方...

全领域涨点 | Transformer携Evolving Attention在CV与NLP领域全面涨点(文末送书)(二)

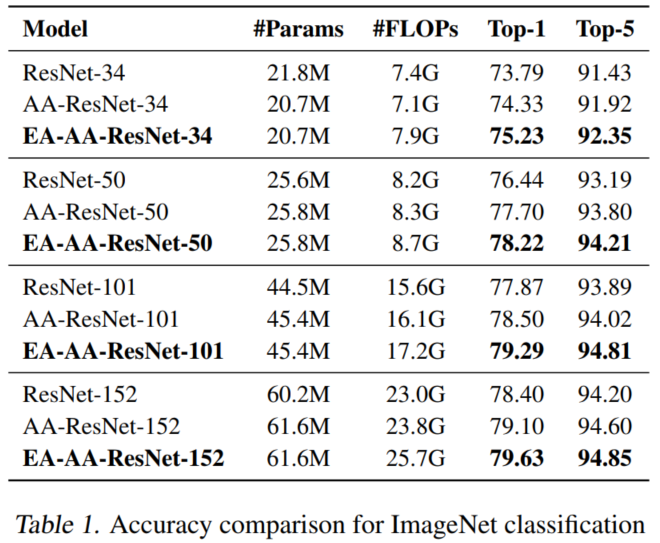

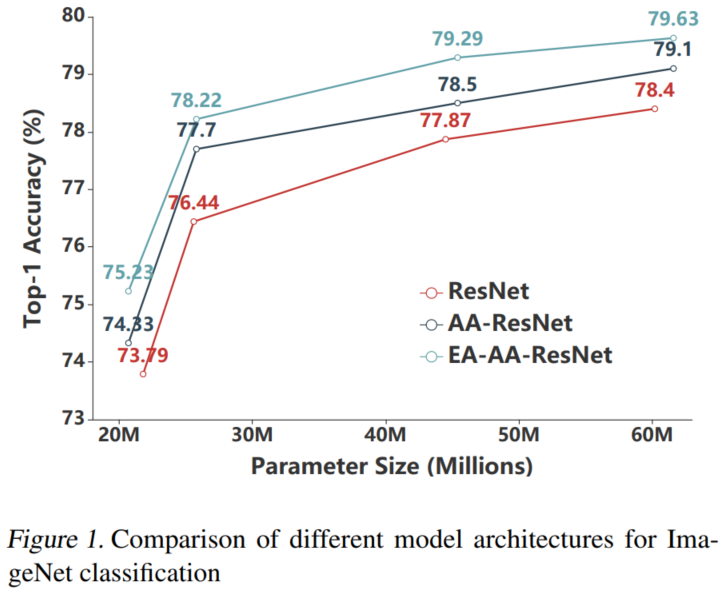

4. 实验4.1 图像分类如表1所示,AA-ResNet的表现始终明显优于相应的ResNet。在AAResNet-34、-50、-101和-152的基础上,EA-AA-ResNets的Top-1准确率分别提高了1.21%、0.67%、0.80%和0.67%。4.2 自然语言理解BERT-style模...

全领域涨点 | Transformer携Evolving Attention在CV与NLP领域全面涨点(文末送书)(一)

1 摘要Transformer是一种普遍存在于自然语言处理的模型,近期在计算机视觉领域引起了广泛关注。而Attention map主要用来编码input tokens之间的依赖关系,其对于一个Transformer模型来说是必不可少的。然而,它们在每一层都是独立学习的,有时无法捕获精确的模式。因此在...

NeurIPS 2022 | Meta 提出二值transformer网络BiT,刷新NLP网络压缩极限

神经网络压缩一直被视为机器学习模型从实验室走向工业应用中的不可或缺的一步,而量化 (quantization) 又是神经网络压缩中最常用的方法之一。今天这篇 NeurIPS 论文 BiT 从实验和理论验证了极端压缩情况下的 1-bit 的 BERT 网络也能在自然语言处理的分类数据集 GLUE 上取...

华为诺亚Transformer后量化技术:效率百倍提升,视觉&NLP性能不减

Transformer 在自然语言处理和视觉任务中取得了令人瞩目的成果,然而预训练大模型的推理代价是备受关心的问题,华为诺亚方舟实验室的研究者们联合高校提出针对视觉和 NLP 预训练大模型的后训练量化方法。在精度不掉的情况下,比 SOTA 训练感知方法提速 100 倍以上;量化网络性能也逼近训练感知...

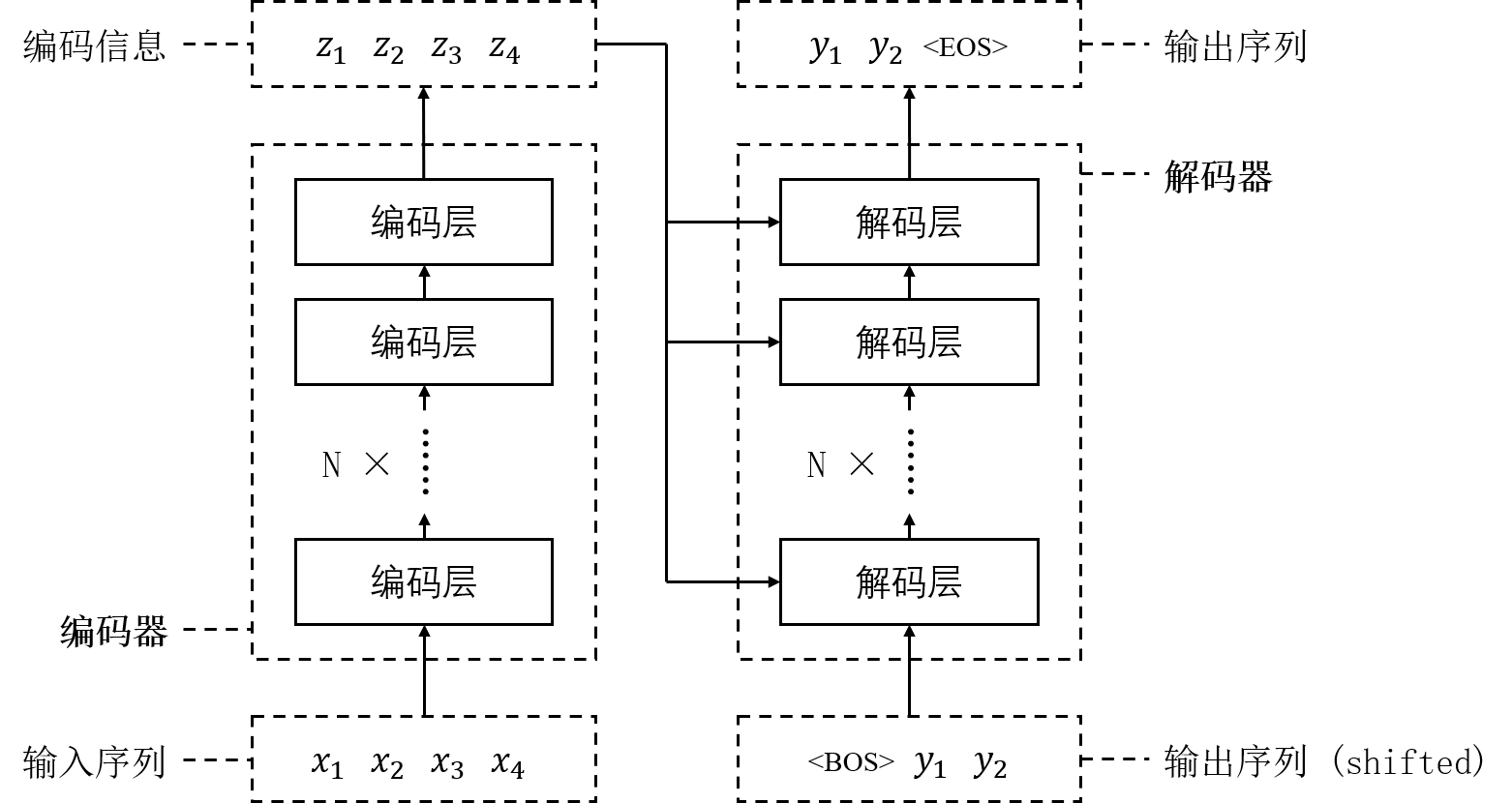

NLP学习笔记(六) Transformer简明介绍

前言大家好,我是半虹,这篇文章来讲 Transformer,想要获取更多相关文章,欢迎关注 自然语言处理 专栏正文在之前的两篇文章中,我们介绍过序列到序列模型以及注意力机制在序列到序列模型中的应用所谓序列到序列模型,就是那些输入是序列、输出也是序列的模型,这是从输入输出的角度来定义的这些模型通常会使...

自然语言处理Transformer模型最详细讲解(图解版)

前言近几年NLP较为流行的两大模型分别为Transformer和Bert,其中Transformer由论文《Attention is All You Need》提出。该模型由谷歌团队开发,Transformer是不同与传统RNN和CNN两大主流结构,它的内部是采用自注意力机制模块。该模型在WMT 2...

NLP情感分析笔记(六):Transformer情感分析

数据准备入库,设置随机种子# -*- codeing = utf-8 -*- import torch import random import numpy as np SEED = 1234 random.seed(SEED) np.random.seed(SEED) torch.manual_s...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。