新至强训练推理增效十倍,英特尔CPU加速AI更上一层楼

人工智能技术改变了我们的生活,而说到 AI 背后的算力,人们经常会先想到 GPU。从 2019 年英特尔为其第二代至强可扩展处理器增添了内置的深度学习加速技术后,原本定位通用计算的 CPU 芯片,也加入了为 AI 加速的行列。今天,代号为「Sapphire Rapids」的第四代至强可扩展处理器也在...

FastFormers 论文解读:可以使Transformer 在CPU上的推理速度提高233倍

自Transformers诞生以来,紧随其后的是BERT,在几乎所有与语言相关的任务中,无论是问题回答,情感分析,文本分类还是文本生成,都占据着NLP的主导地位。与RNN和LSTM消失的梯度问题(不影响长数据序列的学习)不同,Transformers在所有这些任务上的准确...

GPU相比CPU并没有明显提高uniasr语音识别和语音合成的推理速度

经测试发现,相同配置条件下(阿里云线上notebook),同样的识别和合成代码,在cpu配置下,运行语音识别耗时平均在400ms ~ 500ms,语音合成的耗时平均在700ms-900ms,切换成gpu配置环境,相比cpu并没有明显提升,识别相差不超过100ms,合成相差不超过200ms,是gpu只...

cpu(gpu)资源消耗过高,无法支撑并发推理

很多训练模型都存在一个问题,就是资源消耗过大,而且无法有效多并发推理,经测试,语音识别和语音合成,多并发情况下(2并发~20并发),随着并发增加,推理耗时就会呈线性趋势增加,比如同等条件下,一个并发耗时400ms,如果并发加到10,单次最大耗时将增加到4秒左右,增加到20并发,则耗时增加到8秒左右,...

你好,我使用【FRCRN语音降噪-单麦-16k】这个模型 cpu 推理较慢

你好,我使用【FRCRN语音降噪-单麦-16k】这个模型 cpu 推理较慢。 环境:windows 11 dockerDesktop ubuntu镜像 Q : 我在使用推理的时候,发现四五秒的音频推理需要20多秒,但是官方给出的demo 只需要0.3s。 我试用了 NoteBook 的GPU版本和C...

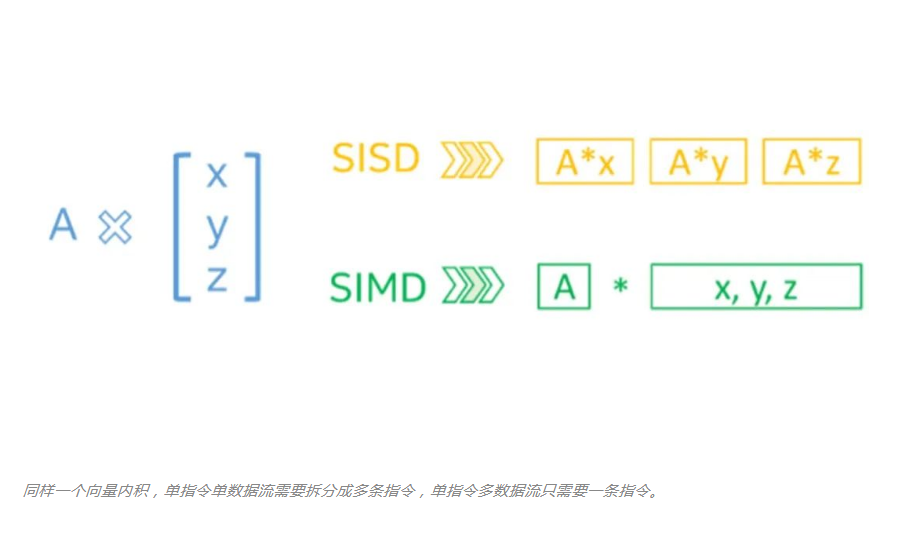

现在都2202年了,用CPU做AI推理训练到底能不能行?

说到模型训练,很多算法工程师首先想到的就是各种深度学习框架,以及 CUDA、cuDNN、NCCL 等 GPU 训练环境,似乎我们很少优先考虑在 CPU 上直接训练模型。这可能是在潜意识里,我们将 CPU 视为不适合并行计算的设备,思考着,也许 CPU 训练模型不仅速度慢,同时内存等资源占用也不少。但...

CPU推理性能优化再上新台阶 阿里云斩获MLPerf最新榜单多项第一

【阅读原文】戳:CPU推理性能优化再上新台阶 阿里云斩获MLPerf最新榜单多项第一近日,全球权威AI基准评测组织MLCommons公布了最新一期推理性能榜单,阿里云震旦异构计算加速平台以其稳定、强大的软硬协同优化能力,结合磐久服务器M系列自研芯片和整体系统的领先性、RISC-V玄铁C906处理器功...

MNN推理引擎最新实测,CPU、GPU性能全面领先!

每当有深度学习框架开源时,我们也和广大的吃瓜群众一样,期冀着是不是能有一波新的浪潮,把端侧AI托上一个新的高度。但同时,出于同行们对MNN的认可,我们几乎每一次都会在对比的榜单上出镜,有时甚至是唯一竞对。高处不胜寒哪。 在正文之前,要先赞扬一下腾讯的开源精神。2017年,NCNN吹响了国内引擎开源的...

英伟达发布TensorRT 3可编程推理加速器,比起CPU能实现高达40倍吞吐率

北京时间9月26日,在英伟达GPU技术峰会上,英伟达创始人兼CEO黄仁勋正式发布TensorRT 3 神经网络推理加速器。据官方介绍,TensorRT 3能极大改善处理性能,削减从云到边缘设备(自动驾驶汽车、机器人等)的推理开销。TensorRT 3 是在Volta GPU 实现最优推理性能的关键,...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。