【Deep Learning A情感文本分类实战】2023 Pytorch+Bert、Roberta+TextCNN、BiLstm、Lstm等实现IMDB情感文本分类完整项目(项目已开源)

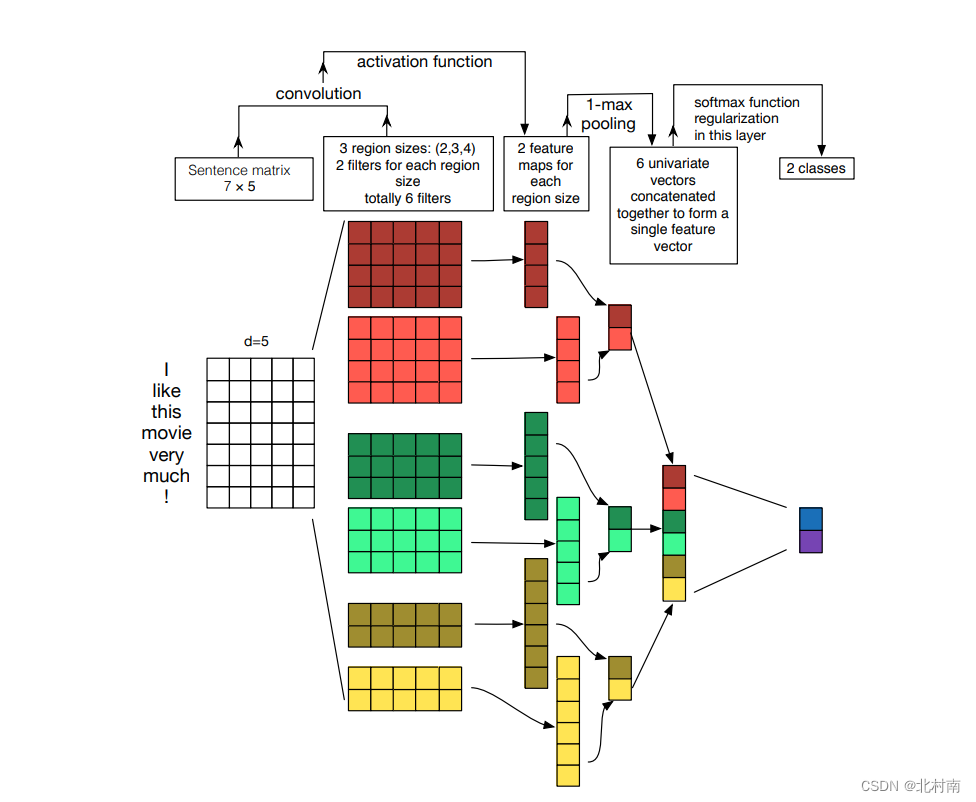

编辑 🍊作者最近在看了大量论文的源代码后,被它们干净利索的代码风格深深吸引,因此也想做一个结构比较规范而且内容较为经典的任务🍊本项目使用Pytorch框架,使用上游语言模型+下游网络模型的结构实现IMDB情感分析🍊语言模型可选择Bert、Roberta🍊主神经网络模型...

【多标签文本分类】MSML-BERT模型的层级多标签文本分类方法研究

·阅读摘要: 本文在BERT模型上,提出了利用多任务架构来解决层级多标签文本分类问题。·参考文献: [1] MSML-BERT模型的层级多标签文本分类方法研究[0] 摘要 在摘要中,作者主要给出了本篇论文的创新点: 1、多任务学习架构 2、多尺度特征抽取模块 3、多层...

【多标签文本分类】BERT for Sequence-to-Sequence Multi-Label Text Classification

·阅读摘要: 本文在已有的SGM和BERT模型上改进,提出了SGM+BERT模型、混合模型。实验证明SGM+BERT模型收敛比BERT快很多,混合模型的效果最好。·参考文献: [1] BERT for Sequence-to-Sequence Multi-Label Text...

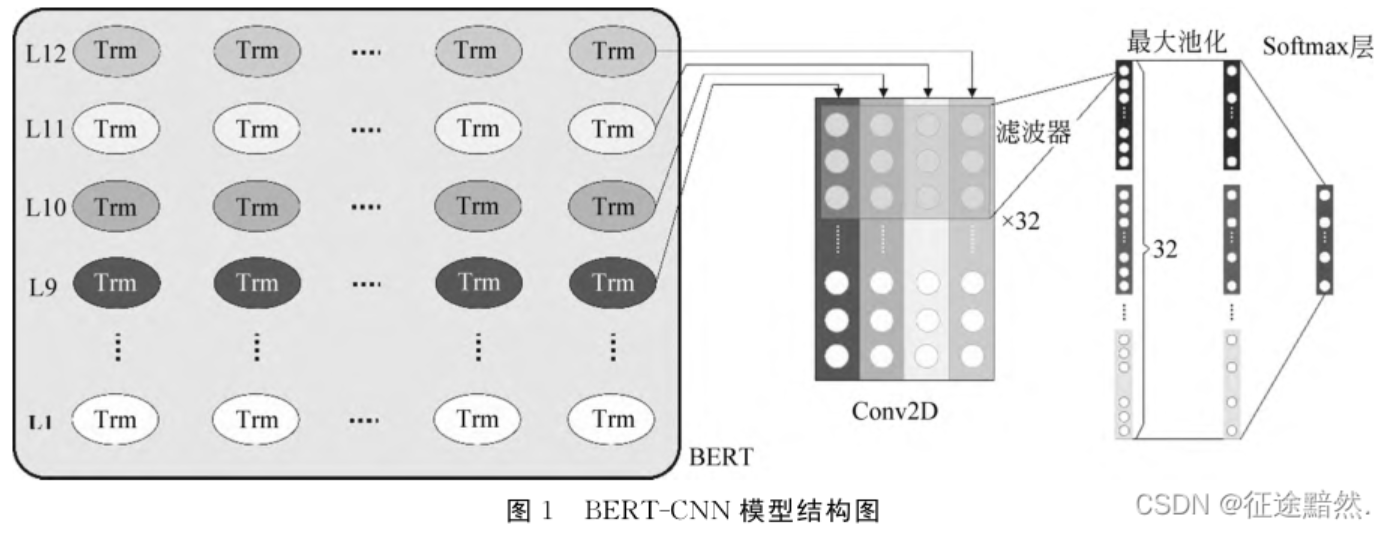

【文本分类】基于预训练语言模型的BERT-CNN多层级专利分类研究

·阅读摘要: 本文利用BERT的预训练数据,结合CNN,应用于专利分类。由于专利的特性,本文还提出使用多层级方法来增强模型。(文章发表在《中文信息学报》,核心期刊)·参考文献: [1]陆晓蕾,倪斌.基于预训练语言模型的BERT-CNN多层级专利分类研究[J].中文信息学报,2...

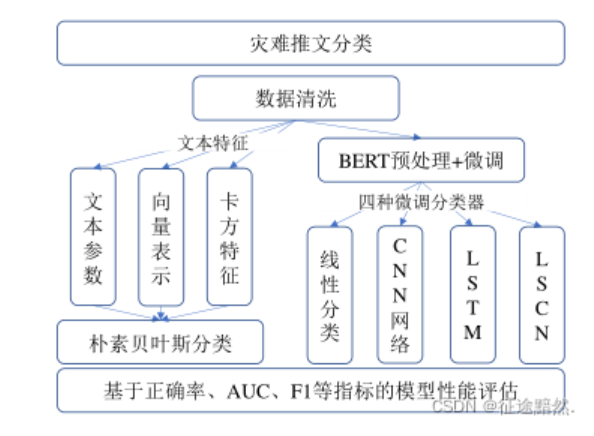

【文本分类】基于BERT预训练模型的灾害推文分类方法、基于BERT和RNN的新闻文本分类对比

·阅读摘要: 两篇论文,第一篇发表于《图学学报》,《图学学报》是核心期刊;第二篇发表于《北京印刷学院学报》,《北京印刷学院学报》没有任何标签。·参考文献: [1]林佳瑞,程志刚,韩宇,尹云鹏.基于BERT预训练模型的灾害推文分类方法[J/OL].图学学报:1-8[2022-01-17]....

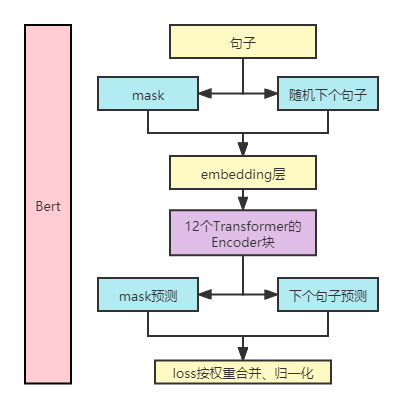

【文本分类】BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

·阅读摘要: Bert是继Transformer之后的又一杰出的模型。Bert是一种预训练语言模型,是在GPT、Elmo、Transformer的基础上提出的。基于Bert的多个NLP领域任务都取得了非常大的提升。·参考文献: [1] BERT: Pre-training o...

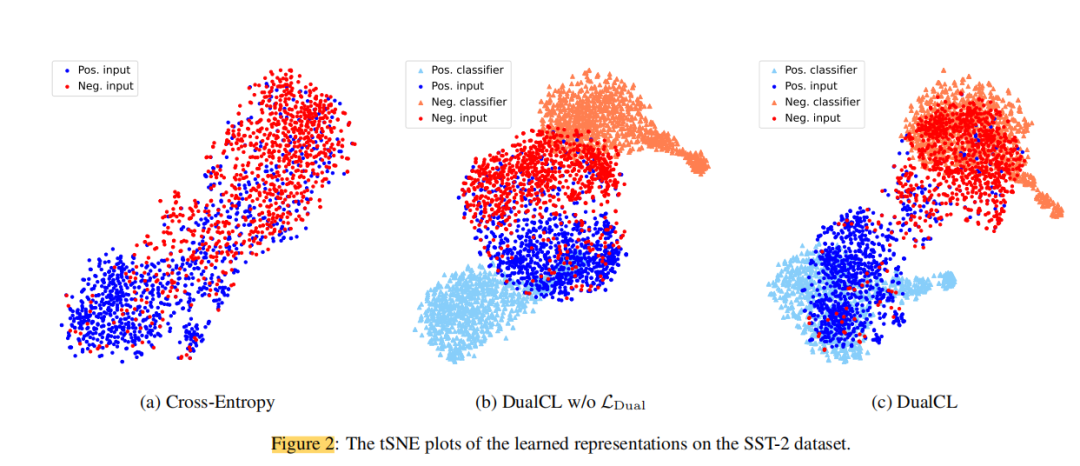

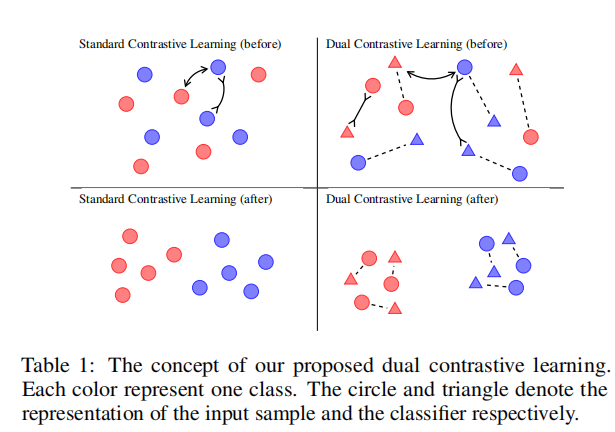

文本分类还停留在BERT?对偶比学习框架也太强了

论文摘要对比学习在无监督环境下通过自我监督进行表征学习方面取得了显著的成功。然而,有效地使对比学习适应于监督学习任务在实践中仍然是一个挑战。在这项工作中,作者提出了一个对偶对比学习(DualCL)框架,在同一空间内同时学习输入样本的特征和分类器的参数。具体来说,DualCL将分类器的参数视为关联到不...

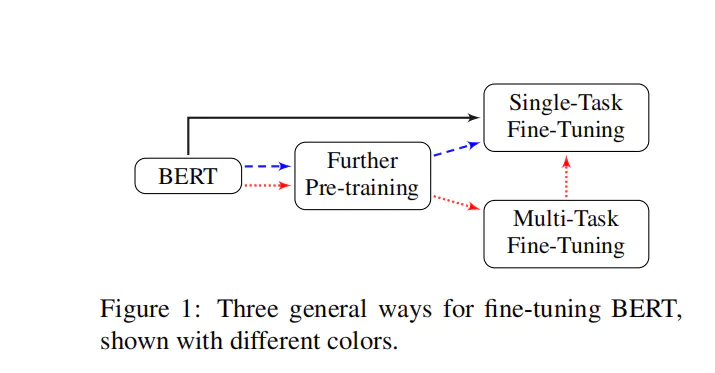

【论文解读】文本分类上分利器:Bert微调trick大全

论文标题:How to Fine-Tune BERT for Text Classification?中文标题:如何微调 BERT 进行文本分类?论文作者:复旦大学邱锡鹏老师课题组实验代码:https://github.com/xuyige/BERT4doc-Classification前言大家现在...

文本分类还停留在BERT?对偶对比学习框架也太强了(二)

实验结果从结果中可以看出,除了使用RoBERTa的TREC数据集外,同时使用BERT和RoBERTa编码器在几乎所有设置中都取得了最好的分类性能。与具有完整训练数据的CE+CL相比,DualCL对BERT和RoBERTa的平均改善率分别为0.46%和0.39%。此外,我们观察到,在10%的训练数据下...

文本分类还停留在BERT?对偶对比学习框架也太强了(一)

论文简介:对偶对比学习:如何将对比学习用于有监督文本分类论文标题:Dual Contrastive Learning: Text Classification via Label-Aware Data Augmentation论文链接:https://arxiv.org/pdf/1905.09788...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。