NLP中的RNN、Seq2Seq与attention注意力机制(下)

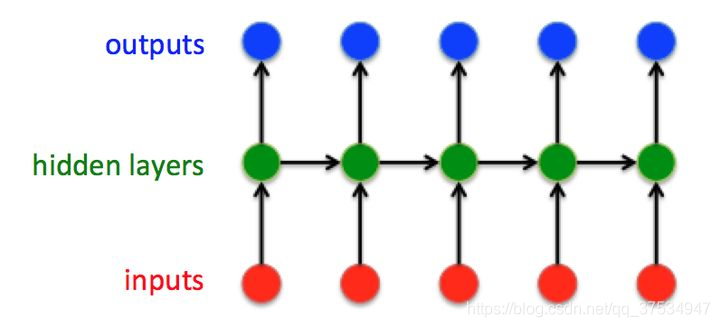

NLP中的RNN、Seq2Seq与attention注意力机制(上):https://developer.aliyun.com/article/1471380 展开 RNN 在每个时间步取出 RNN 的隐藏单元并复制。时间步中的每一次复制就像前馈网络中的一层。在时间步 t+1 中每个时间步 t 层与...

NLP中的RNN、Seq2Seq与attention注意力机制(上)

NLP自然语言处理 的RNN、Seq2Seq与attention注意力机制 RNN循环神经网络 我们为什么需要 RNN? 也许你现在想的是,已经有像卷积网络这样表现非常出色的网络了,为什么还需要其他类型的网络呢?有一个需要用到 RNN 的特殊例子。为了解释 RNN,...

初步了解RNN, Seq2Seq, Attention注意力机制

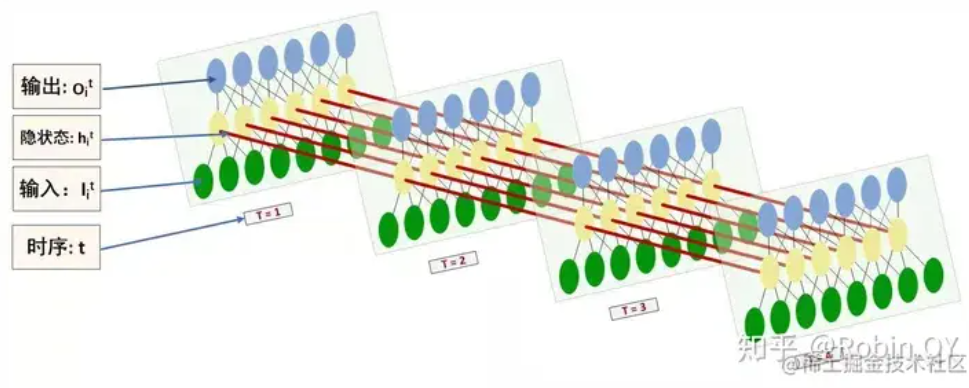

循环神经网络RNN结构被广泛应用于自然语言处理、机器翻译、语音识别、文字识别等方向。本文主要介绍经典的RNN结构,以及RNN的变种(包括Seq2Seq结构和Attention机制)。希望这篇文章能够帮助初学者更好地入门。1.经典的RNN结构这就是最经典的RNN结构,它的输入是:输出为:也就是说,输入...

完全图解RNN、RNN变体、Seq2Seq、Attention机制

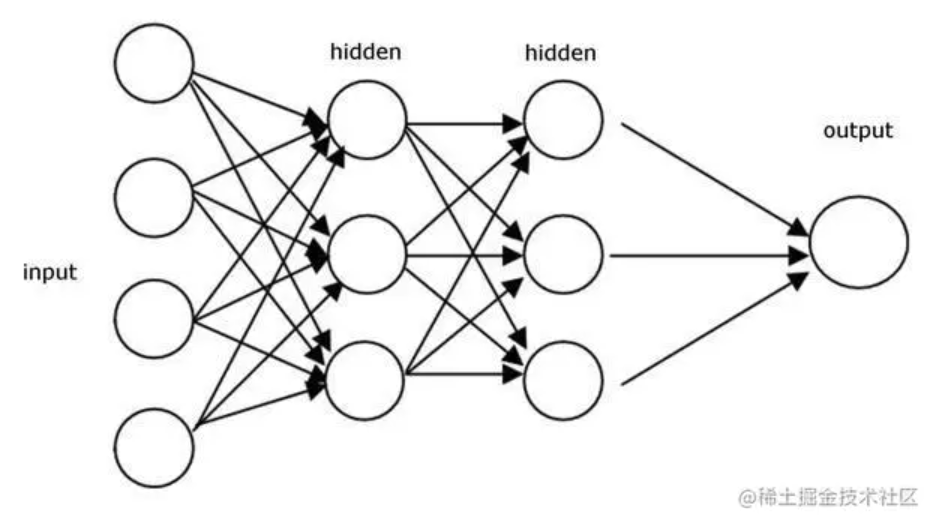

本文主要是利用图片的形式,详细地介绍了经典的RNN、RNN几个重要变体,以及Seq2Seq模型、Attention机制。希望这篇文章能够提供一个全新的视角,帮助初学者更好地入门。 一、从单层网络谈起 在学习RNN之前,首先要了解一下最基本的单层网络,它的结构如图: 输入是x,经过变换Wx+b和激活函...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。