请教一个问题,flink写hdfs文件的时候,文件格式设置为parquet,这个怎么解决啊?

请教一个问题,flink写hdfs文件的时候,文件格式设置为parquet,压缩方式为GZIP,存在一个问题,如果开启文件合并的话,最终的文件不能通过hive映射读取,如果不开启的话,可以正常读取,这个怎么解决啊?

使用云上的Flink读取本地的HDFS,是否有什么配置,可以把读取HDFS的用户设置成hive ?

使用云上的Flink读取本地的HDFS,目前直接读取HDFS是通过Flink用户,是否什么配置,可以把读取HDFS的用户设置成hive或者hadoop?

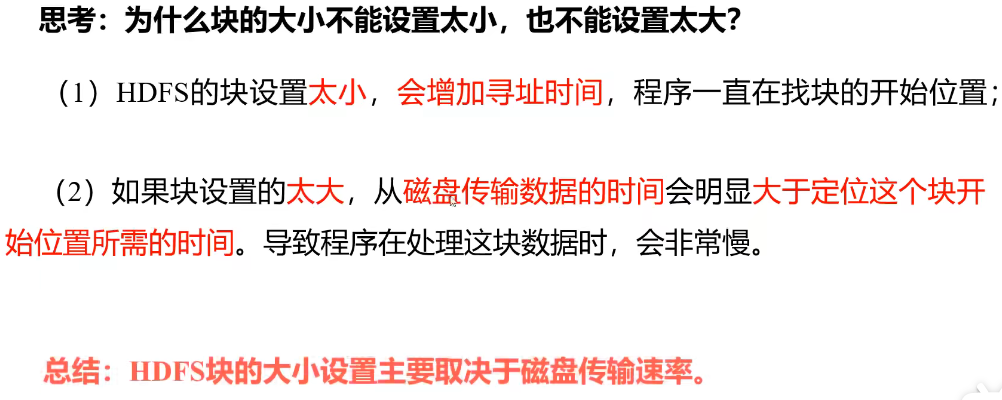

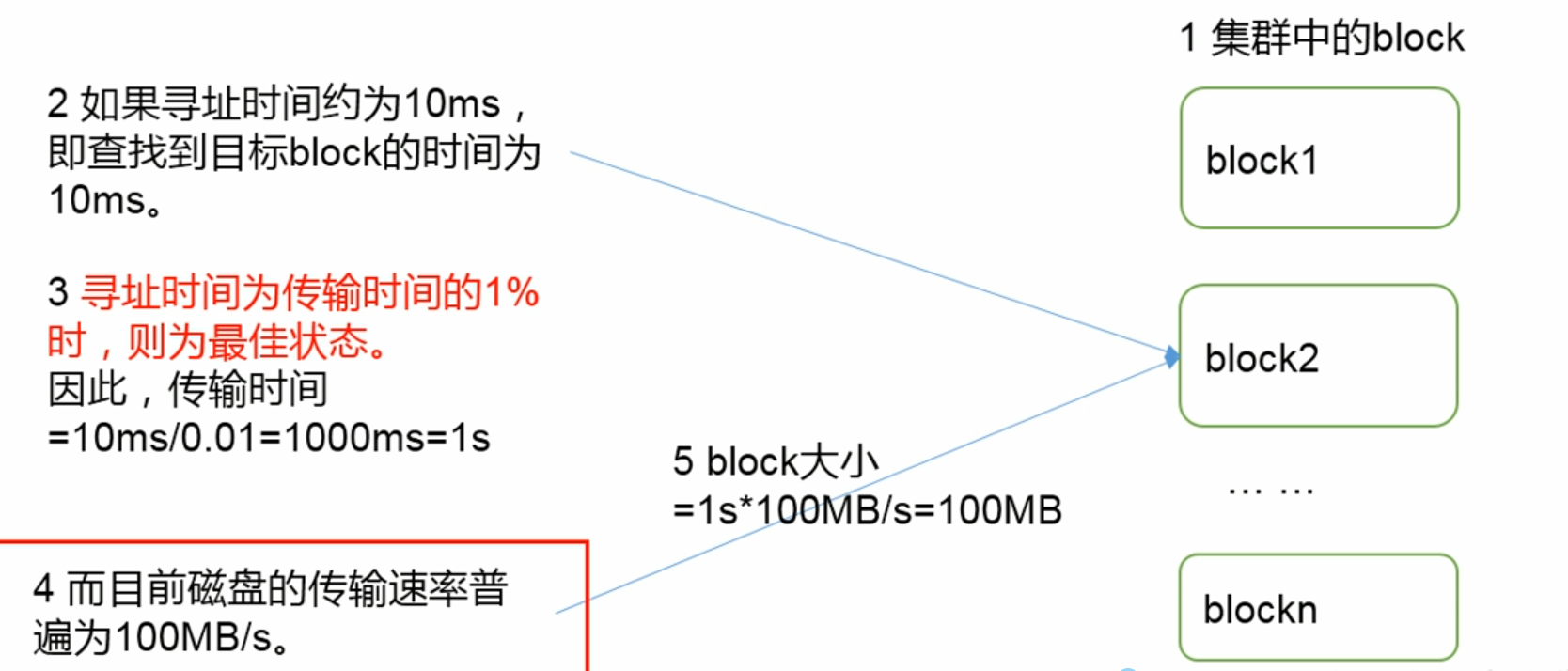

HDFS 文件块的大小为什么不能设置太小、也不能设置太大?

把大的文件块切分成一个个小的文件块,有利于并发传输,所以传输速度快,文件块太大的话,不能并发传输,一个文件太大,所以传输速率很慢。(正常查找块的时间为传输块数据的 1%)普通的磁盘传输速率为 100MB/S,好的磁盘传输速率为 200-300MB/S,一般小...

大家好。 flink1.15.2使用hdfs的filesystem做存储,现在对state设置?

大家好。 flink1.15.2使用hdfs的filesystem做存储,state backend为EmbeddedRocksDBStateBackend。 现在对state设置ttl,报这个错? 请问有人遇到过吗?怎么解决的?

FileSink 往hdfs上写入数据,怎么设置 Configuration的参数?找了好久 没找到

FileSink 往hdfs上写入数据,怎么设置 Configuration的参数?找了好久 没找到在哪设置的,有大佬 知道么

flinkcdc直接写入HDFS设置好的分区文件夹,hive要如何读取呢?

flinkcdc直接写入HDFS设置好的分区文件夹,hive要如何读取呢?

HDFS设置BLOCK的目的

HDFS设置BLOCK的目的在HDFS里面,data node上的块大小默认是64MB(或者是128MB或256MB)问题: 为什么64MB(或128MB或256MB)是最优选择?为什么不能远少于64MB(或128MB或256MB) (普通文件系统的数据块大小一般为4KB)减少硬盘寻道时间(disk...

配置 HDFS-创建 Kerberos 对应的账户设置 Keytab 文件|学习笔记

开发者学堂课程【快速掌握 Hadoop 集成 Kerberos 安全技术:配置 HDFS-创建 Kerberos 对应的账户设置 Keytab 文件】学习笔记,与课程紧密联系,让用户快速学习知识。课程地址:https://developer.aliyun.com/learning/course/70...

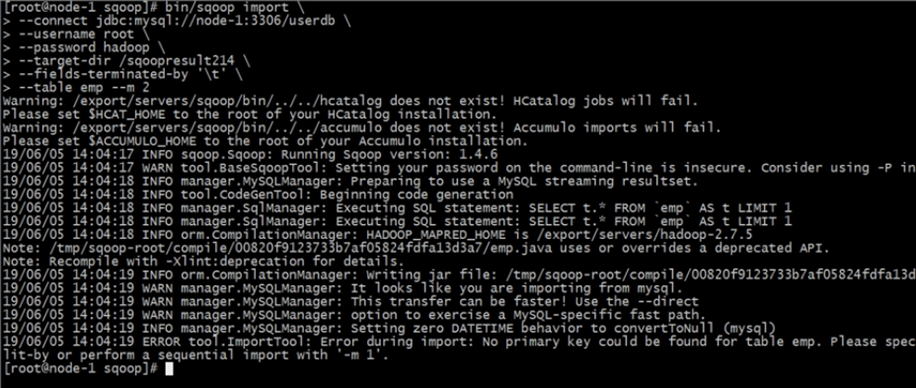

导入 Import--全量数据导入 Hdfs--并行度设置&注意事项 | 学习笔记

开发者学堂课程【Sqoop 企业级大数据迁移方案实战:导入 Import--全量数据导入 Hdfs--并行度设置&注意事项】学习笔记,与课程紧密联系,让用户快速学习知识。课程地址:https://developer.aliyun.com/learning/course/718/det...

HDFS 块的大小设置| 学习笔记

开发者学堂课程【Hadoop 分布式文件系统 HDFS:HDFS 块的大小设置】学习笔记,与课程紧密联系,让用户快速学习知识。课程地址:https://developer.aliyun.com/learning/course/93/detail/1436HDFS块的大小设置内容介绍:一、 ...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

产品推荐

社区圈子

文件存储HDFS版设置相关内容

文件存储HDFS版您可能感兴趣

- 文件存储HDFS版大数据

- 文件存储HDFS版绑定

- 文件存储HDFS版nas

- 文件存储HDFS版容器

- 文件存储HDFS版性能

- 文件存储HDFS版挂载

- 文件存储HDFS版flink

- 文件存储HDFS版文件

- 文件存储HDFS版parquet

- 文件存储HDFS版hadoop

- 文件存储HDFS版数据

- 文件存储HDFS版操作

- 文件存储HDFS版api

- 文件存储HDFS版命令

- 文件存储HDFS版存储

- 文件存储HDFS版集群

- 文件存储HDFS版hive

- 文件存储HDFS版java

- 文件存储HDFS版分布式文件系统

- 文件存储HDFS版架构

- 文件存储HDFS版目录

- 文件存储HDFS版文件存储

- 文件存储HDFS版配置

- 文件存储HDFS版读取

- 文件存储HDFS版原理

- 文件存储HDFS版学习笔记